一、Docker原理

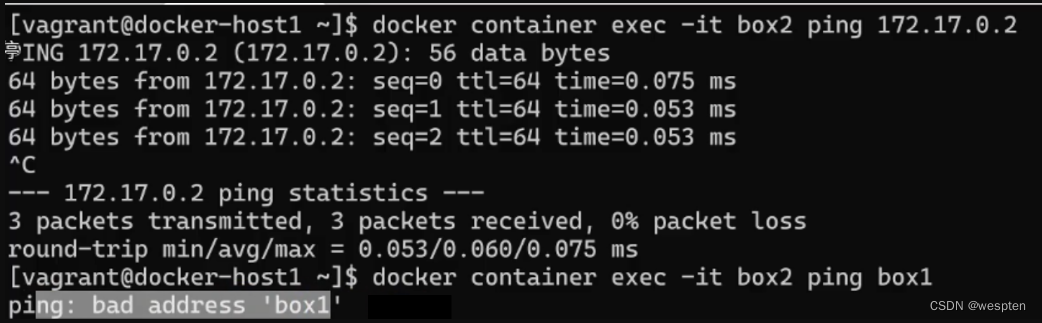

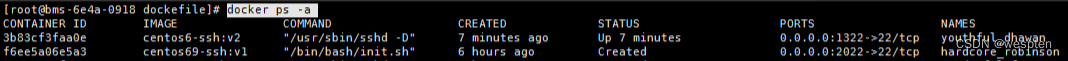

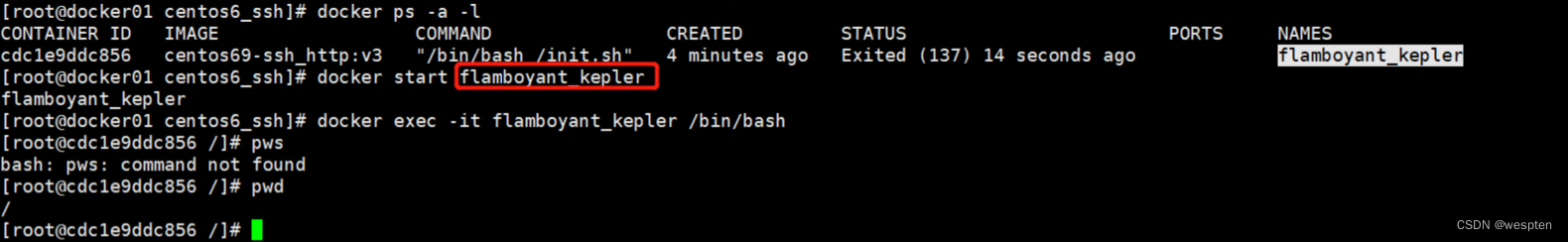

1、Docker简介

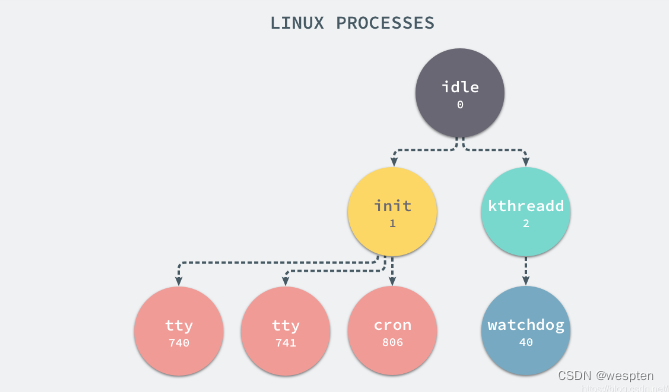

我们知道进程是Linux操作系统执行任务的最小单元,一个时间同步服务是一个进程,一个Java服务是一个进程,一个Nginx服务是一个主进程+若干工作进程,总之,把一个系统比作一个办公室,进程就是一个个打工人:

正常情况下,一个进程是能感知到其他进程的存在的,正如一个打工人放眼望去,办公室里还坐着一群其他打工人。进程的唯一标识是进程ID,用数字1、2、3……表示,好比打工人的工牌号,大家都各不一样。

而容器技术首先要解决的就是进程的隔离,即一个进程在运行的时候看不到其他进程。如何让一个打工人在工作时看不到其他打工人呢?方法是给这个打工人带一个VR眼镜,于是他看到的不是一个真实的办公室,而是一个虚拟的办公室。在这个虚拟办公室中,只有他一个打工人,没有别人。在Linux系统中,对一个进程进行隔离,主要是通过Namespace和Cgroup两大机制实现的。一个被隔离的进程,操作系统也会正常分配进程ID,比如12345,但是隔离进程自己看到的ID总是1,好比打工人的工牌是12345,但他自己通过VR眼镜看到的工牌号却是1,感觉自己是1号员工似的:

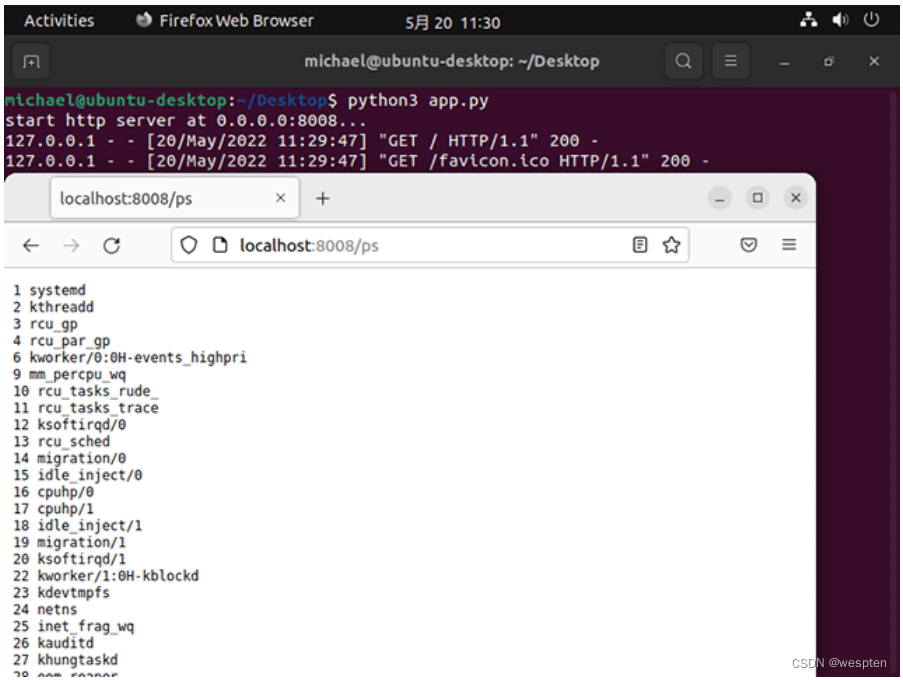

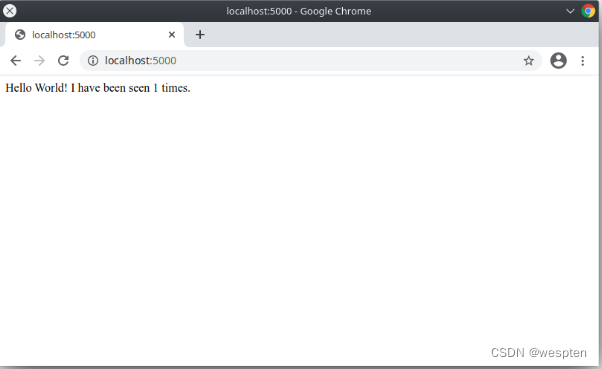

我们通过一个简单的Python程序就可以验证一下隔离进程的特点。我们编写一个简单的HTTP服务程序,针对URL为/、/ps、/ls分别返回自身进程ID、所有进程ID和磁盘根目录列表。如果我们正常启动某个Python程序,在浏览器中,可以看到进程ID为10297:

用/ps查看所有进程,可以看到1号进程是systemd,还有很多其他进程:

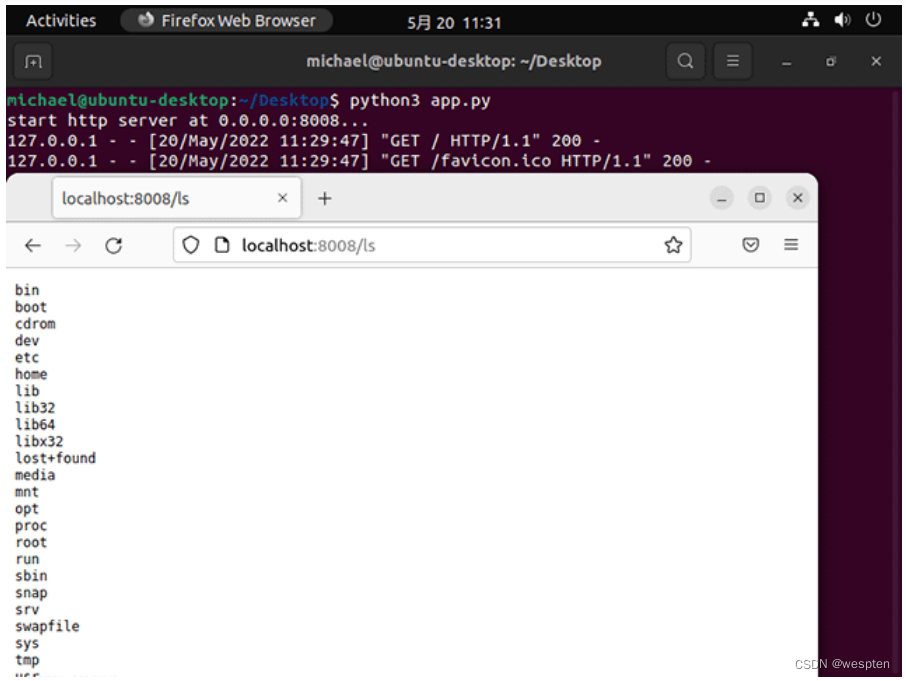

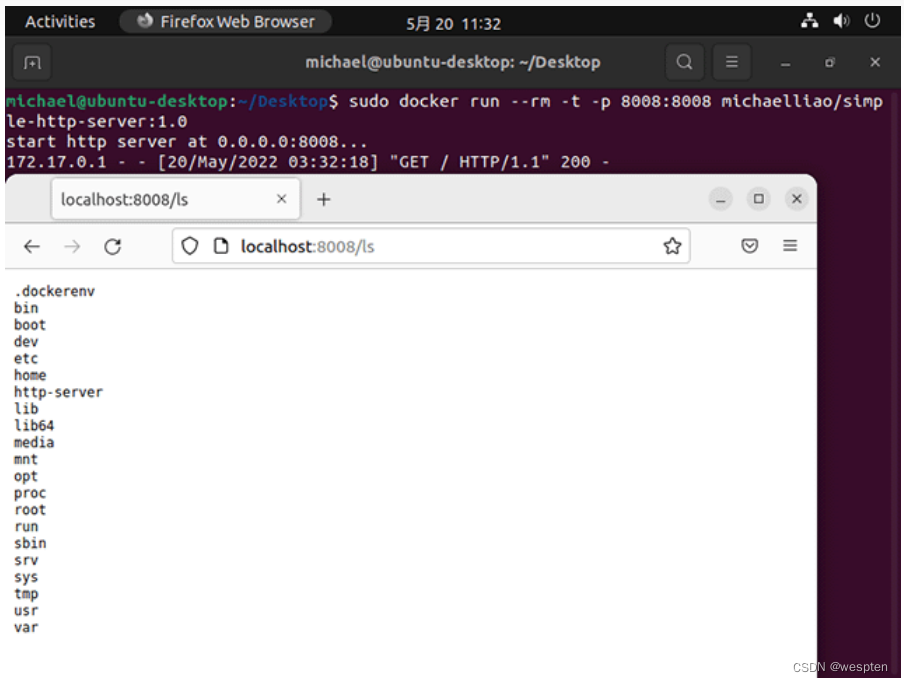

用/ls查看磁盘根目录,与当前系统根目录一致:

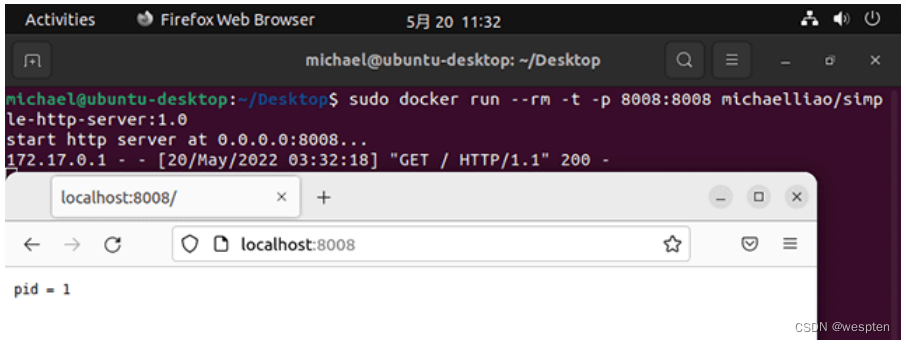

现在,我们制作一个Docker镜像,然后以Docker模式启动这个Python服务程序,再看看进程ID:

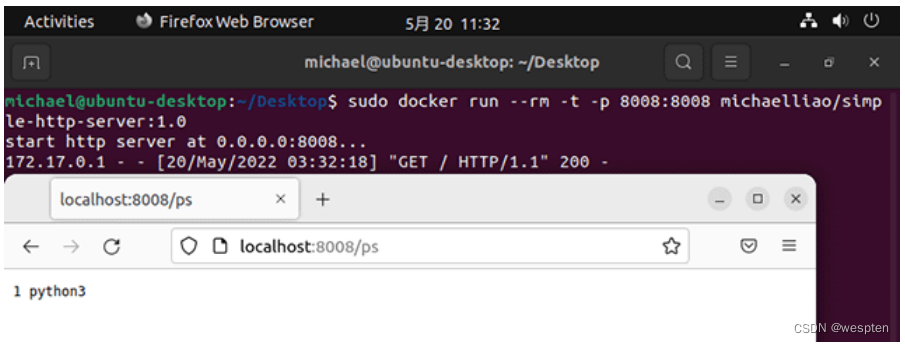

从进程自己的视角看,它看到的进程ID总是1,并且,用/ps看不到其他进程,只能看到自己:

再用/ls看一下磁盘,看到的也不是系统的根目录,而是Docker给挂载的一个虚拟的文件系统:

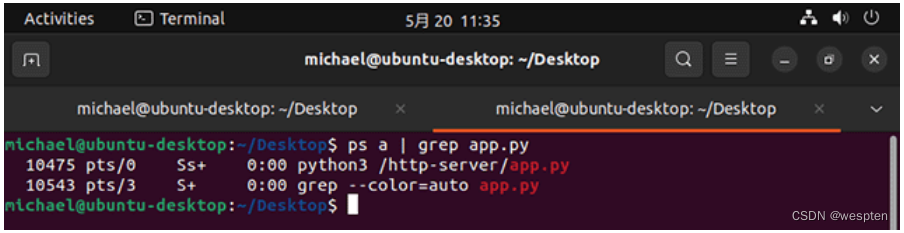

但其实从操作系统看,这个Docker进程和其他进程一样,也有一个唯一的进程ID为10475:

所以我们可以得出结论:

一个容器进程本质上是一个运行在沙盒中的隔离进程,由Linux系统本身负责隔离,Docker只是提供了一系列工具,帮助我们设置好隔离环境后,启动这个进程。

第一种隔离就是进程之间看不到彼此,这是由Linux的Cgroup机制实现的。进程隔离的结果就是以隔离方式启动的进程看到的自身进程ID总是1,且看不到系统的其他进程。

第二种隔离就是隔离系统真实的文件系统。

Docker利用Linux的mount机制,给每个隔离进程挂载了一个虚拟的文件系统,使得一个隔离进程只能访问这个虚拟的文件系统,无法看到系统真实的文件系统。至于这个虚拟的文件系统应该长什么样,这就是制作Docker镜像要考虑的问题。比如我们的Python程序要正常运行,需要一个python3解释器,需要把用到的第三方库如psutil引入进来,这些复杂的工作被简化为一个Dockerfile,再由Docker把这些运行时的依赖打包,就形成了Docker镜像。我们可以把一个Docker镜像看作一个zip包,每启动一个进程,Docker都会自动解压zip包,把它变成一个虚拟的文件系统。

第三种隔离就是网络协议栈的隔离,这个最不容易理解。

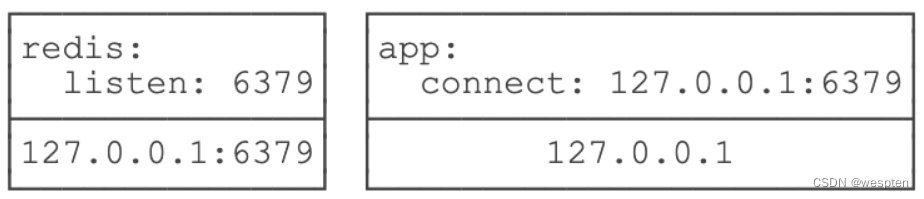

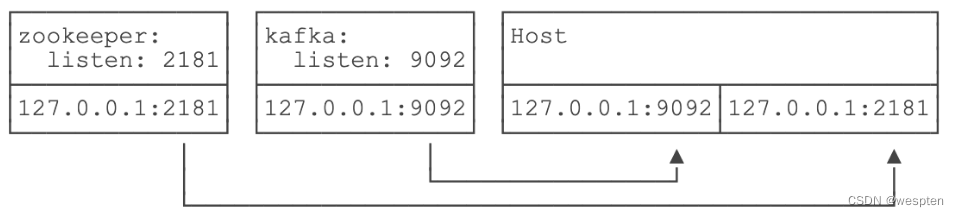

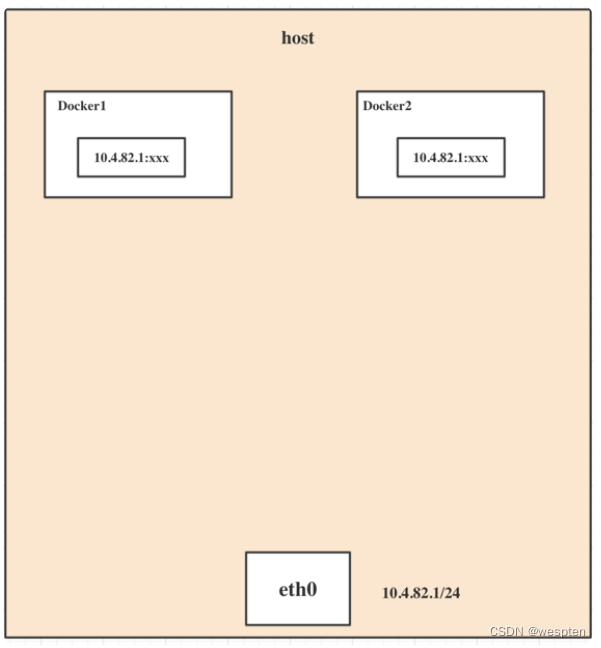

我们举个例子:在Docker中运行docker run redis:latest,然后在宿主机上写个程序连接127.0.0.1:6379,是无法连接到Redis的,因为Redis虽然监听127.0.0.1:6379这个端口,但Linux可以为进程隔离网络,Docker默认启动的Redis进程拥有自己的网络名字空间,与宿主机不同:

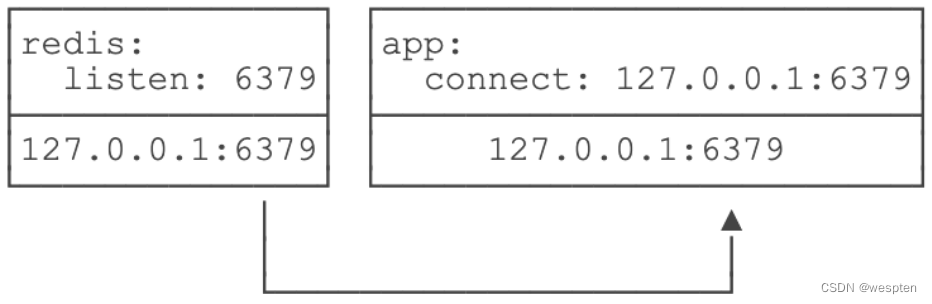

要让宿主机访问到Redis,可以用-p 6379:6379把Redis进程的端口号映射到宿主机,从而在宿主机上访问Redis:

因此,在Linux的网络名字空间隔离下,Redis进程和宿主机进程看到的IP地址127.0.0.1表面上一样,但实际上是不同的网络接口。

我们再看一个更复杂的例子。如果我们要运行ZooKeeper和Kafka,先启动ZooKeeper:

docker run -p 2181:2181 zookeeper:latest再启动Kafka,发现Kafka是无法连接ZooKeeper的,原因是,Kafka试图连接的127.0.0.1:2181在它自己的网络接口上并不存在:

必须连接到ZooKeeper的IP:2181或者宿主机的IP:2181。直接指定IP并不是一个好的方式,我们应该利用Docker Compose,把ZooKeeper和Kafka运行在同一个网络名字空间里,并通过zookeeper:2181来访问ZooKeeper端口,让Docker自动把zookeeper名字解析为动态分配的IP地址。

docker-compose.yml参考配置如下:

---

version: '3'

services:

zookeeper:

image: confluentinc/cp-zookeeper:7.0.1

container_name: zookeeper

environment:

ZOOKEEPER_CLIENT_PORT: 2181

ZOOKEEPER_TICK_TIME: 2000

broker:

image: confluentinc/cp-kafka:7.0.1

container_name: broker

ports:

# To learn about configuring Kafka for access across networks see

# https://www.confluent.io/blog/kafka-client-cannot-connect-to-broker-on-aws-on-docker-etc/

- "9092:9092"

depends_on:

- zookeeper

environment:

KAFKA_broKER_ID: 1

KAFKA_ZOOKEEPER_CONNECT: 'zookeeper:2181'

KAFKA_LISTENER_Security_PROTOCOL_MAP: PLAINTEXT:PLAINTEXT,PLAINTEXT_INTERNAL:PLAINTEXT

KAFKA_ADVERTISED_LISTENERS: PLAINTEXT://localhost:9092,PLAINTEXT_INTERNAL://broker:29092

KAFKA_OFFSETS_TOPIC_REPLICATION_FACTOR: 1

KAFKA_TRANSACTION_STATE_LOG_MIN_ISR: 1

KAFKA_TRANSACTION_STATE_LOG_REPLICATION_FACTOR: 1运行此命令以正确顺序启动所有服务:

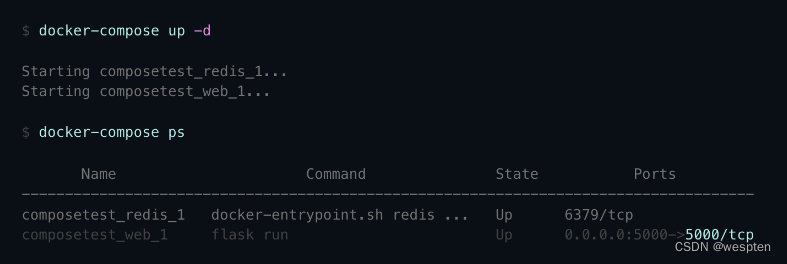

docker-compose up -d运行此命令以创建一个新 topic, 我们将在其中写入和读取一些测试消息:

docker exec broker \

kafka-topics --bootstrap-server broker:9092 \

--create \

--topic quickstart您可以使用 kafka-console-producer 命令行工具将消息写入topic,运行此命令等待您的输入:

docker exec --interactive --tty broker \

kafka-console-producer --bootstrap-server broker:9092 \

--topic quickstart输入几行文本,每一行都是一条新消息:

this is my first kafka message

Hello World!

this is my third kafka message. I’m on a roll :-D完成后,按 Ctrl-D 返回命令提示符。

现在我们已经向主题写入了消息,我们将读回这些消息。运行此命令以启动 kafka-console-consumer,--from-beginning参数意味着将从主题的开头读取消息:

docker exec --interactive --tty broker \

kafka-console-consumer --bootstrap-server broker:9092 \

--topic quickstart \

--from-beginning和以前一样,这对于在命令行上进行试验很有用,但实际上,您将在应用程序代码中使用 Consumer API,或使用 Kafka Connect 从 Kafka 读取数据以推送到其他系统。

这是我的第一个卡夫卡消息

你好世界!

这是我的第三条卡夫卡信息。我很高兴:-D让上一步中的 kafka-console-consumer 命令继续运行。如果您已经关闭它,只需重新运行它。现在打开一个新的终端窗口并再次运行 kafka-console-producer:

docker exec --interactive --tty broker \

kafka-console-producer --bootstrap-server broker:9092 \

--topic quickstart输入更多消息并注意它们是如何几乎立即在消费者终端中显示的,按 Ctrl-D 退出生产者,按 Ctrl-C 停止消费者。

完成后,您可以关闭 Kafka 代理。请注意,这样做会破坏您编写的主题中的所有消息。从包含docker-compose.yml先前创建的文件的目录中,运行此命令以按正确顺序停止所有服务:

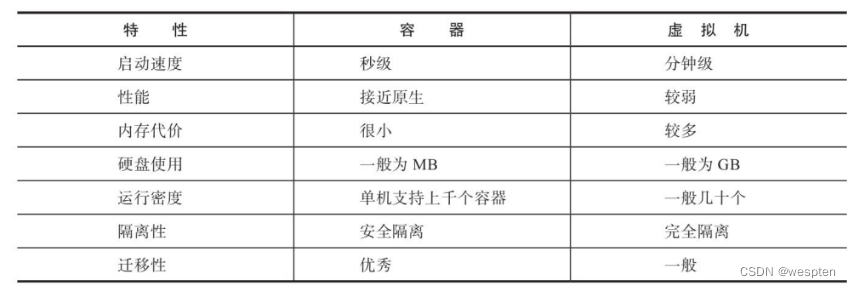

docker-compose down2、Docker与虚拟机有何区别

很多人将Docker理解为Docker实现了类似于虚拟化的技术,容器被称为轻量级的虚拟化技术,实际上是不准确的。Docker 不是轻量级的虚拟机,确切地说,容器是一种对进程进行隔离的运行环境。

Docker其实是一个Client-Server结构的系统,Docker守护进程运行在主机上, 然后通过Socket连接从客户端访问Docker守护进程。

Docker守护进程从客户端接受命令,并按照命令管理运行在主机上的容器。一个Docker 容器,是一个运行时环境,可以简单理解为进程运行的集装箱。

Docker和虚拟机主要的区别有一下几点:

1. 虚拟化技术依赖的是物理cpu和内存,是硬件级别的,需要的是Guest OS;而Docker是构建在操作系统层面的,利用的是宿主机操作系统的内核,所以Docker同样可以运行在虚拟机上。

2. 虚拟机中的系统就是我们常说的操作系统镜像,比较复杂;而Docker比较轻量级,有着比虚拟机更少的抽象层,我们可以使用Docker部署一个独立的Redis,就像类似于在虚拟机当中安装一个Redis应用,但是我们用Docker部署的应用是完全隔离的。

3. 在传统的虚拟化技术是通过快照来保存的;而Docker引用了类似于源码的管理机制,将容器的快照历史版本一一记录下来,切换成本之低。

4. 传统的虚拟化技术在构建系统的时候非常复杂;而Docker可以通过一个简单的Dockerfile文件来构建整个容器,更重要的是Dockerfile可以手动编写,这样应用开发人员可以通过发布Dockerfile来定义应用的环境和依赖,这样对于持续交付非常有利。

VM(VMware)在宿主机器、宿主机器操作系统的基础上创建虚拟层、虚拟化的操作系统、虚拟化的仓库,然后再安装应用;Container(Docker容器),在宿主机器、宿主机器操作系统上创建Docker引擎,在引擎的基础上再安装应用。

所以说,新建一个容器的时候,docker不需要像虚拟机一样重新加载一个操作系统,避免引导。Docker是利用宿主机的操作系统,省略了这个复杂的过程,妙极!

虚拟机是加载Guest OS ,这是分钟级别的。

与传统VM特性对比:

作为一种轻量级的虚拟化方式,Docker在运行应用上跟传统的虚拟机方式相比具有显著优势:

- Docker 容器很快,启动和停止可以在秒级实现,这相比传统的虚拟机方式要快得多。

- Docker 容器对系统资源需求很少,一台主机上可以同时运行数千个Docker容器。

- Docker 通过类似Git的操作来方便用户获取、分发和更新应用镜像,指令简明,学习成本较低。

- Docker 通过Dockerfile配置文件来支持灵活的自动化创建和部署机制,提高工作效率。

- Docker 容器除了运行其中的应用之外,基本不消耗额外的系统资源,保证应用性能的同时,尽量减小系统开销。

- Docker 利用Linux系统上的多种防护机制实现了严格可靠的隔离。从1.3版本开始,Docker引入了安全选项和镜像签名机制,极大地提高了使用Docker的安全性。

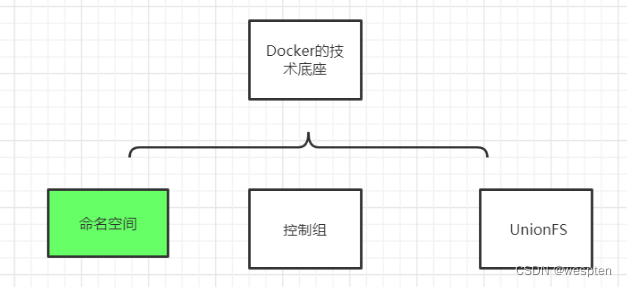

3、Docker核心概念

Linux 命名空间、控制组和 UnionFS 三大技术支撑了目前 Docker 的实现,也是 Docker 能够出现的最重要原因。

① Docker namespace

Linux 内核2.4.19中开始陆续引用了namespace概念。目的是将某个特定的全局系统资源(global system resource)通过抽象方法使得namespace中的进程看起来拥有它们自己的隔离的全局系统资源实例,命名空间是Linux内核强大的特性。

命名空间容器隔离的基础,保证A容器看不到B容器。每个容器都有自己的命名空间,运行在其中的应用都是在独立操作系统中运行一样。命名空间保证了容器之间彼此互不影响。

6个命名空间:User,Mnt,Network,UTS,IPC,Pid。

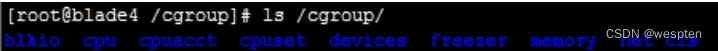

② Docker CGroups

Cgroups 是 Control Group 的缩写,控制组,cgroups容器资源统计和隔离。Docker容器使用Linux namespace来隔离其运行环境,使得容器中的进程看起来就像在一个独立的环境中运行。但是光有运行环境隔离还不够,因为这些进程还是可以不受限制地使用系统资源,比如网络、磁盘、cpu以及内存等。

Cgroups是Linux内核提供的一种可以限制、记录、隔离进程组(process groups)所使用的物理资源(如:cpu, Memory, IO等)的机制。最初由Google的工程师提出,后来被整合进Linux内核。Cgroups也是LXC为实现虚拟化所使用的资源管理手段,可以说没有Cgroups就没有LXC,也就没有Docker。

Cgroups最初的目标是为资源管理提供的一个统一的框架,既整合现有的cpuset等子系统,也为未来开发新的子系统提供接口。现在的Cgroups适用于多种应用场景,从单个进程的资源控制,到实现操作系统层次的虚拟化(OS Level Virtualization)。

Cgroups提供以下功能:

a)限制进程组可以使用的资源数量(Resource limiting )。比如:Memory子系统可以为进程组设定一个Memory使用上限,一旦进程组使用的内存达到限额再申请内存,就会出发OOM(out of memory)。

b)进程组的优先级控制(Prioritization)。比如:可以使用cpu子系统为某个进程组分配特定cpushare。

c)进程组隔离(Isolation)。比如:使用ns子系统可以使不同的进程组使用不同的namespace,以达到隔离的目的,不同的进程组有各自的进程、网络、文件系统挂载空间。

d)记录进程组使用的资源数量(Accounting)。比如:可以使用cpuacct子系统记录某个进程组使用的cpu时间

e)进程组控制(Control)。比如:使用freezer子系统可以将进程组挂起和恢复。

主要用到的cgroups子系统:cpu,blkio,device,freezer,memory。

实际上 Docker 是使用了很多 Linux 的隔离功能,让容器看起来像一个轻量级虚拟机在独立运行,容器的本质是被限制了的 Namespaces,cgroup,具有逻辑上独立文件系统,网络的一个进程。

③ Docker UnionFS

没有操作系统,怎么运行程序?

可以在Docker中创建一个centos的镜像文件,这样就能将centos系统集成到Docker中,运行的应用就都是centos的应用。

Image 是 Docker 部署的基本单位,一个 Image 包含了我们的程序文件,以及这个程序依赖的资源的环境。Docker Image 对外是以一个文件的形式展示的(更准确的说是一个 mount 点)。

UnionFS顾名思义,可以把文件系统上多个目录(文件系统)内容联合挂载到同一个目录(挂载点)下,而目录的物理位置是分开的。

要理解unionFS,我们首先需要先了解bootfs和rootfs1.boot file system (bootfs) 包含操作系统boot loader和kernel。用户不会修改这个文件系统,一旦启动成功后,整个Linux内核加载进内存,之后bootfs会被卸载掉,从而释放内存。同样的内核版本不同Linux发行版,其bootfs都是一直的2.root file system (rootfs) 包含典型的目录结构(/dev/,/proc,/bin,/etc,/lib,/usr,/tmp)Linux系统在启动时,rootfs首先会被挂载为只读模式,然后在启动完成后被修改为读写模式,随后它们就可以被修改了。

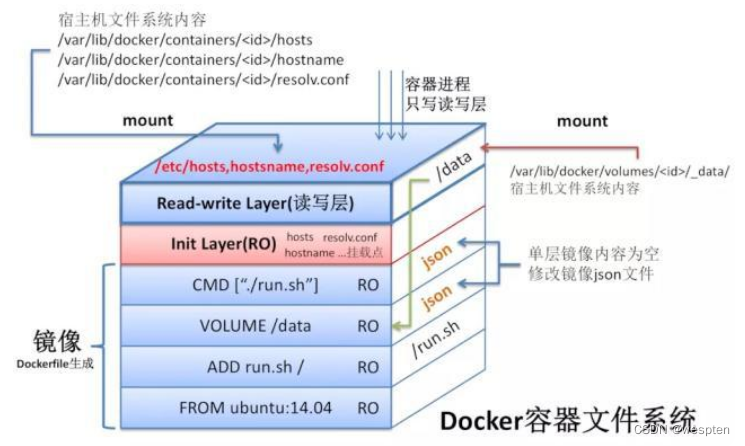

假设Dockerfile内容如下:

FROM ubuntu:14.04

ADD run.sh /

VOLUME /data

CMD ["./run.sh"]

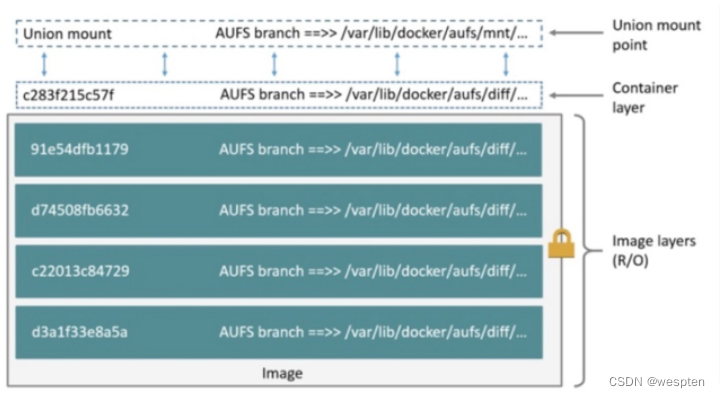

联合文件系统对应的层次结构如下图所示:

图中的顶上两层,是Docker为Docker容器新建的内容,而这两层属于容器范畴。这两层分别为Docker容器的初始层(init Layer)与可读写层(Read-write Layer)。

初始层:大多是初始化容器环境时,与容器相关的环境信息,如容器主机名,主机host信息以及域名服务文件等。

读写层: Docker容器内的进程只对可读可写层拥有写权限,其它层进程而言都是只读的(Read-Only)。关于VOLUME以及容器的host、hostname、resolv.conf文件都会挂载到这里。

1. FROM ubuntu:14.04 设置基础镜像,此时会使用Ubuntu:14.04作为基础镜像;

2. ADD run.sh / 将Dockerfile所在目录下的run.sh加至镜像的根目录,此时新一层的镜像只有一项内容,即根目录下的run.sh;

3. VOLUME /data 设置镜像存储,此VOLUME在容器内部的路径为/data。此时并未在新一层的镜像中添加任何文件,但是更新了镜像的json文件,以便通过此镜像启动容器时获取这方面的信息;

4. CMD [“./run.sh”] 设置镜像的默认执行入口,此命令同样不会在新建镜像中添加任何文件,仅仅在上一层镜像json文件的基础上更新新的镜像的json文件;

4、Namespaces命名空间

在Linux系统中,Namespace是在内核级别以一种抽象的形式来封装系统资源,通过将系统资源放在不同的Namespace中,来实现资源隔离的目的。不同的Namespace程序,可以享有一份独立的系统资源。

命名空间(namespaces)是 Linux 为我们提供的用于分离进程树、网络接口、挂载点以及进程间通信等资源的方法。在日常使用 Linux 或者 macOS 时,我们并没有运行多个完全分离的服务器的需要,但是如果我们在服务器上启动了多个服务,这些服务其实会相互影响的,每一个服务都能看到其他服务的进程,也可以访问宿主机器上的任意文件,这是很多时候我们都不愿意看到的,我们更希望运行在同一台机器上的不同服务能做到完全隔离,就像运行在多台不同的机器上一样。

Linux 的命名空间机制提供了以下七种不同的命名空间,包括 :

- CLONE_NEWCGROUP

- CLONE_NEWIPC

- CLONE_NEWNET

- CLONE_NEWNS

- CLONE_NEWPID

- CLONE_NEWUSER

- CLONE_NEWUTS

通过这七个选项, 我们能在创建新的进程时, 设置新进程应该在哪些资源上与宿主机器进行隔离。

具体如下:

| Namespace | Flag | Page | Isolates |

|---|---|---|---|

| Cgroup | CLONE_NEWCGROUP | cgroup_namespaces | Cgroup root directory |

| IPC | CLONE_NEWIPC | ipc_namespaces | System V IPC,POSIX message queues 隔离进程间通信 |

| Network | CLONE_NEWNET | network_namespaces | Network devices,stacks, ports, etc. 隔离网络资源 |

| Mount | CLONE_NEWNS | mount_namespaces | Mount points 隔离文件系统挂载点 |

| PID | CLONE_NEWPID | pid_namespaces | Process IDs 隔离进程的ID |

| Time | CLONE_NEWTIME | time_namespaces | Boot and monotonic clocks |

| User | CLONE_NEWUSER | user_namespaces | User and group IDs 隔离用户和用户组的ID |

| UTS | CLONE_NEWUTS | uts_namespaces | Hostname and NIS domain name 隔离主机名和域名信息 |

这里提出一个问题,在宿主机上启动两个容器,在这两个容器内都各有一个 PID=1的进程,众所周知,Linux 里 PID 是唯一的,既然 Docker 不是跑在宿主机上的两个虚拟机,那么它是如何实现在宿主机上运行两个相同 PID 的进程呢?

这里就用到了 Linux Namespaces,它其实是 Linux 创建新进程时的一个可选参数,在 Linux 系统中创建进程的系统调用是 clone()方法。

int clone(int (*fn) (void *),void *child stack,

int flags, void *arg, . . .

/* pid_ t *ptid, void *newtls, pid_ t *ctid */ ) ;

通过调用这个方法,这个进程会获得一个独立的进程空间,它的 pid 是1,并且看不到宿主机上的其他进程,这也就是在容器内执行 PS 命令的结果。

不仅仅是 PID,当你启动启动容器之后,Docker 会为这个容器创建一系列其他 namespaces。

这些 namespaces 提供了不同层面的隔离。容器的运行受到各个层面 namespace 的限制。

Docker Engine 使用了以下 Linux 的隔离技术:

The pid namespace: 管理 PID 命名空间 (PID: Process ID);

The net namespace: 管理网络命名空间 (NET: Networking);

The ipc namespace: 管理进程间通信命名空间 (IPC: InterProcess Communication);

The mnt namespace: 管理文件系统挂载点命名空间 (MNT: Mount);

The uts namespace: Unix 时间系统隔离 (UTS: Unix Timesharing System);

通过这些技术,运行时的容器得以看到一个和宿主机上其他容器隔离的环境。

1)进程隔离

进程是 Linux 以及现在操作系统中非常重要的概念,它表示一个正在执行的程序,也是在现代分时系统中的一个任务单元。

在每一个 *nix 的操作系统上,我们都能够通过 ps 命令打印出当前操作系统中正在执行的进程,比如在 Ubuntu 上,使用该命令就能得到以下的结果:

|$ ps -ef

UID PID PPID C STIME TTY TIME CMD

root 1 0 0 Apr08 ? 00:00:09 /sbin/init

root 2 0 0 Apr08 ? 00:00:00 [kthreadd]

root 3 2 0 Apr08 ? 00:00:05 [ksoftirqd/0]

root 5 2 0 Apr08 ? 00:00:00 [kworker/0:0H]

root 7 2 0 Apr08 ? 00:07:10 [rcu_sched]

root 39 2 0 Apr08 ? 00:00:00 [migration/0]

root 40 2 0 Apr08 ? 00:01:54 [watchdog/0]

当前机器上有很多的进程正在执行,在上述进程中有两个非常特殊,一个是 pid 为 1 的 /sbin/init 进程,另一个是 pid 为 2 的 kthreadd 进程,这两个进程都是被 Linux 中的上帝进程 idle 创建出来的,其中前者负责执行内核的一部分初始化工作和系统配置,也会创建一些类似 getty 的注册进程,而后者负责管理和调度其他的内核进程。

如果我们在当前的 Linux 操作系统下运行一个新的 Docker 容器,并通过 exec 进入其内部的 bash 并打印其中的全部进程,我们会得到以下的结果:

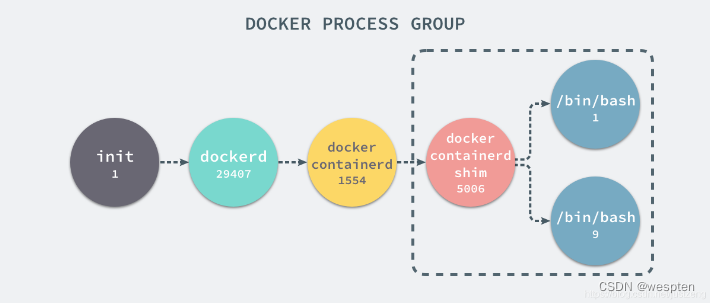

UID PID PPID C STIME TTY TIME CMD

root 29407 1 0 Nov16 ? 00:08:38 /usr/bin/dockerd --raw-logs

root 1554 29407 0 Nov19 ? 00:03:28 docker-containerd -l unix:///var/run/docker/libcontainerd/docker-containerd.sock --metrics-interval=0 --start-timeout 2m --state-dir /var/run/docker/libcontainerd/containerd --shim docker-containerd-shim --runtime docker-runc

root 5006 1554 0 08:38 ? 00:00:00 docker-containerd-shim b809a2eb3630e64c581561b08ac46154878ff1c61c6519848b4a29d412215e79 /var/run/docker/libcontainerd/b809a2eb3630e64c581561b08ac46154878ff1c61c6519848b4a29d412215e79 docker-runc在新的容器内部执行 ps 命令打印出了非常干净的进程列表,只有包含当前 ps -ef 在内的三个进程,在宿主机器上的几十个进程都已经消失不见了。

当前的 Docker 容器成功将容器内的进程与宿主机器中的进程隔离,如果我们在宿主机器上打印当前的全部进程时,会得到下面三条与 Docker 相关的结果。

在当前的宿主机器上,可能就存在由上述的不同进程构成的进程树:

这就是在使用 clone(2) 创建新进程时传入 CLONE_NEWPID 实现的,也就是使用 Linux 的命名空间实现进程的隔离,Docker 容器内部的任意进程都对宿主机器的进程一无所知。

containerRouter.postContaineRSStart

└── daemon.ContainerStart

└── daemon.createSpec

└── setNamespaces

└── setNamespace

Docker 的容器就是使用上述技术实现与宿主机器的进程隔离,当我们每次运行 docker run 或者 docker start 时,都会在下面的方法中创建一个用于设置进程间隔离的 Spec:

func (daemon *Daemon) createSpec(c *container.Container) (*specs.Spec, error) {

s := oci.DefaultSpec()

// ...

if err := setNamespaces(daemon, &s, c); err != nil {

return nil, fmt.Errorf("linux spec namespaces: %v", err)

}

return &s, nil

}

在 setNamespaces 方法中不仅会设置进程相关的命名空间,还会设置与用户、网络、IPC 以及 UTS 相关的命名空间:

func setNamespaces(daemon *Daemon, s *specs.Spec, c *container.Container) error {

// user

// network

// ipc

// uts

// pid

if c.HostConfig.PidMode.IsContainer() {

ns := specs.LinuxNamespace{Type: "pid"}

pc, err := daemon.getPidContainer(c)

if err != nil {

return err

}

ns.Path = fmt.Sprintf("/proc/%d/ns/pid", pc.State.GetPID())

setNamespace(s, ns)

} else if c.HostConfig.PidMode.IsHost() {

oci.RemoveNamespace(s, specs.LinuxNamespaceType("pid"))

} else {

ns := specs.LinuxNamespace{Type: "pid"}

setNamespace(s, ns)

}

return nil

}

所有命名空间相关的设置 Spec 最后都会作为 Create 函数的入参在创建新的容器时进行设置:

daemon.containerd.Create(context.Background(), container.ID, spec, createOptions)所有与命名空间的相关的设置都是在上述的两个函数中完成的,Docker 通过命名空间成功完成了与宿主机进程和网络的隔。

2)网络隔离

如果 Docker 的容器通过 Linux 的命名空间完成了与宿主机进程的网络隔离,但是却有没有办法通过宿主机的网络与整个互联网相连,就会产生很多限制。

所以 Docker 虽然可以通过命名空间创建一个隔离的网络环境,但是 Docker 中的服务仍然需要与外界相连才能发挥作用。

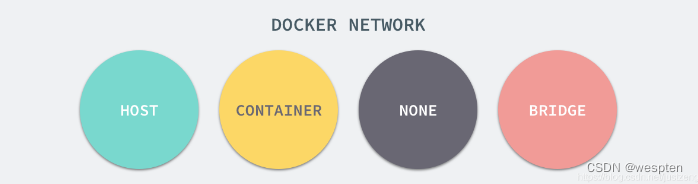

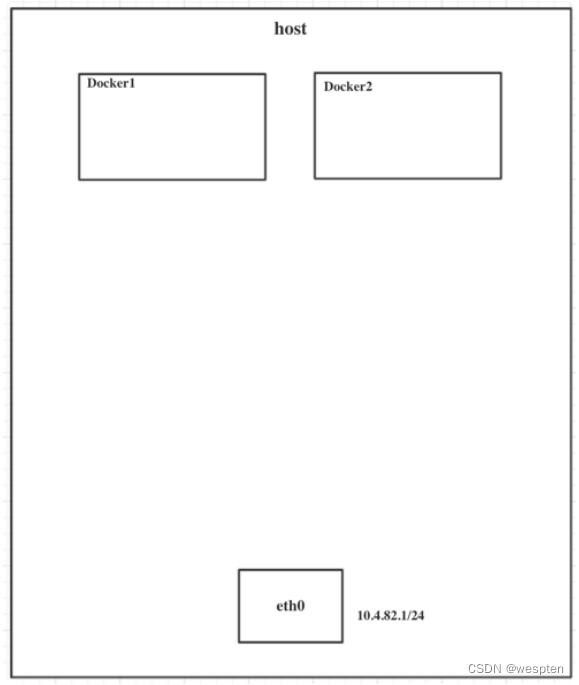

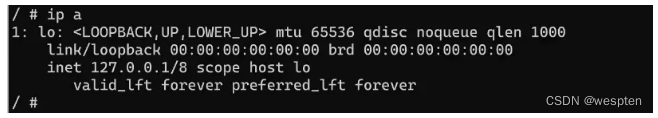

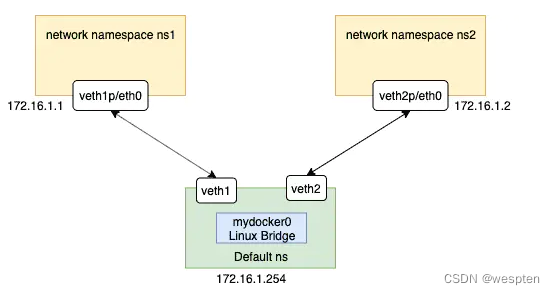

每一个使用 docker run 启动的容器其实都具有单独的网络命名空间,Docker 为我们提供了四种不同的网络模式,Host、Container、None 和 Bridge 模式。

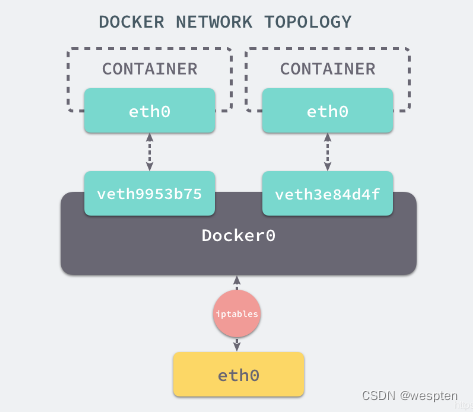

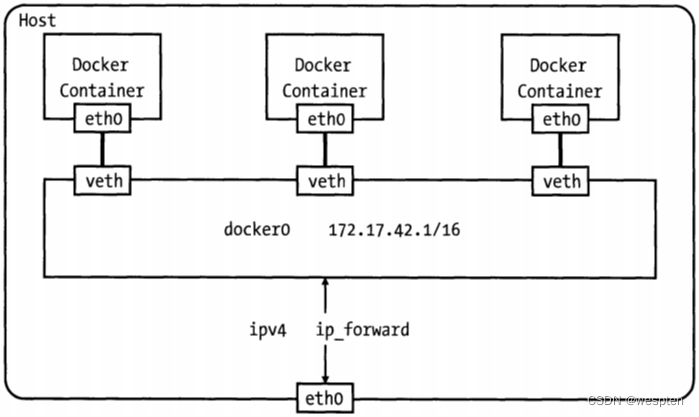

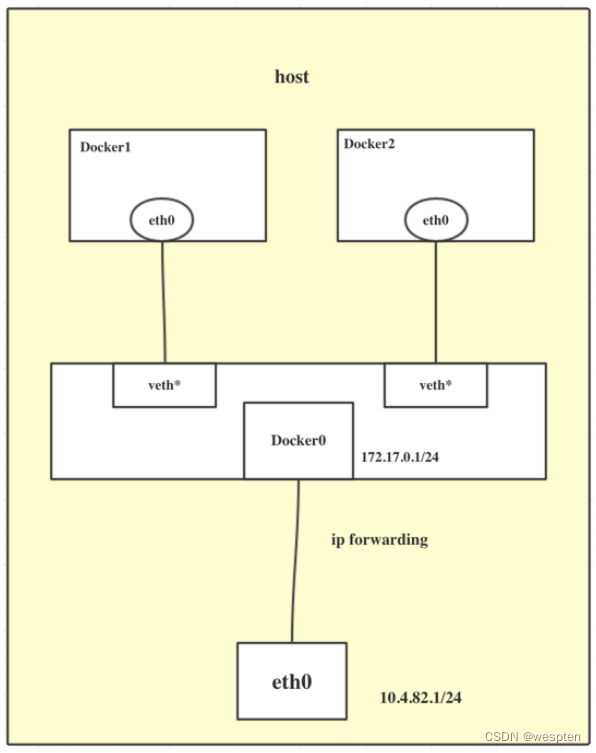

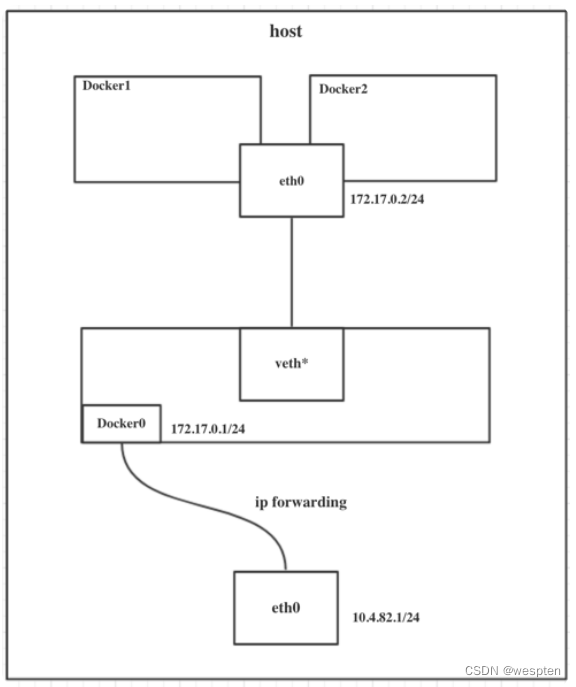

在这一部分,我们将介绍 Docker 默认的网络设置模式:网桥模式。

在这种模式下,除了分配隔离的网络命名空间之外,Docker 还会为所有的容器设置 IP 地址。

当 Docker 服务器在主机上启动之后会创建新的虚拟网桥 docker0,随后在该主机上启动的全部服务在默认情况下都与该网桥相连。

在默认情况下,每一个容器在创建时都会创建一对虚拟网卡,两个虚拟网卡组成了数据的通道,其中一个会放在创建的容器中,会加入到名为 docker0 网桥中。

我们可以使用如下的命令来查看当前网桥的接口:

$ brctl show

bridge name bridge id STP enabled interfaces

docker0 8000.0242a6654980 no veth3e84d4f

veth9953b75docker0会为每一个容器分配一个新的 IP 地址并将 docker0 的 IP 地址设置为默认的网关。

网桥 docker0 通过 iptables 中的配置与宿主机器上的网卡相连,所有符合条件的请求都会通过 iptables 转发到 docker0 并由网桥分发给对应的机器。

$ iptables -t nat -L

Chain PREROUTING (policy ACCEPT)

target prot opt source destination

DOCKER all -- anywhere anywhere ADDRTYPE match dst-type LOCAL

Chain DOCKER (2 references)

target prot opt source destination

RETURN all -- anywhere anywhere

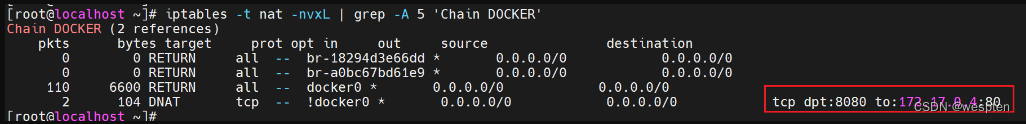

我们在当前的机器上使用 docker run -d -p 6379:6379 redis 命令启动了一个新的 Redis 容器,在这之后我们再查看当前 iptables 的 NAT 配置就会看到在 DOCKER 的链中出现了一条新的规则:

DNAT tcp -- anywhere anywhere tcp dpt:6379 to:192.168.0.4:6379上述规则会将从任意源发送到当前机器 6379 端口的 TCP 包转发到 192.168.0.4:6379 所在的地址上。

这个地址其实也是 Docker 为 Redis 服务分配的 IP 地址,如果我们在当前机器上直接 ping 这个 IP 地址就会发现它是可以访问到的:

$ ping 192.168.0.4

PING 192.168.0.4 (192.168.0.4) 56(84) bytes of data.

64 bytes from 192.168.0.4: icmp_seq=1 ttl=64 time=0.069 ms

64 bytes from 192.168.0.4: icmp_seq=2 ttl=64 time=0.043 ms

^C

--- 192.168.0.4 ping statistics ---

2 packets transmitted, 2 received, 0% packet loss, time 999ms

rtt min/avg/max/mdev = 0.043/0.056/0.069/0.013 ms从上述的一系列现象,我们就可以推测出 Docker 是如何将容器的内部的端口暴露出来并对数据包进行转发的了;当有 Docker 的容器需要将服务暴露给宿主机器,就会为容器分配一个 IP 地址,同时向 iptables 中追加一条新的规则。

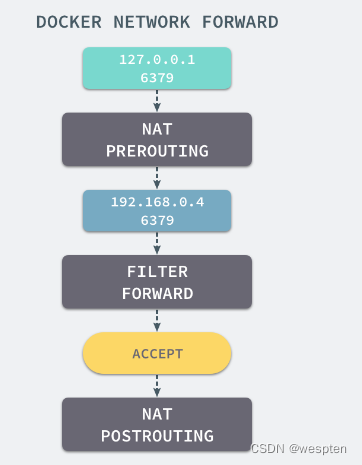

当我们使用 redis-cli 在宿主机器的命令行中访问 127.0.0.1:6379 的地址时,经过 iptables 的 NAT PREROUTING 将 ip 地址定向到了 192.168.0.4,重定向过的数据包就可以通过 iptables 中的 FILTER 配置,最终在 NAT POSTROUTING 阶段将 ip 地址伪装成 127.0.0.1,到这里虽然从外面看起来我们请求的是 127.0.0.1:6379,但是实际上请求的已经是 Docker 容器暴露出的端口了。

$ redis-cli -h 127.0.0.1 -p 6379 ping

PONGDocker 通过 Linux 的命名空间实现了网络的隔离,又通过 iptables 进行数据包转发,让 Docker 容器能够优雅地为宿主机器或者其他容器提供服务。

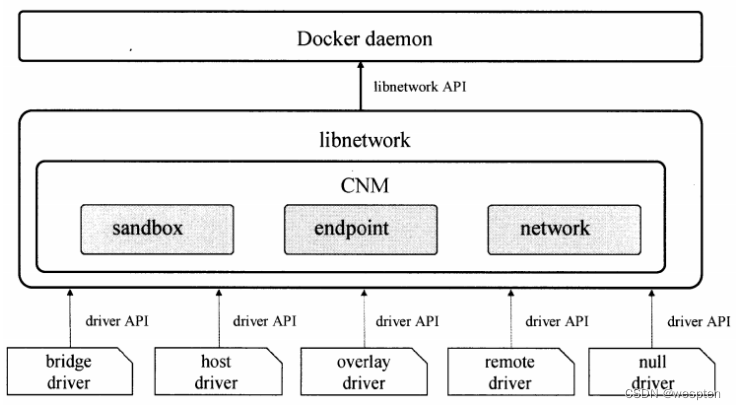

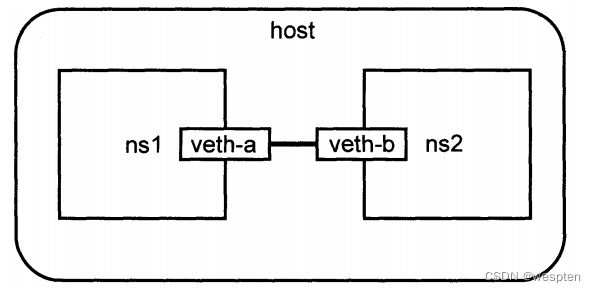

3)Libnetwork

整个网络部分的功能都是通过 Docker 拆分出来的 libnetwork 实现的,它提供了一个连接不同容器的实现,同时也能够为应用给出一个能够提供一致的编程接口和网络层抽象的容器网络模型。

The goal of libnetwork is to deliver a robust Container Network Model that provides a consistent programming interface and the required network abstractions for applications.

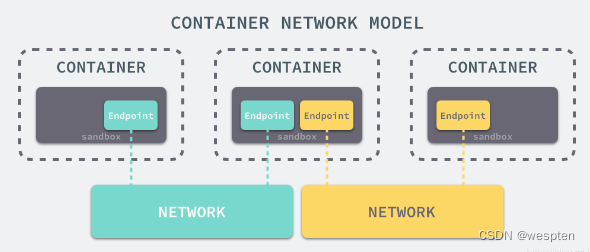

libnetwork 中最重要的概念,容器网络模型由以下的几个主要组件组成,分别是 SandBox、Endpoint 和 Network:

在容器网络模型中,每一个容器内部都包含一个 SandBox,其中存储着当前容器的网络栈配置,包括容器的接口、路由表和 DNS 设置,Linux 使用网络命名空间实现这个 SandBox,每一个 SandBox 中都可能会有一个或多个 Endpoint,在 Linux 上就是一个虚拟的网卡 veth,SandBox 通过 Endpoint 加入到对应的网络中,这里的网络可能就是我们在上面提到的 Linux 网桥或者 VLAN。

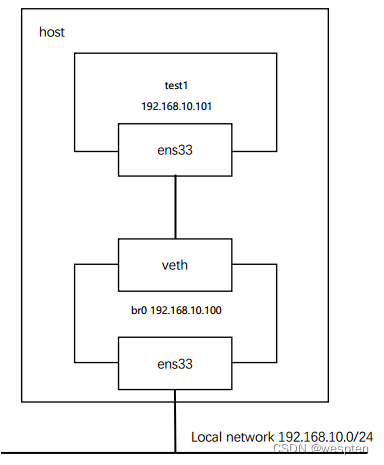

4)挂载点

在这里不得不简单介绍一下 chroot(change root),在 Linux 系统中,系统默认的目录就都是以 / 也就是根目录开头的,chroot 的使用能够改变当前的系统根目录结构,通过改变当前系统的根目录,我们能够限制用户的权利,在新的根目录下并不能够访问旧系统根目录的结构个文件,也就建立了一个与原系统完全隔离的目录结构。

虽然我们已经通过 Linux 的命名空间解决了进程和网络隔离的问题,在 Docker 进程中我们已经没有办法访问宿主机器上的其他进程并且限制了网络的访问,但是 Docker 容器中的进程仍然能够访问或者修改宿主机器上的其他目录,这是我们不希望看到的。

在新的进程中创建隔离的挂载点命名空间需要在 clone 函数中传入 CLONE_NEWNS,这样子进程就能得到父进程挂载点的拷贝,如果不传入这个参数子进程对文件系统的读写都会同步回父进程以及整个主机的文件系统。

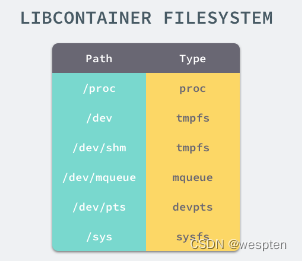

如果一个容器需要启动,那么它一定需要提供一个根文件系统(rootfs),容器需要使用这个文件系统来创建一个新的进程,所有二进制的执行都必须在这个根文件系统中。

想要正常启动一个容器就需要在 rootfs 中挂载以上的几个特定的目录,除了上述的几个目录需要挂载之外我们还需要建立一些符号链接保证系统 IO 不会出现问题。

为了保证当前的容器进程没有办法访问宿主机器上其他目录,我们在这里还需要通过 libcotainer 提供的 pivor_root 或者 chroot 函数改变进程能够访问个文件目录的根节点。

// pivor_root

put_old = mkdir(...);

pivot_root(rootfs, put_old);

chdir("/");

unmount(put_old, MS_DETACH);

rmdir(put_old);

// chroot

mount(rootfs, "/", NULL, MS_MOVE, NULL);

chroot(".");

chdir("/");到这里我们就将容器需要的目录挂载到了容器中,同时也禁止当前的容器进程访问宿主机器上的其他目录,保证了不同文件系统的隔离。

linux namespace API:

所讨论的namespace实现针对的均是Linux内核3.8及其以后的版本。

namespace的API包括clone()、setns()以及unshare(),还有/proc下的部分文件。为了确定隔离的到底是哪种namespace,在使用这些API时,通常需要指定以下六个常数的一个或多个,通过|(位或)操作来实现。你可能已经在上面的表格中注意到,这六个参数分别是CLONE_NEWIPC、CLONE_NEWNS、CLONE_NEWNET、CLONE_NEWPID、CLONE_NEWUSER和CLONE_NEWUTS。

① 通过clone()创建新进程的同时创建namespace

使用clone()来创建一个独立namespace的进程是最常见做法,它的调用方式如下。

int clone(int (*child_func)(void *), void *child_stack, int flags, void *arg);clone()实际上是传统UNIX系统调用fork()的一种更通用的实现方式,它可以通过flags来控制使用多少功能。一共有二十多种CLONE_*的flag(标志位)参数用来控制clone进程的方方面面(如是否与父进程共享虚拟内存等等),下面外面逐一讲解clone函数传入的参数。

② 查看/proc/[pid]/ns文件

从3.8版本的内核开始,用户就可以在/proc/[pid]/ns文件下看到指向不同namespace号的文件,效果如下所示,形如[4026531839]者即为namespace号。

$ ls -l /proc/$$/ns <<-- 0="" 1="" 8="" $$="" 表示应用的pid="" total="" lrwxrwxrwx.="" mtk="" jan="" 04:12="" ipc="" -=""> ipc:[4026531839]

lrwxrwxrwx. 1 mtk mtk 0 Jan 8 04:12 mnt -> mnt:[4026531840]

lrwxrwxrwx. 1 mtk mtk 0 Jan 8 04:12 net -> net:[4026531956]

lrwxrwxrwx. 1 mtk mtk 0 Jan 8 04:12 pid -> pid:[4026531836]

lrwxrwxrwx. 1 mtk mtk 0 Jan 8 04:12 user->user:[4026531837]

lrwxrwxrwx. 1 mtk mtk 0 Jan 8 04:12 uts -> uts:[4026531838]

如果两个进程指向的namespace编号相同,就说明他们在同一个namespace下,否则则在不同namespace里面。/proc/[pid]/ns的另外一个作用是,一旦文件被打开,只要打开的文件描述符(fd)存在,那么就算PID所属的所有进程都已经结束,创建的namespace就会一直存在。那如何打开文件描述符呢?把/proc/[pid]/ns目录挂载起来就可以达到这个效果,命令如下。

# touch ~/uts

# mount --bind /proc/27514/ns/uts ~/uts

如果你看到的内容与本文所描述的不符,那么说明你使用的内核在3.8版本以前。该目录下存在的只有ipc、net和uts,并且以硬链接存在。

③ 通过setns()加入一个已经存在的namespace

上文刚提到,在进程都结束的情况下,也可以通过挂载的形式把namespace保留下来,保留namespace的目的自然是为以后有进程加入做准备。通过setns()系统调用,你的进程从原先的namespace加入我们准备好的新namespace,使用方法如下:

int setns(int fd, int nstype);-

参数fd表示我们要加入的namespace的文件描述符。上文已经提到,它是一个指向/proc/[pid]/ns目录的文件描述符,可以通过直接打开该目录下的链接或者打开一个挂载了该目录下链接的文件得到。

-

参数nstype让调用者可以去检查fd指向的namespace类型是否符合我们实际的要求。如果填0表示不检查。

为了把我们创建的namespace利用起来,我们需要引入execve()系列函数,这个函数可以执行用户命令,最常用的就是调用/bin/bash并接受参数,运行起一个shell,用法如下:

fd = open(argv[1], O_RDONLY); /* 获取namespace文件描述符 */

setns(fd, 0); /* 加入新的namespace */

execvp(argv[2], &argv[2]); /* 执行程序 */假设编译后的程序名称为setns:

# ./setns ~/uts /bin/bash # ~/uts 是绑定的/proc/27514/ns/uts至此,你就可以在新的命名空间中执行shell命令了,在下文中会多次使用这种方式来演示隔离的效果。

④ 通过unshare()在原先进程上进行namespace隔离

最后要提的系统调用是unshare(),它跟clone()很像,不同的是,unshare()运行在原先的进程上,不需要启动一个新进程,使用方法如下:

int unshare(int flags);调用unshare()的主要作用就是不启动一个新进程就可以起到隔离的效果,相当于跳出原先的namespace进行操作。这样,你就可以在原进程进行一些需要隔离的操作。Linux中自带的unshare命令,就是通过unshare()系统调用实现的,有兴趣的读者可以在网上搜索一下这个命令的作用。

5、CGroups物理资源限制分组

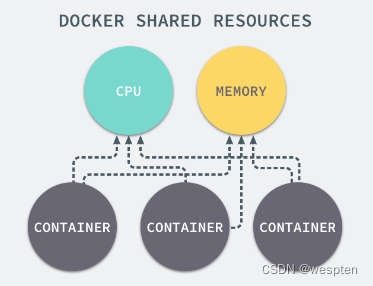

我们通过 Linux 的命名空间为新创建的进程隔离了文件系统、网络并与宿主机器之间的进程相互隔离,但是命名空间并不能够为我们提供物理资源上的隔离,比如 cpu 或者内存,如果在同一台机器上运行了多个对彼此以及宿主机器一无所知的『容器』,这些容器却共同占用了宿主机器的物理资源。

如果其中的某一个容器正在执行 cpu 密集型的任务,那么就会影响其他容器中任务的性能与执行效率,导致多个容器相互影响并且抢占资源。如何对多个容器的资源使用进行限制就成了解决进程虚拟资源隔离之后的主要问题,而 Control Groups(简称 CGroups)就是能够隔离宿主机器上的物理资源,例如 cpu、内存、磁盘 I/O 和网络带宽。

每一个 CGroup 都是一组被相同的标准和参数限制的进程,不同的 CGroup 之间是有层级关系的,也就是说它们之间可以从父类继承一些用于限制资源使用的标准和参数。

Linux 的 CGroup 能够为一组进程分配资源,也就是我们在上面提到的 cpu、内存、网络带宽等资源,通过对资源的分配。

Linux 使用文件系统来实现 CGroup,我们可以直接使用下面的命令查看当前的 CGroup 中有哪些子系统:

$ lssubsys -m

cpuset /sys/fs/cgroup/cpuset

cpu /sys/fs/cgroup/cpu

cpuacct /sys/fs/cgroup/cpuacct

memory /sys/fs/cgroup/memory

devices /sys/fs/cgroup/devices

freezer /sys/fs/cgroup/freezer

blkio /sys/fs/cgroup/blkio

perf_event /sys/fs/cgroup/perf_event

hugetlb /sys/fs/cgroup/hugetlb大多数 Linux 的发行版都有着非常相似的子系统,而之所以将上面的 cpuset、cpu 等东西称作子系统,是因为它们能够为对应的控制组分配资源并限制资源的使用。

如果我们想要创建一个新的 cgroup 只需要在想要分配或者限制资源的子系统下面创建一个新的文件夹,然后这个文件夹下就会自动出现很多的内容,如果你在 Linux 上安装了 Docker,你就会发现所有子系统的目录下都有一个名为 Docker 的文件夹:

$ ls cpu

cgroup.clone_children

...

cpu.stat

docker

notify_on_release

release_agent

tasks

$ ls cpu/docker/

9c3057f1291b53fd54a3d12023d2644efe6a7db6ddf330436ae73ac92d401cf1

cgroup.clone_children

...

cpu.stat

notify_on_release

release_agent

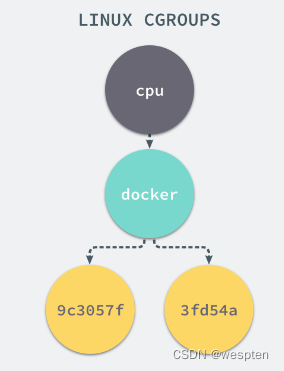

tasks9c3057xxx 其实就是我们运行的一个 Docker 容器,启动这个容器时,Docker 会为这个容器创建一个与容器标识符相同的 CGroup,在当前的主机上 CGroup 就会有以下的层级关系:

每一个 CGroup 下面都有一个 tasks 文件,其中存储着属于当前控制组的所有进程的 pid,作为负责 cpu 的子系统,cpu.cfs_quota_us 文件中的内容能够对 cpu 的使用作出限制,如果当前文件的内容为 50000,那么当前控制组中的全部进程的 cpu 占用率不能超过 50%。

如果系统管理员想要控制 Docker 某个容器的资源使用率就可以在 docker 这个父控制组下面找到对应的子控制组并且改变它们对应文件的内容,当然我们也可以直接在程序运行时就使用参数,让 Docker 进程去改变相应文件中的内容。

当我们使用 Docker 关闭掉正在运行的容器时,Docker 的子控制组对应的文件夹也会被 Docker 进程移除,Docker 在使用 CGroup 时其实也只是做了一些创建文件夹改变文件内容的文件操作,不过 CGroup 的使用也确实解决了我们限制子容器资源占用的问题,系统管理员能够为多个容器合理的分配资源并且不会出现多个容器互相抢占资源的问题。

6、Docker存储驱动

写时复制 (CoW):所有驱动都用到的技术————写时复制,Cow全称copy-on-write,表示只是在需要写时才去复制,这个是针对已有文件的修改场景。比如基于一个image启动多个Container,如果每个Container都去分配一个image一样的文件系统,那么将会占用大量的磁盘空间。而CoW技术可以让所有的容器共享image的文件系统,所有数据都从image中读取,只有当要对文件进行写操作时,才从image里把要写的文件复制到自己的文件系统进行修改。所以无论有多少个容器共享一个image,所做的写操作都是对从image中复制到自己的文件系统的副本上进行,并不会修改image的源文件,且多个容器操作同一个文件,会在每个容器的文件系统里生成一个副本,每个容器修改的都是自己的副本,互相隔离,互不影响。使用CoW可以有效的提高磁盘的利用率。

用时分配 (allocate-on-demand):写是分配是用在原本没有这个文件的场景,只有在要新写入一个文件时才分配空间,这样可以提高存储资源的利用率。比如启动一个容器,并不会因为这个容器分配一些磁盘空间,而是当有新文件写入时,才按需分配新空间。

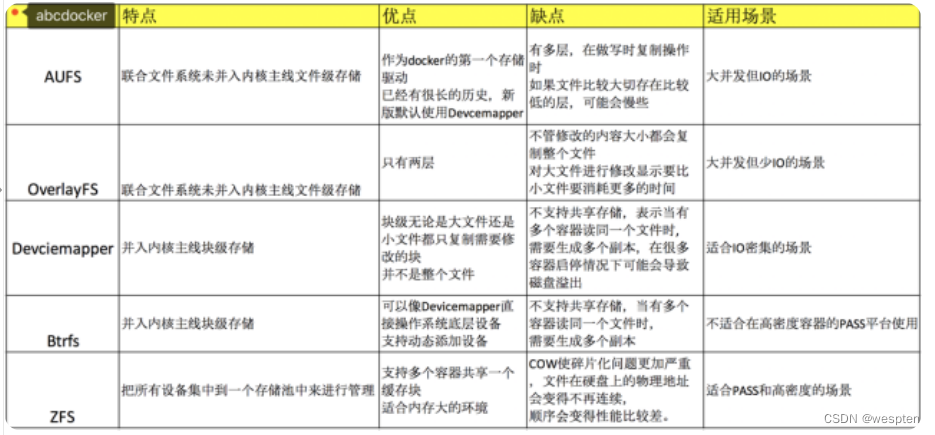

Docker最开始采用AUFS作为文件系统,也得益于AUFS分层的概念,实现了多个Container可以共享一个image。但是由于AUFS未并入Linux内核,且只支持Ubuntu,考虑到兼容性问题,在Docker 0.7 版本中引入了存储驱动,目前,Docker支持AUFS、Btrfs、Devicemapper、OverlayFS、ZFS五种存储驱动。

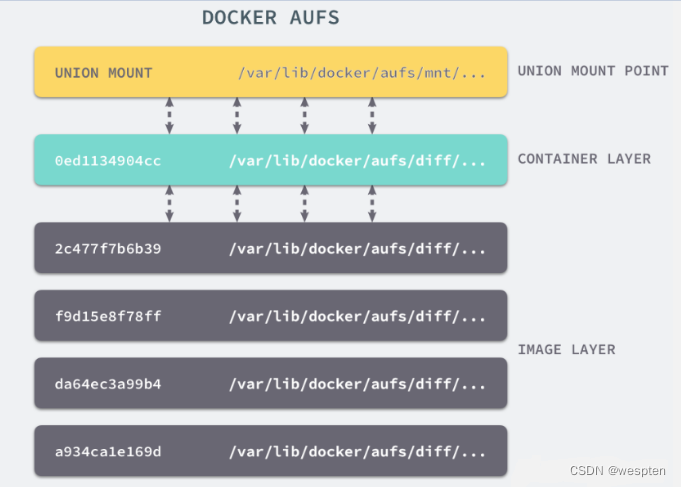

① AUFS

AUFS (Advanced UnionFS)其实就是 UnionFS 的升级版,它能够提供更优秀的性能和效率,是文件级的存储驱动。

AUFS 作为先进联合文件系统,它能够将不同文件夹中的层联合(Union)到了同一个文件夹中,这些文件夹在 AUFS 中称作分支,整个『联合』的过程被称为联合挂载(Union Mount)。

AUFS能透明覆盖一或多个现有文件系统的层状文件系统,把多层合并成文件系统的单层表示。简单来说就是支持将不同目录挂载到同一个虚拟文件下的文件系统。这种文件系统可以一层一层地叠加修改文件。

无论底下有多少层都是只读的,只有最上层的文件系统是可写的。当需要修改一个文件时,AUFS创建该文件的一个副本,使用CoW将文件从只读层复制到可写层进行修改,结果也保存在科协层。在Docker中,只读层就是image,可写层就是Container。

最好是有一个真实的例子来帮助我们理解。

首先,我们建立 company 和 home 两个目录,并且分别为他们创造两个文件:

# tree .

.

|-- company

| |-- code

| `-- meeting

`-- home

|-- eat

`-- sleep

然后我们将通过 mount 命令把 company 和 home 两个目录「联合」起来,建立一个 AUFS 的文件系统,并挂载到当前目录下的 mnt 目录下:

# mkdir mnt

# ll

total 20

drwxr-xr-x 5 root root 4096 Oct 25 16:10 ./

drwxr-xr-x 5 root root 4096 Oct 25 16:06 ../

drwxr-xr-x 4 root root 4096 Oct 25 16:06 company/

drwxr-xr-x 4 root root 4096 Oct 25 16:05 home/

drwxr-xr-x 2 root root 4096 Oct 25 16:10 mnt/

# mount -t aufs -o dirs=./home:./company none ./mnt

# ll

total 20

drwxr-xr-x 5 root root 4096 Oct 25 16:10 ./

drwxr-xr-x 5 root root 4096 Oct 25 16:06 ../

drwxr-xr-x 4 root root 4096 Oct 25 16:06 company/

drwxr-xr-x 6 root root 4096 Oct 25 16:10 home/

drwxr-xr-x 8 root root 4096 Oct 25 16:10 mnt/

root@rds-k8s-18-svr0:~/xuran/aufs# tree ./mnt/

./mnt/

|-- code

|-- eat

|-- meeting

`-- sleep

4 directories, 0 files

通过 ./mnt 目录结构的输出结果,可以看到原来两个目录下的内容都被合并到了一个 mnt 的目录下。

默认情况下,如果我们不对「联合」的目录指定权限,内核将根据从左至右的顺序将第一个目录指定为可读可写的,其余的都为只读。那么,当我们向只读的目录做一些写入操作的话,会发生什么呢?

# echo apple > ./mnt/code

# cat company/code

# cat home/code

apple通过对上面代码段的观察,我们可以看出,当写入操作发生在 company/code 文件时, 对应的修改并没有反映到原始的目录中。

而是在 home 目录下又创建了一个名为 code 的文件,并将 apple 写入了进去。

看起来很奇怪的现象,其实这正是 Union File System 的厉害之处:

Union File System 联合了多个不同的目录,并且把他们挂载到一个统一的目录上。

在这些「联合」的子目录中, 有一部分是可读可写的,但是有一部分只是可读的。当你对可读的目录内容做出修改的时候,其结果只会保存到可写的目录下,不会影响只读的目录。

比如,我们可以把我们的服务的源代码目录和一个存放代码修改记录的目录「联合」起来构成一个 AUFS。前者设置只读权限,后者设置读写权限。

那么,一切对源代码目录下文件的修改都只会影响那个存放修改的目录,不会污染原始的代码。

在 AUFS 中还有一个特殊的概念需要提及一下:

branch – 就是各个要被union起来的目录。

Stack 结构 - AUFS 它会根据branch 被 Union 的顺序形成一个 Stack 的结构,从下至上,最上面的目录是可读写的,其余都是可读的。如果按照我们刚刚执行 aufs 挂载的命令来说,最左侧的目录就对应 Stack 最顶层的 branch。

所以:下面的命令中,最为左侧的为 home,而不是 company:

mount -t aufs -o dirs=./home:./company none ./mnt

什么是 Docker 镜像分层机制?

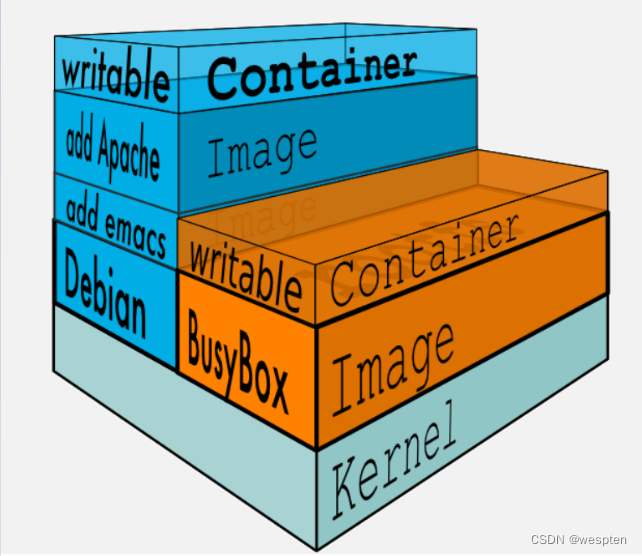

首先,让我们来看下 Docker Image 中的 Layer 的概念:

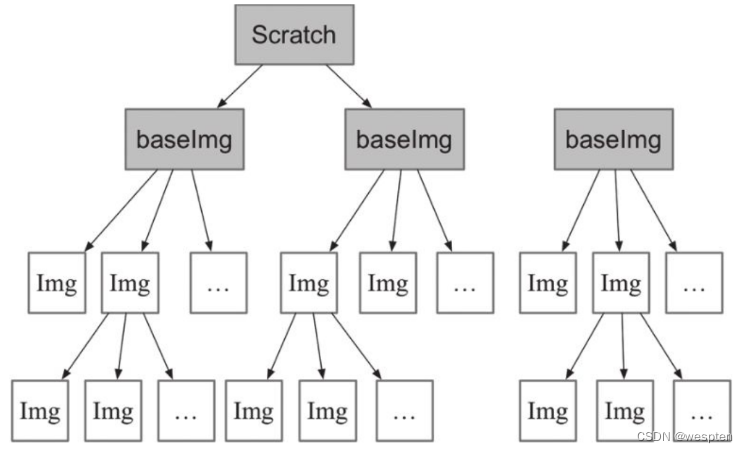

Docker Image 是有一个层级结构的,最底层的 Layer 为 BaseImage(一般为一个操作系统的 ISO 镜像),然后顺序执行每一条指令,生成的 Layer 按照入栈的顺序逐渐累加,最终形成一个 Image。

直观的角度来说,是这个图所示:

每一次都是一个被联合的目录,从目录的角度来说,大致如下图所示:

Docker Image 如何而来呢?

简单来说,一个 Image 是通过一个 DockerFile 定义的,然后使用 docker build 命令构建它。

DockerFile 中的每一条命令的执行结果都会成为 Image 中的一个 Layer。

这里,我们通过 Build 一个镜像,来观察 Image 的分层机制。

Dockerfile:

# Use an official Python runtime as a parent image

FROM python:2.7-slim

# Set the working directory to /app

workdir /app

# copy the current directory contents into the container at /app

copY . /app

# Install any needed packages specified in requirements.txt

RUN pip install --trusted-host pypi.python.org -r requirements.txt

# Make port 80 available to the world outside this container

EXPOSE 80

# Define environment variable

ENV NAME World

# Run app.py when the container launches

CMD ["python", "app.py"]

构建结果:

root@rds-k8s-18-svr0:~/xuran/exampleimage# docker build -t hello ./

Sending build context to Docker daemon 5.12 kB

Step 1/7 : FROM python:2.7-slim

---> 804b0a01ea83

Step 2/7 : workdir /app

---> Using cache

---> 6d93c5b91703

Step 3/7 : copY . /app

---> Using cache

---> feddc82d321b

Step 4/7 : RUN pip install --trusted-host pypi.python.org -r requirements.txt

---> Using cache

---> 94695df5e14d

Step 5/7 : EXPOSE 81

---> Using cache

---> 43c392d51dff

Step 6/7 : ENV NAME World

---> Using cache

---> 78c9a60237c8

Step 7/7 : CMD python app.py

---> Using cache

---> a5ccd4e1b15d

Successfully built a5ccd4e1b15d

通过构建结果可以看出,构建的过程就是执行 Dockerfile 文件中我们写入的命令。构建一共进行了7个步骤,每个步骤进行完都会生成一个随机的 ID,来标识这一 layer 中的内容。 最后一行的 a5ccd4e1b15d 为镜像的 ID。由于我贴上来的构建过程已经是构建了第二次的结果了,所以可以看出,对于没有任何修改的内容,Docker 会复用之前的结果。

如果 DockerFile 中的内容没有变动,那么相应的镜像在 build 的时候会复用之前的 layer,以便提升构建效率。并且,即使文件内容有修改,那也只会重新 build 修改的 layer,其他未修改的也仍然会复用。

通过了解了 Docker Image 的分层机制,我们多多少少能够感觉到,Layer 和 Image 的关系与 AUFS 中的联合目录和挂载点的关系比较相似。

而 Docker 也正是通过 AUFS 来管理 Images 的。

② OverlayFS

OverlayFS是一种和AUFS很类似的文件系统,与AUFS相比,OverlayFS有以下特性; 1) 更简单地设计; 2) 从Linux 3.18开始,就加入了Linux内核主线; 3) 速度更快 因此,OverlayFS在Docker社区关注提高很快,被很多人认为是AUFS的继承者。Docker的overlay存储驱动利用了很多OverlayFS特性来构建和管理镜像与容器的磁盘结构 从Docker1.12起,Docker也支持overlay2存储驱动,相比于overlay来说,overlay2在inode优化上更加高效,但overlay2驱动只兼容Linux kernel4.0以上的版本。

注意: 自从OverlayFS加入kernel主线后,它的kernel模块中的名称就从overlayfs改为overlay了。

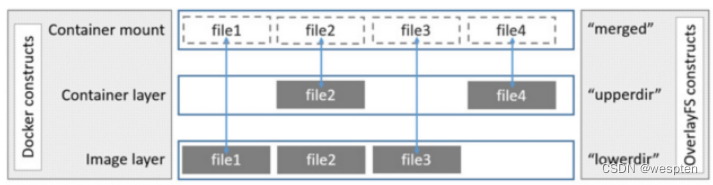

OverlayFS使用两个目录,把一个目录置放于另一个智商,并且对外提供单个统一的视角。这两个目录通常被称作层,这个分层的技术被称作union mount。术语上,下层的目录叫做lowerdir,上层的叫做upperdir。对外展示的统一视图称作merged。

镜像层和容器层是如何处理相同文件的:容器层(upperdir)的文件是显性的,会隐藏镜像层(lowerdir)相同文件的存在,并在容器映射(merged)显示出统一视图。

overlay驱动只能工作在两层之上,也就是说多层镜像不能用多层OverlayFS实现。替代的,每个镜像层在/var/lib/docker/overlay中用自己的目录来实现,使用硬链接这种有效利用空间的方法,来引用底层分享的数据。

注意: Docker1.10之后,镜像层ID和/var/lib/docker中的目录名不再一一对应。

创建一个容器,overlay驱动联合镜像层和一个新目录给容器,镜像顶层中的overlay是只读lowerdir,容器的新目录是可写的upperdir。

OverlayFS (overlay2)镜像分层与共享:overlay驱动只工作在一个lower OverlayFS层之上,因此需要硬链接来实现多层镜像,但overlay2驱动原生地支持多层lower OverlayFS镜像(最多128层)。因此overlay2驱动在合层相关的命令(如build何commit)中提供了更好的性能,与overlay驱动对比,减少了inode消耗

容器overlay读写:有三种场景,容器会通过overlay只读访问文件 容器层不存在的文件 如果容器只读打开一个文件,但该容器不在容器层(upperdir),就要从镜像层(lowerdir)中读取。这会引起很小的性能消耗 只存在于容器层的文件 如果容器只读权限打开一个文件,并且容器只存在于容器层(upperdir)而不是镜像层(lowerdir),那么直接从镜像层读取文件,无额外的性能损耗 文件同时存在于容器层和镜像层 那么会读取容器层的文件,因为容器层(upperdir)隐层了镜像层(lowerdir)的同名文件,因此,也没有额外的性能损耗。

有以下场景容器修改文件 第一次写一个文件,容器第一次写一个已经存在的文件,容器层不存在这个文件。overlay/overlay2驱动执行copy-up操作,将文件从镜像层拷贝到容器层。然后容器修改容器层新拷贝的文件:

1. copy-up 操作只发生在第一次写文件时,后续的对同一个文件的鞋操作都是直接针对拷贝到容器层的文件;

2. OverlayFS只工作在两层中。这比AUFS要在多层镜像中查找时性能要好;

删除文件和目录删除文件时,容器会在镜像层创建一个whiteout文件,而镜像层的文件并没有删除,但是whiteout文件会隐藏它。容器中删除一个目录,容器层会创建一个不透明目录,这和whiteout文件隐藏镜像层的文件类似。

重命名目录只有在源文件和目的路径都在顶层容器层时,才允许执行rename操作,否则返回EXDEV。因此,应用需要能够处理EXDEV,并且回滚操作,执行替代的”拷贝和删除”策略。

在Docker中配置overlay2 存储驱动为了给Docker配置overlay存储驱动,你的Docker host必须在Linux kernel3.18版本之上,并且加载了overlay内核驱动。对于overlay2驱动,kernel版本必须在4.0或以上。OverlayFS可以运行在大多数Linux文件系统之上。

注意: 在开始配置之前,如果你已经在使用Docker daemon,并且有一些想保留的镜像,请将他们push到镜像仓库中。

我这里使用centos7.6内核4.18演示:

1.停止Docker

[root@i4t ~]# systemctl stop docker

2.检查kernel版本,确定overlay的内核模块是否加载

[root@i4t ~]# uname -r

4.18.9-1.el7.elrepo.x86_64

[root@i4t ~]# lsmod |grep overlay

overlay 901120

#如果没有过滤出overlay模块,说明驱动没有加载,使用下面方法进行加载

[root@i4t ~]# modprobe overlay

3.使用verlay2存储来启动docker

#配置方法有2种

(1)在Docker的启动配置文件中添加--storage-driver=overlay2的标志到DOCKER_OPTS中,这样可以持久化配置

(2)或者将配置持久化到配置文件/etc/docker/daemon.json中

"storage-driver":"overlay2"

接下来可以检查Docker是否使用overlay2作为存储引擎:

③ Devicemapper

Device mapper是Linux内核2.6.9后支持的,提供的一种从逻辑设备到物理设备的映射框架机制,在该机制下,用户可以很方便的根据自己需要制定实现存储资源的管理策略。AUFS和OverlayFS都是文件级存储,而Devicemapper是块级存储,所有的操作都是直接对块进行操作,而不是文件。

Devicemapper驱动会先在块设备上创建一个资源池,然后在资源池上创建一个带有文件系统的基本设备,所有镜像都是这个基本设备的快照,而容器则是镜像的快照。所以在容器看到文件系统是资源池上基本设备的文件系统的快照,并不是为容器分配空间。当要写入一个新文件时妹子容器的镜像内为其分配新的块并写入数据,这个叫做用时分配,上面也介绍了。当要修改已有文件时,再使用CoW为容器快照分配块空间,将要修改的数据复制到容器快照中的新快里再进行修改。

Devicemapper驱动默认会创建一个100G的文件包含镜像和容器,每个容器被限制在10G大小的卷内,可以自己配置调整。

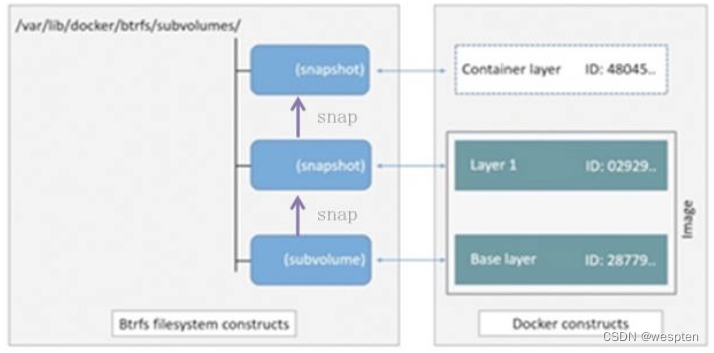

④ Btrfs

Btrfs被称为下一代写时复制的文件系统,并入Linux内核,也是文件级存储,但可以像Devicemapper一直被操作底层设备。Btrfs把文件系统的一部分配置为一个完整的子文件系统,称之为subvolume。

采用subvolume,一个大的文件系统可以被划分多个子文件系统,这些子文件系统共享底层的设备空间,在需要磁盘空间时便从底层设备中分配,比如Btrfs支持动态添加设备。用户在系统中新增加硬盘后,可以使用Btrfs的命令将该设备添加到文件系统中。Btrfs把一个大的文件系统当成一个资源池,配置成多个完整的子文件系统,还可以往资源池里加新的子文件系统,而基础镜像则是子文件系统的快照,每个子镜像和容器都有自己的快照,这些快照都是subvolume的快照。

当写入一个新文件时,在容器的快照里为其分配了一个新的数据块,文件写在这个空间里,叫做用时分配。而当修改已有文件时,使用CoW复制分配一个新的原始数据和快照,在这个新分配的空间变更数据,等结束后再进行相关的数据结构指引到新子文件系统和快照,原来的原始数据和快照没有指针指示,被覆盖。

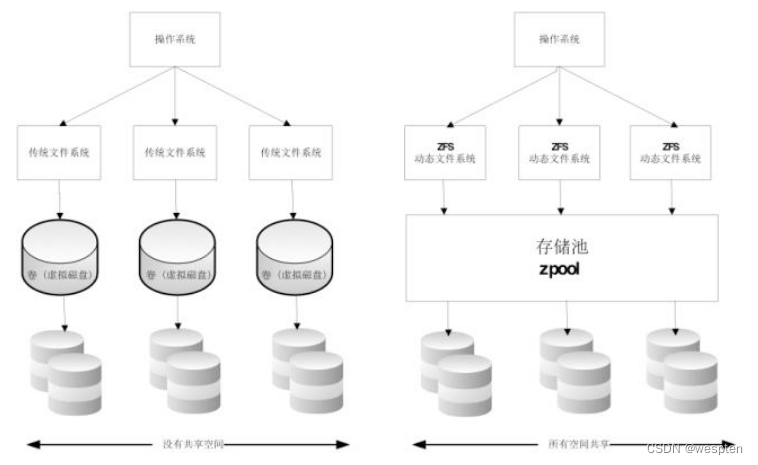

⑤ ZFS

ZFS文件系统是一个革命性的全新的文件系统,它从根本上改变了文件系统的管理方式,ZFS完全抛弃了”卷管理”,不再创建虚拟的卷,而是把所有设备集中到一个存储池中来进行管理,用”存储池”的概念来管理物理存储空间。过去,文件系统都是构建在物理设备之上的,并为数据提供冗余,”卷管理”的概念提供了一个单设备的映像。

而ZFS创建在虚拟的,被称为”zpools”的存储池上。每个存储池由若干虚拟设备(virtual devices,vdevs)组成。这些虚拟设备可以是原始磁盘,也可以是一个RAID的镜像设备,或者是非标准RAID等级的多磁盘组。这样zpool上的文件系统可以使用这些虚拟设备的总存储容量。

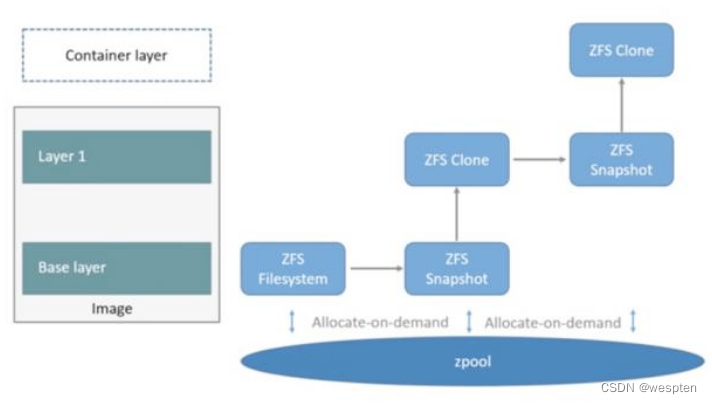

在Docker中使用ZFS,首先从zpool里分配一个ZFS文件系统给镜像的基础层,而其它镜像层则是这个ZFS文件系统快照的克隆,快照只是只读的,而克隆是可写的,当容器启动时则在镜像的最顶层生成一个可写成:

当要写一个新文件时,使用按需分配,一个新的数据块从zpool里生成,新的数据写入这个块,而这个新的空间存储于容器(ZFS的克隆)里。当要修改一个已存在的文件时,使用写时复制,分配一个新空间并把原始数据复制到新空间完成修改。

存储驱动的对比及适应场景:

一般来说,overlay2驱动更快一些,几乎肯定比AUFS和devicemapper更快,在某些情况下,可能比Btrfs也快。在使用overlay2存储驱动时,需要注意以下几点:

1. Page Caching 页缓存 OverlayFS支持页缓存,也就是说如果多个容器访问同一个文件,可以共享一个或多个页缓存选项。这使得overlay2驱动高效地利用了内存,是Pass平台或者高密度场景很好的选择;

2. copy_up 和AUFS一样,在容器第一次修改文件时,OverlayFS都需要执行copy_up操作,这会给操作带来一些延迟————尤其这个拷贝很大的文件时,不过一旦文件已经执行了这个向上拷贝的操作后,所有后续对这个文件的操作都只针对这份容器层的拷贝而已;

3. Inode limits 使用overlay存储驱动可能导致过多的inode消耗,尤其是Docker host上镜像和容器的数目增长时。大量的镜像或者很多容器启停,会迅速消耗该Docker host的inode。但是overlay2 存储驱动不存在这个问题;

针对overlay2小结:overlay2存储驱动已经成为了Docker首选存储驱动,并且性能优于AUFS和devicemapper。不过,也带来了一些与其他文件系统不兼容性,如对open和rename操作的支持,另外,overlay和overlay2相比,overlay2支持了多层镜像,优化了inode的使用。

7、原理总结

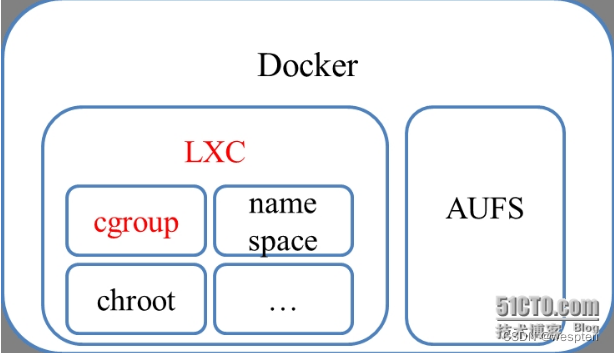

Dockers=LXC+AUFS

- LXC负责资源管理

- AUFS负责镜像管理

Docker约等于LXC+AUFS(之前只支持ubuntu时)(Docker0.9.0版本开始引入libcontainer,可以视作LXC的替代品),其中LXC负责资源管理,AUFS负责镜像管理。

LXC包括cgroup,namespace,chroot等组件,并通过cgroup资源管理:

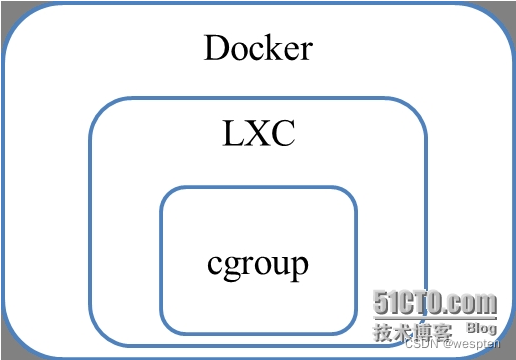

所以只从资源管理这条线来看的话,Docker、LXC、Cgroup三者的关系是:Cgroup在最底层落实资源管理,LXC在cgroup上封装了一层,Docker又在LXC封装了一层,关系图如图所示。因此,要想玩转Docker,有必要了解负责资源管理的CGroup和LXC。

Cgroup其实就是linux提供的一种限制,记录,隔离进程组所使用的物理资源管理机制;也就是说,Cgroup是LXC为实现虚拟化所使用资源管理手段,我们可以这样说,底层没有cgroup支持,也就没有lxc,更别说docker的存在了,这需要我们掌握和理解三者之间的关系。

我们在把重心转移到LXC这个相当于中间件上,上述我们提到LXC是建立在cgroup基础上的,我们可以粗略的认为LXC=Cgroup+namespace+Chroot+veth+用户控制脚本。LXC利用内核的新特性(cgroup)来提供用户空间的对象,用来保证资源的隔离和对应用系统资源的限制。

① Cgroup基本概念与术语

任务(task):

在Cgroups中,任务就是系统的一个进程。

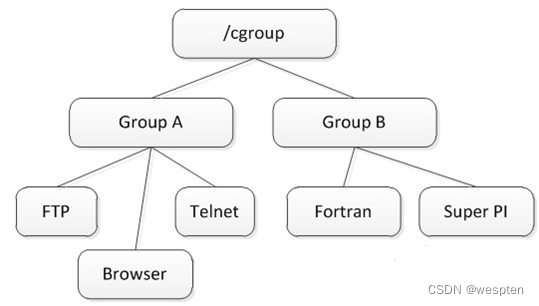

控制族群(control group):

控制族群就是一组按照某种标准划分的进程,控制族群通常按照应用划分,即与某应用相关的一组进程,被划分为一个进程组,即控制族群(control group)。Cgroups中的资源控制都是以控制族群为单位实现。

一个进程可以加入到某个控制族群,也可以从一个进程组迁移到另一个控制族群。一个进程组的进程可以使用Cgroups以控制族群为单位分配的资源,同时受到Cgroups以控制族群为单位设定的限制。

层级(hierarchy):

控制族群可以组织成hierarchical的形式,既一颗控制族群树。控制族群树上的子节点控制族群是父节点控制族群的孩子,继承父控制族群的特定的属性。

控制族群树的示意图如图所示:

子系统(subsystem):

一个子系统就是一个资源控制器,比如cpu子系统就是控制cpu时间分配的一个控制器。子系统必须附加(attach)到一个层级上才能起作用,一个子系统附加到某个层级以后,这个层级上的所有控制族群都受到这个子系统的控制。

② Cgroup子系统介绍

a) blkio -- 这个子系统为块设备设定输入/输出限制,比如物理设备(磁盘,固态硬盘,USB等等)。

b) cpu -- 这个子系统使用调度程序提供对cpu 的 Cgroup 任务访问。

c) cpuacct -- 这个子系统自动生成Cgroup中任务所使用的 cpu 报告。

d) cpuset-- 这个子系统为 Cgroup中的任务分配独立cpu(在多核系统)和内存节点。

e) devices -- 这个子系统可允许或者拒绝Cgroup中的任务访问设备。

f) freezer -- 这个子系统挂起或者恢复Cgroup中的任务。

g) memory -- 这个子系统设定Cgroup中任务使用的内存限制,并自动生成由那些任务使用的内存资源报告。

h) net_cls -- 这个子系统使用等级识别符(classid)标记网络数据包,可允许Linux 流量控制程序(tc)识别从具体cgroup 中生成的数据包。

i) ns -- 名称空间子系统。

Cgroup具有不同的挂载方法——“多挂载点”和“单挂载点”。子系统“多挂载点”挂载就是指不同子系统的文件挂载在不同的目录下,每个子系统各有一个挂载点,目录结构如图所示:

Cgroup对应服务cgconfig默认使用的就是“多挂载点”的方法。“单挂载点”则是指所有子系统的文件都挂载在同一个目录下,所有子系统都统一挂载在一个挂载点,目录结构如图所示:

③ Cgroup安装配置

1) Cgroup安装

安装Cgroups需要libcap-devel和libcgroup两个相关的包,CentOS上可以通过yum的方式下载安装,具体的命令为:

yum install gcc, libcap-devel,libcgroup, bridge-utils2) Cgroup挂载配置

Cgroup对应服务名称为cgconfig,cgconfig默认采用“多挂载点”挂载。经过实际测试,发现在CentOS环境中应采用“单挂载点”进行挂载,因此应当卸载原有cgroup文件系统,并禁用cgconfig:

cgclear或者sudo service cgconfig stop # 停止cgconfig,卸载cgroup目录

sudo chkconfig cgconfig off # 禁用cgconfig服务,避免其开机启动然后采用“单挂载点”方式重新挂载cgroup,可以直接手动挂载,这样仅当次挂载成功:

mount -t cgroup none /cgroup然后编辑/etc/fstab/,输入下列内容。这样每次开机后都会自动挂载:

none /cgroup cgroup defaults 0 03)常用的Cgroup相关命令和配置文件

service cgconfig status|start|stop|restart #查看已存在子系统

lssubsys –am #查看已存在子系统

cgclear # 清除所有挂载点内部文件,相当于service cgconfig stop

cgconfigparser -l /etc/cgconfig.conf #重新挂载

Cgroup默认挂载点(CentOS):/cgroup

cgconfig配置文件:/etc/cgconfig.conf4)libcgroup Man Page简介

man 1 cgclassify -- cgclassify命令是用来将运行的任务移动到一个或者多个cgroup。

man 1 cgclear -- cgclear 命令是用来删除层级中的所有cgroup。

man 5 cgconfig.conf -- 在cgconfig.conf文件中定义cgroup。

man 8 cgconfigparser -- cgconfigparser命令解析cgconfig.conf文件和并挂载层级。

man 1 cgcreate -- cgcreate在层级中创建新cgroup。

man 1 cgdelete -- cgdelete命令删除指定的cgroup。

man 1 cgexec -- cgexec命令在指定的cgroup中运行任务。

man 1 cgget -- cgget命令显示cgroup参数。

man 5 cgred.conf -- cgred.conf是cgred服务的配置文件。

man 5 cgrules.conf -- cgrules.conf 包含用来决定何时任务术语某些 cgroup的规则。

man 8 cgrulesengd -- cgrulesengd 在 cgroup 中发布任务。

man 1 cgset -- cgset 命令为 cgroup 设定参数。

man 1 lscgroup -- lscgroup 命令列出层级中的 cgroup。

man 1 lssubsys -- lssubsys 命令列出包含指定子系统的层级。④ Linux Container(LXC)

LinuxContainer容器可以提供轻量级的虚拟化,以便隔离进程和资源,而且不需要提供指令解释机制以及全虚拟化的其他复杂性。容器有效地将由单个操作系统管理的资源划分到孤立的组中,以更好地在孤立的组之间平衡有冲突的资源使用需求。

LXC建立在CGroup基础上,我们可以粗略的认为LXC = Cgroup+ namespace + Chroot + veth +用户态控制脚本。LXC利用内核的新特性(CGroup)来提供用户空间的对象,用来保证资源的隔离和对于应用或者系统的资源控制。

根据LXC官网(Linux Containers)的描述,LXC具有以下特性:

Current LXC uses the following kernel features to contain processes:

Kernel namespaces (ipc, uts, mount, pid, network and user)

Apparmor and SELinux profiles

Seccomp policies

Chroots (using pivot_root)

Kernel capabilities

Control groups (cgroups)1)LXC的优势

与虚拟化相比,它的优势在于:

a)不需要指令级模拟;

b)不需要即时(Just-in-time)编译;

c)容器可以在cpu核心的本地运行指令,而不需要任何专门的解释机制;

d)避免了准虚拟化和系统调用替换中的复杂性;

总结来说,就是LXC更加轻量级,具有更小的性能开销、更快的相应时间。

2)LXC安装

从sourceforge.net/projects/lxc/files/lxc下载lxc源码,解压后进入目录,执行以下命令:

./configure

make

sudo make install3)LXC常用命令

lxc-version # 用于显示系统LXC的版本号

lxc-checkconfig # 查看内核是否支持LXC

lxc-create -n name -f config

# 注:1.采用lxc-create创建的容器,在停止运行后,不会被销毁,要采用lxc-destroy命令才能销毁

# 2.容器命令空间是全局的,系统中不允许存在重名的容器,如果-n 后面跟一个已经存在的容器名,创建会失败

lxc-start -n name -f config cmd #用于在容器中执行给定命令

lxc-execute -n name -f config cmd #用于在一个容器执行应用程序

# 备注:lxc-start只启动一个进程,即cmd;lxc-execute 启动两个进程,lxc-init和cmd

lxc-kill -n name #给SIGNUM信号

lxc-stop -n name # 停止lxc容器内所有进程

lxc-destroy -n name # 销毁容器

lxc-cgroup -n name subsys value #用于获取或调整与cgroup相关的参数,例如 lxc-cgroup -n name cpuset.cpus “0,3” ,控制资源

lxc-info # 用户获取一个容器的状态

lxc-monitor # 监控一个容器状态的变换,当一个容器的状态变化时,此命令会在屏幕上打印出容器的状态

lxc-ls # 列出当前系统所有的容器

lxc-ps # 列出特定容器中运行的进程4)资源控制

Cores

lxc.cgroup.cpuset.cpus=1,2,3

cpu share

lxc.cgroup.cpu.shares=1024 # default

Memory usage (!Debian)

lxc.cgroup.memory.limit_in_bytes = 256M

lxc.cgroup.memory.memsw.limit_in_bytes = 1G

disk (blkio)

disk space – standard LVM, quota...

echo 100 > /cgroup/disk1/blkio.weight # XXX < 1000 !

echo "3:0 1048576" >/cgroup/disk1/blkio.throttle.read_bps_device

lxc.cgroup.blkio.weight = 1005)配置文件样例

lxc.utsname = host_name

lxc.tty = 1

lxc.network.type = veth

lxc.network.flags = u

lxc.network.link = br0

lxc.network.ipv4 = 192.168.120.105/16

lxc.network.name = eth0

#lxc.mount = ./fstab

#lxc.rootfs = /rootfs

lxc.cgroup.cpuset.cpus = 0

lxc.cgroup.cpu.shares = 80使用中的一些小问题:

lxc-ls #列出所有lxc,但是在centos下时常不好用。备注:lxc-create之后,lxc-ls才能看到。但是只lxc-create,而不execute,则并未实际启动congtainer,相应cgroup并未实际挂载。

lxc-ps # 列出指定container内的所有进程。备注:lxc-ps –n name或者lxc-ps –n name -- -ef二、Docker架构与生命周期

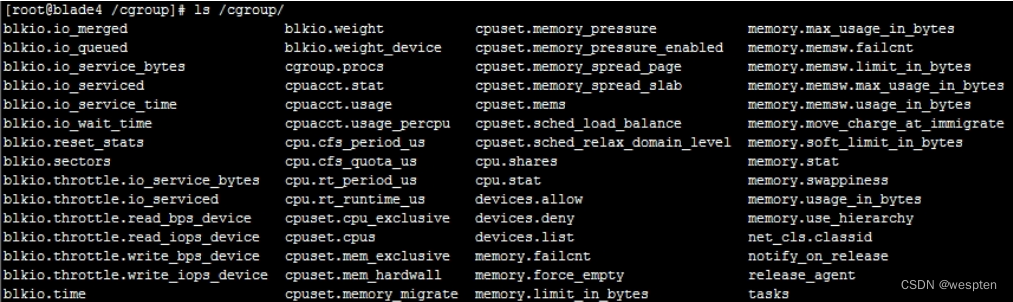

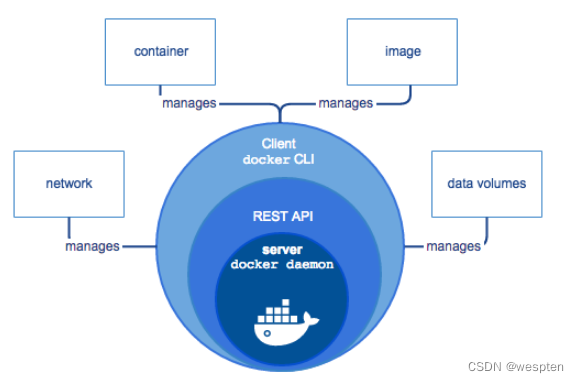

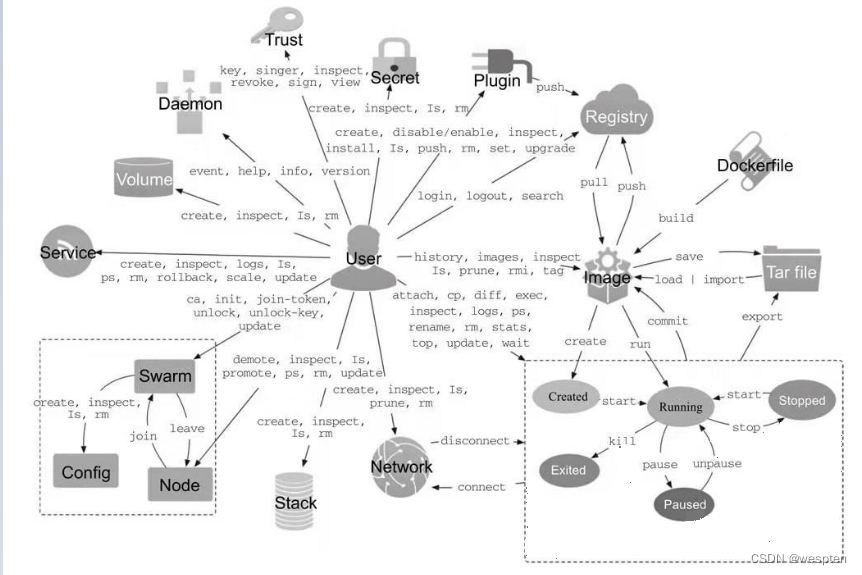

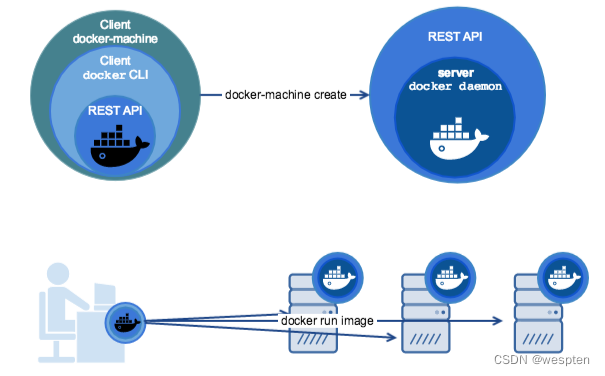

1、Docker架构

Docker Engine是一个C/S架构的应用程序,主要包含下面几个组件:

1. 常驻后台进程Dockerd;

2. 一个用来和Dockerd交互的REST API Server;

3. 命令行CLI接口,通过和REST API进行交互;

Docker包含三个基本概念:

1. 镜像(Image):Docker 镜像(Image),就相当于是一个 root 文件系统。比如官方镜像 ubuntu:16.04 就包含了完整的一套 Ubuntu16.04 最小系统的 root 文件系统。

2. 容器(Container):镜像(Image)和容器(Container)的关系,就像是面向对象程序设计中的类和实例一样,镜像是静态的定义,容器是镜像运行时的实体。容器可以被创建、启动、停止、删除、暂停等,且容器之间是彼此互相隔离、互不可见的。镜像自身是只读的。容器从镜像启动的时候,会在镜像的最上层创建一个可写层。

3. 仓库(Repository):仓库可看成一个代码控制中心,用来保存镜像。同一类的镜像会存放在一个仓库中,并使用 tag 来进行区分。其中最大的公开仓库是官方的 Docker Hub,其次国内云服务供应商(如腾讯云、阿里云等)也提供了公开的仓库,国内用户的话最好访问它们。

Docker 容器通过 Docker 镜像来创建。

| 概念 | 说明 |

|---|---|

| Docker 镜像(Images) | Docker 镜像是用于创建 Docker 容器的模板,比如 Ubuntu 系统。 |

| Docker 容器(Container) | 容器是独立运行的一个或一组应用,是镜像运行时的实体。 |

| Docker 客户端(Client) | Docker 客户端通过命令行或者其他工具使用 Docker SDK (https://docs.docker.com/develop/sdk/) 与 Docker 的守护进程通信。 |

| Docker 主机(Host) | 一个物理或者虚拟的机器用于执行 Docker 守护进程和容器。 |

| Docker Registry | Docker 仓库用来保存镜像,可以理解为代码控制中的代码仓库。Docker Hub(https://hub.docker.com) 提供了庞大的镜像集合供使用。一个 Docker Registry 中可以包含多个仓库(Repository);每个仓库可以包含多个标签(Tag);每个标签对应一个镜像。通常,一个仓库会包含同一个软件不同版本的镜像,而标签就常用于对应该软件的各个版本。我们可以通过 <仓库名>:<标签> 的格式来指定具体是这个软件哪个版本的镜像。如果不给出标签,将以 latest 作为默认标签。 ———————————————— 版权声明:本文为CSDN博主「架构师-尼恩」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。 原文链接:https://blog.csdn.net/crazymakercircle/article/details/121134690 |

Docker使用了C/S体系架构,使用远程API来管理和创建Docker容器。Docker客户端与Docker守护进程通信,Docker守护进程负责构建,运行和分发Docker容器。Docker客户端和守护进程可以在同一个系统上运行,也可以将Docker客户端连接到远程Docker守护进程。Docker客户端和守护进程使用REST API通过UNIX套接字或网络接口进行通信。

Docker damon DockerD用来监听Docker API的请求和管理Docker对象,比如镜像、容器、网络和Volume Docker Client docker client是我们和Docker进行交互的最主要的方式方法,比如可以通过docker run来运行一个容器,然后我们的这个client会把命令发送给上面的DockerDocker Registry 用来存储Docker镜像的仓库,Docker Hub是Docker官方提供的一个公共仓库,而且Docker默认也是从Docker Hub上查找镜像的,当然你也可以很方便的运行一个私有仓库。

当我们使用docker pull或者docker run命令时,就会从我们配置的Docker镜像仓库中去拉取镜像,使用docker push命令时,会将我们构建的镜像推送到对应的镜像仓库中 Images 镜像,镜像是一个制度模板,带有Docker容器的说明,一般来说的,镜像会基于另外的一些基础镜像上面安装一个Nginx服务器,这样就可以构建一个属于我们自己的镜像了 Containers 容器,容器是一个镜像的可运行的实例,可以使用Docker REST API或者CLI来操作容器,容器的实质是进程,但与直接在宿主执行的实例进程不同,容器进程属于自己的独立的命名空间。

因此容器可以拥有自己的root文件系统、自己的网络配置、自己的进程空间、甚至自己的用户ID。容器内的经常是运行在一个隔离的环境里,使用起来,就好像在一个独立于宿主的系统下操作一样,这种特性使得容器封装的应用比直接在宿主运行更加安全 。

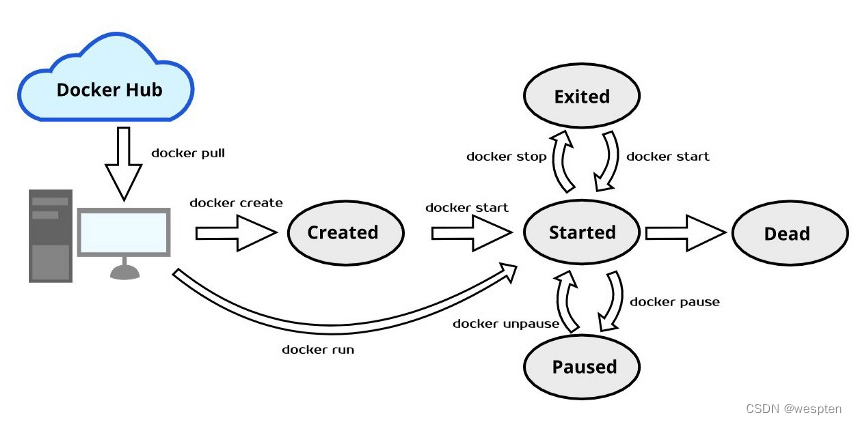

2、Docker生命周期

生命周期是指容器所处的状态 ,容器其实本质是Host宿主机的进程,操作系统对于进程的管理是基于进程的状态切换的,进程从创建到销毁可能经过的路径图可以称之为“生命周期”。

容器的五种状态:

1. created:初建状态

2. running:运行状态

3. stopped:停止状态

4. paused: 暂停状态

5. deleted: 删除状态

容器在执行某种命令后进入的过度状态:

docker create : 创建容器后,不立即启动运行,容器进入初建状态;

docker run : 创建容器,并立即启动运行,进入运行状态;

docker start : 容器转为运行状态;

docker stop : 容器将转入停止状态;

docker kill : 容器在故障(死机)时,执行 kill(断电),容器转入停止状态,这种操作容易丢失数据,

除非必要,否则不建议使用;

docker restart : 重启容器,容器转入运行状态;

docker pause : 容器进入暂停状态;

docker unpause : 取消暂停状态,容器进入运行状态;

docker rm : 删除容器,容器转入删除状态(如果没有保存相应的数据库,则状态不可见);完整生命周期图如下:

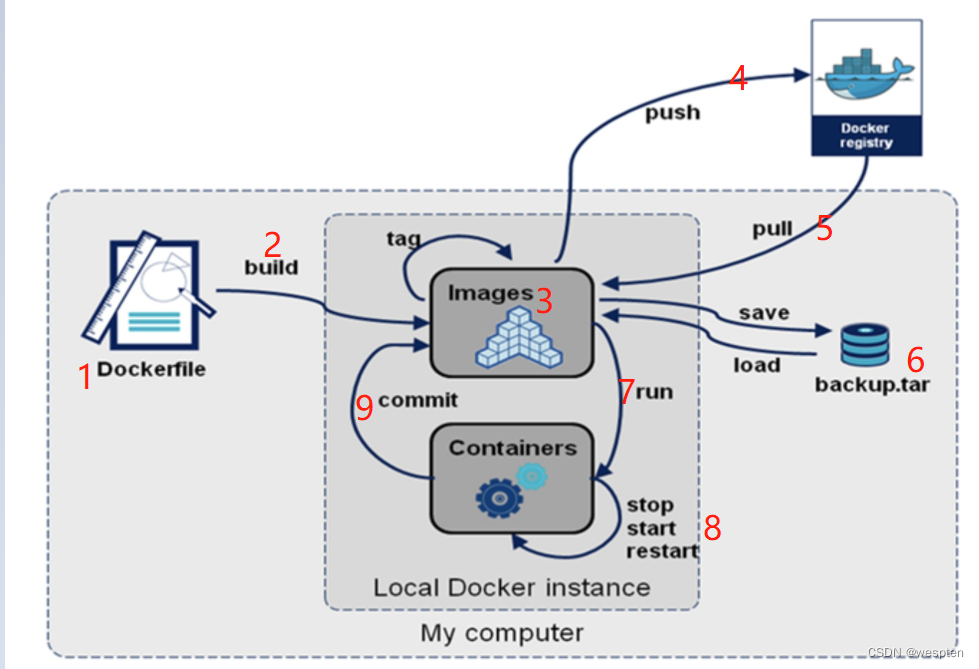

下面详细解释一下各个过程:

1. Dockerfile:一个用于构建docker image的脚本(这个我们暂时还不会用到);Dockerfile其实就是一个脚本文件,作用是自定义一个docker镜像。回想一下上一节讲的Nginx镜像,我们是从仓库里面pull拉取下来的,也就是说Nginx镜像是官方提供好的,我们可以直接拿来用的;但是如果我们想在本地自定义的构建一个镜像呢?就得需要使用Dockerfile自己去写了;

2. 通过build命令(docker build)可以构建dockerfile生成镜像image;我们生成的的镜像文件被images所管理;

3. 在images中,我们可以通过docker images命令来查看有哪些镜像文件。images是存储在机器本地的;但是在本地存着就没办法跟别人交互;

4. 如果想让本地的镜像文件和别人进行交互,就得通过网络并利用docker push命令传输到镜像仓库(Docker registry)中;镜像仓库类型有公开仓库(docker hub)和私有仓库(自行搭建);

5. 我们还可以从镜像仓库中获取我们想要的镜像,即docker pull;例如我们前面上一节讲到的从镜像仓库中获取Nginx镜像:docker pull Nginx就是一个例子;

6. 除了利用push和pull实现在网络中管理镜像,我们还可以利用save和load实现在本地管理镜像;docker save可以用于导出镜像为一个压缩文件;docker load可以用于导入镜像;这两个操作的作用主要是用于我们在公司工作过程中,和同事之间传递、分享镜像文件;

7. 利用run命令(docker run),我们可以将镜像运行出一个具体的容器(containers),这个过程我们在上一节也利用Nginx演示过了;

8. 在容器(containers)内部,我们可以利用stop、start、restart等命令对容器进行操作了;docker stop +容器id/名字:停止容器;docker start +容器id/名字:启动容器;docker restart +容器id/名字:重启容器;

9. 最后,commit的作用:当我们再容器中,进行新增或者修改等操作,定制安装了一些软件,并想要提交该容器生成一个镜像时,就要用到commit了(命令为docker commit +容器id);

[root@localhost ~]# docker commit

"docker commit" requires at least 1 and at most 2 arguments.

See 'docker commit --help'.

Usage: docker commit [OPTIONS] CONTAINER [REPOSITORY[:TAG]]

Create a new image from a container's changes举个例子:

我们获取了一个centos镜像,且是最小化安装的,连vim都没有,我们先(docker run centos)运行这个容器,运行这个容器时,我们是可以进入到容器内的,假设我们在容器内安装了一个vim,此时我们利用docker commit 容器id提交该容器,提交后生成的镜像就是携带了vim 的centos系统了;以后我们再次docker run此镜像生成的容器,就是携带vim的容器了。

三、Docker安装与容器操作命令

Docker Engine 是 docker 容器和核心组件,官方提供了社区版本(Community Edition, CE)和企业版本(Enterprise Edition,EE)。官方还提供了除引擎之外的其他服务:Docker Hub、Docker Cloud等。

- Docker引擎: 包括支持在桌面系统或云平台安装Docker, 以及为企业提供简单安全弹性的容器集群编排和管理;

- dockerhub: 官网提供的云托管服务, 可以提供公有或私有的镜像仓库;

- DockerCloud: 官网提供的容器云服务, 可以完成容器的部署与管理, 可以完整地支持容器化项目, 还有CI、 CD功能。

1、Docker安装

注:本系列都是使用 CentOS7,运行 Docker。

1. 安装 yum 源

sudo yum install -y yum-utils device-mapper-persistent-data lvm2

sudo yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo2. 安装 docker 社区版

sudo yum install docker-ce docker-ce-cli containerd.io3. 启动 docker 服务

sudo systemctl start docker4. 验证

docker run hello-world执行成功会输出 Hello from docker!

2、删除 docker

删除 docker 的命令为:

sudo yum remove docker-ce删除 docker 后,它对应的配置信息和镜像、卷等文件不会删除,可以使用以下命令清除:

sudo rm -rf /var/lib/docker注:其他系统上的安装方式这里就不详细说明了,详情请参考官方:Docker Documentation | Docker Documentation

3、配置 docker 服务

为了避免每次使用Docker命令时都需要切换到特权身份, 可以将当前用户加入安装中自动创建的docker用户组, 代码如下:

sudo usermod -aG docker USER_NAMEDocker 服务启动时实际上是调用了 dockerd 命令, 支持多种启动参数。因此, 用户可以直接通过执行dockerd 命令来启动Docker服务, 如下面的命令启动Docker服务, 开启Debug模式, 并监听在本地的2376端口:

dockerd -D -H tcp://127.0.0.1:2376这些选项可以写入/etc/docker/路径下的daemon.json文件中, 由dockerd 服务启动时读取:

{

"debug": true,

"hosts": ["tcp://127.0.0.1:2376"]

}当然, 操作系统也对Docker服务进行了封装, 以使用Upstart 来管理启动服务的 Ubuntu 系统为例, Docker服务的默认配置文件为/etc/default/docker, 可以通过修改其中的DOCKER_OPTS来修改服务启动的参数, 例如让Docker服务开启网络2375端口的监听:

DOCKER_OPTS="$DOCKER_OPTS -H tcp://0.0.0.0:2375 -H unix:///var/run/docker.sock"设置overlay2为默认存储驱动,并配置加速器:

mkdir -p /etc/docker/

cat >/etc/docker/daemon.json <<EOF

{

"exec-opts":["native.cgroupdriver=systemd"],

"registry-mirrors":["https://hjvrgh7a.mirror.aliyuncs.com"],

"log-driver":"json-file",

"log-opts":{

"max-size":"100m"

},

"insecure-registries":["harbor.i4t.com"],

"storage-driver":"overlay2"

}

EOF这里配置当时镜像加速器,添加我们harbor仓库,可以不进行配置,但是建议配置。默认docker hub需要https协议,使用上面配置不需要配置https。

修改之后, 来重启Docker服务,并设置docker开机启动:

sudo systemctl enable --Now docker手动设置docker命令补全:

yum install -y epel-release bash-completion && cp /usr/share/bash-completion/completions/docker /etc/bash_completion.d/对于CentOS、 RedHat等系统, 服务通过systemd来管理, 配置文件路径为 /etc/systemd/system/docker.service.d/docker.conf 。 更新配置后需要通过 systemctl 命令来管理Docker服务:

sudo systemctl daemon-reload

sudo systemctl start docker.service此外, 如果服务工作不正常, 可以通过查看Docker服务的日志信息来确定问题, 例如在RedHat系统上日志文件可能为/var/log/messages, 在Ubuntu或CentOS系统上可以执行命令journalctl-u docker.service。每次重启Docker服务后, 可以通过查看Docker信息(docker info 命令) , 确保服务已经正常运行。

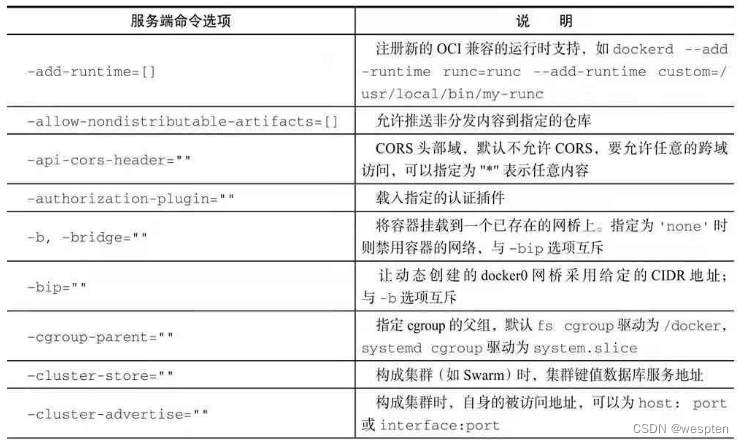

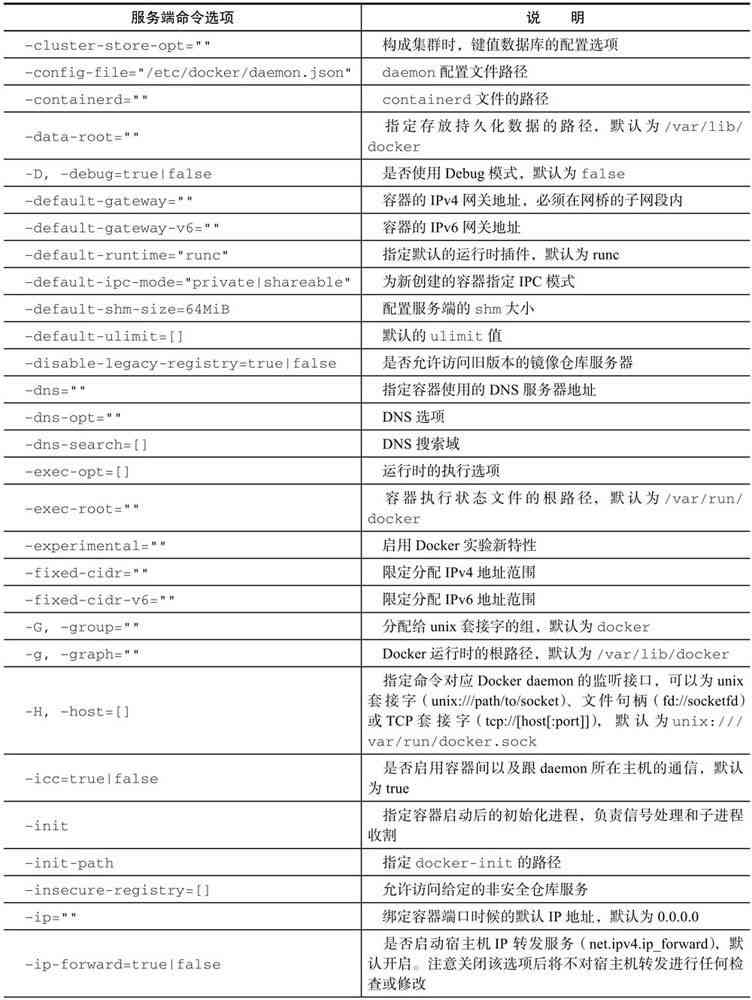

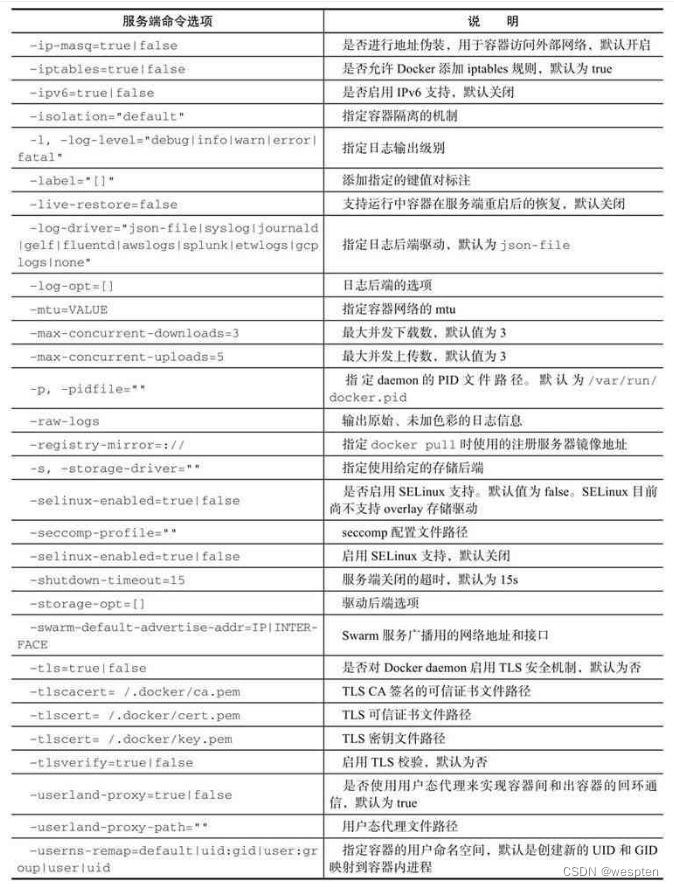

dockerd启动服务端主进程支持的命令选项如下:

4、容器操作命令

docker 的容器是镜像的一个运行实例。docker 镜像是只读文件,而容器则带有运行时的可读写层,而且容器中的应用进程处于运行状态。接下来我们就来学习 docker 容器的具体操作。

1)创建容器

创建容器相关的命令有 create、start、run、wait 和 logs。

使用命令 docker [container] create 新建一个容器:

# docker create -it ubuntu:latest

63197c11dc16e893dc8bb032ebf92419032cc40d6dcb6f750a16e9e308d52584

# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

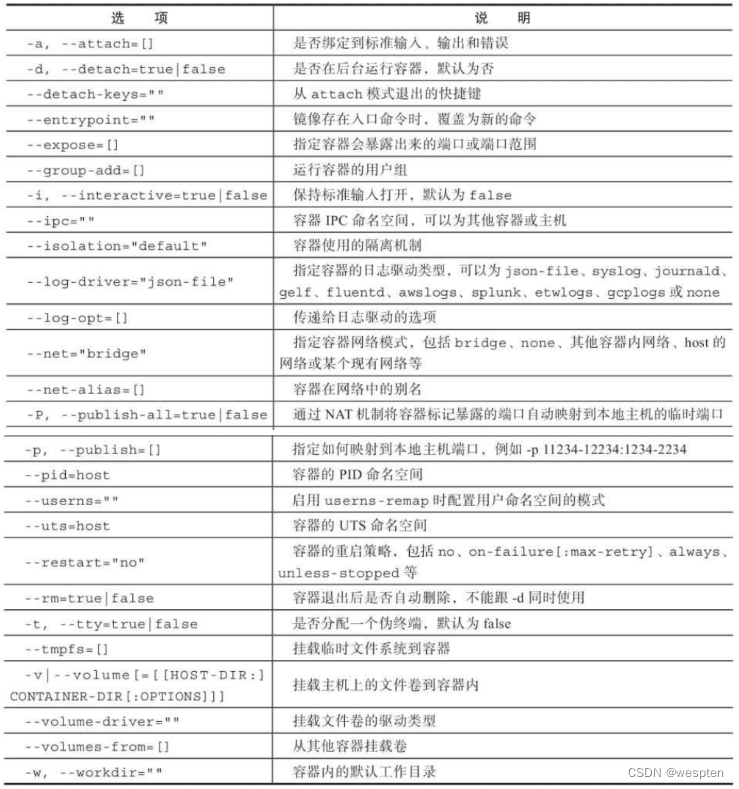

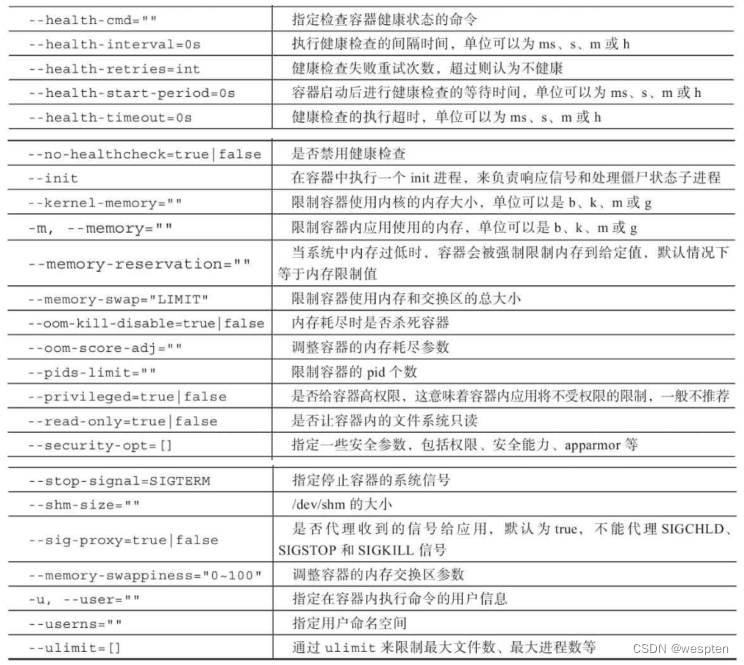

63197c11dc16 ubuntu:latest "/bin/bash" 5 seconds ago Created hardcore_ramandocker create命令对应的参数有很多,create 命令与容器运行模式相关的选项,下面列出对应的选项:

create命令与容器环境和配置相关的选项:

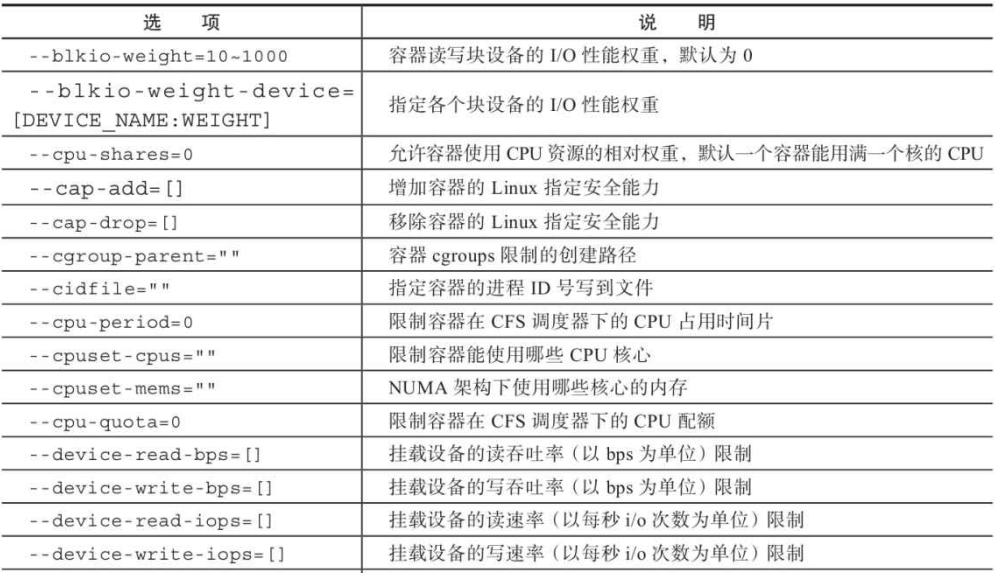

create 命令与容器资源限制和安全保护相关的选项:

以及:

2)启动容器

使用该命令新建的容器处于停止状态,使用命令 docker [container] start启动容器,通过 docker [container] ps查看运行中的容器:

# docker start 63197c11dc16e893dc8bb032ebf92419032cc40d6dcb6f750a16e9e308d52584

63197c11dc16e893dc8bb032ebf92419032cc40d6dcb6f750a16e9e308d52584

# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

63197c11dc16 ubuntu:latest "/bin/bash" About a minute ago Up 3 seconds hardcore_raman我们还可以将新建和启动容器合起来,命令 docker [container] run 就是两个命令的组合:

# docker run ubuntu /bin/echo "Hello World"

Hello World

# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

5982bad8cf83 ubuntu "/bin/echo 'Hello Wo…" 7 seconds ago Exited (0) 6 seconds ago exciting_lalandedocker run参数

docker run 启动容器,可以指定参数设置容器启动策略,如下:

- -d 容器会在后台运行并不会把输出(STDOUT)打印到宿主机上;

- -t 让docker分配一个伪终端并绑定到容器的标准输入上;

- -i 让容器的标准输入保持打开;

- -p 映射本地端口和容器端口,格式为-p ip:hostPort:containerPort或者-p hostPort:containerPort;

- -P 大写的P,使用 -P 标记时,Docker 会随机映射一个 49000~49900 的端口到内部容器开放的网络端口;

- --rm 在容器执行完毕后将其删除,默认只能删除已停止的容器,如果想要删除正在运行中容器,可增加-f参数;

- --name xxx 执行容器的name;

注意,容器是否会长久运行,是和docker run指定的命令有关,和 -d 参数无关。

使用 run 命令实际上在后台包含了以下过程:

- 检查本地是否存在指定的镜像, 不存在就从公有仓库下载;

- 利用镜像创建一个容器, 并启动该容器;

- 分配一个文件系统给容器, 并在只读的镜像层外面挂载一层可读写层;

- 从宿主主机配置的网桥接口中桥接一个虚拟接口到容器中去;

- 从网桥的地址池配置一个IP地址给容器;

- 执行用户指定的应用程序;

- 执行完毕后容器被自动终止。

注:运行结束后容器就会停止。

还可以在创建时启动一个 bash 终端,这样就能和容器交互了:

# docker run -it ubuntu bash

root@264cf6ed894e:/# - -t:选项让Docker分配一个伪终端(pseudo-tty) 并绑定到容器的标准输入上。

- -i:则让容器的标准输入保持打开。

容器支持的重启策略包括 always、unless-stopped 和 on-Failed:

always 策略是一种简单的方式。除非容器被明确停止,比如通过 docker container stop 命令,否则该策略会一直尝试重启处于停止状态的容器。一种简单的证明方式是启动一个新的交互式容器,并在命令后面指定 --restart always 策略,同时在命令中指定运行 Shell 进程。

当容器启动的时候,会登录到该 Shell,退出 Shell 时会杀死容器中 PID 为 1 的进程,并且杀死这个容器。但是因为指定了 --restart always 策略,所以容器会自动重启。如果运行 docker container ls 命令,就会看到容器的启动时间小于创建时间。

$ docker container run --name neversaydie -it --restart always alpine sh

//等待几秒后输入exit

/# exit

$ docker container ls

CONTAINER ID IMAGE COMMAND CREATED STATUS

0901afb84439 alpine "sh" 35 seconds ago Up 1 second容器于 35s 前被创建,但却在 1s 前才启动。这是因为在容器中输入退出命令的时候,容器被杀死,然后 Docker 又重新启动了该容器。

--restart always 策略有一个很有意思的特性,当 daemon 重启的时候,停止的容器也会被重启。

例如,新创建一个容器并指定 --restart always 策略,然后通过 docker container stop命令停止该容器,现在容器处于 Stopped (Exited) 状态。但是,如果重启 Docker daemon,当 daemon 启动完时,该容器也会重新启动。

always 和 unless-stopped 的最大区别,就是那些指定了 --restart unless-stopped 并处于 Stopped (Exited) 状态的容器,不会在 Docker daemon 重启的时候被重启。

下面创建两个新容器,其中“always”容器指定 --restart always 策略,另一个“unless- stopped”容器指定了 --restart unless-stopped 策略:

$ docker container run -d --name always \

--restart always \

alpine sleep 1d

$ docker container run -d --name unless-stopped \

--restart unless-stopped \

alpine sleep 1d

$ docker container ls

CONTAINER ID IMAGE COMMAND STATUS NAMES

3142bd91ecc4 alpine "sleep 1d" Up 2 secs unless-stopped

4f1b431ac729 alpine "sleep 1d" Up 17 secs always两个容器均通过 docker container stop 命令停止,接着重启 Docker。结果“always”容器会重启,但是“unless-stopped”容器不会。

$ docker container stop always unless-stopped

$ docker container ls -a

CONTAINER ID IMAGE STATUS NAMES

3142bd91ecc4 alpine Exited (137) 3 seconds ago unless-stopped

4f1b431ac729 alpine Exited (137) 3 seconds ago always

$ systemlctl restart docker

$ docker container ls -a

CONTAINER CREATED STATUS NAMES

314..cc4 2 minutes ago Exited (137) 2 minutes ago unless-stopped

4f1..729 2 minutes ago Up 9 seconds always注意到“always”容器(启动时指定了 --restart always 策略)已经重启了,但是“unless-stopped”容器(启动时指定了 --restart unless-stopped 策略)并没有重启。

on-failure 策略会在退出容器并且返回值不是 0 的时候,重启容器。就算容器处于 stopped 状态,在 Docker daemon 重启的时候,容器也会被重启。

如果使用 Docker Compose 或者 Docker Stack,可以在 service 对象中配置重启策略,例如:

version: "3.5"

services:

myservice:

<Snip>

restart_policy:

condition: always | unless-stopped | on-failure3)退出容器

用户可以按 Ctrl+d 或输入 exit 命令来退出容器,也可以使用命令 docker container wait CONTAINER[CONTAINER...] 命令来等待容器退出, 并打印退出返回结果。

root@264cf6ed894e:/# exit

exit- 125: Docker daemon执行出错, 例如指定了不支持的Docker命令参数;

- 126: 所指定命令无法执行, 例如权限出错;

- 127: 容器内命令无法找到。

4)后台运行

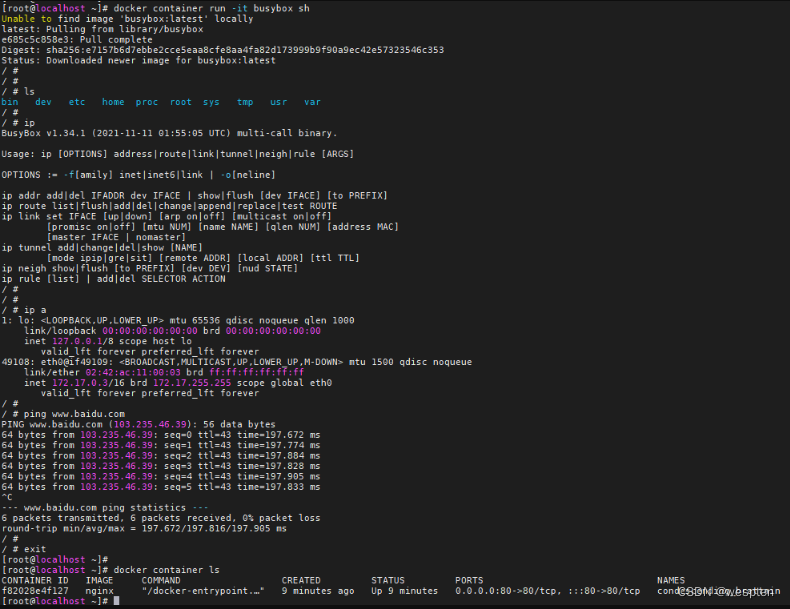

docker container run -it 创建一个容器并进入交互式模式:

➜ ~ docker container run -it busyBox sh

/ #

/ #

/ # ls

bin dev etc home proc root sys tmp usr var

/ # ps

PID USER TIME COMMAND

1 root 0:00 sh

8 root 0:00 ps

/ # exitdocker container exec -it 在一个已经运行的容器里执行一个额外的command:

➜ ~ docker container run -d Nginx

33d2ee50cfc46b5ee0b290f6ad75d724551be50217f691e68d15722328f11ef6

➜ ~

➜ ~ docker container exec -it 33d sh

#

#

# ls

bin boot dev docker-entrypoint.d docker-entrypoint.sh etc home lib lib64 media mnt opt proc root run sbin srv sys tmp usr var

#

# exit

➜ ~

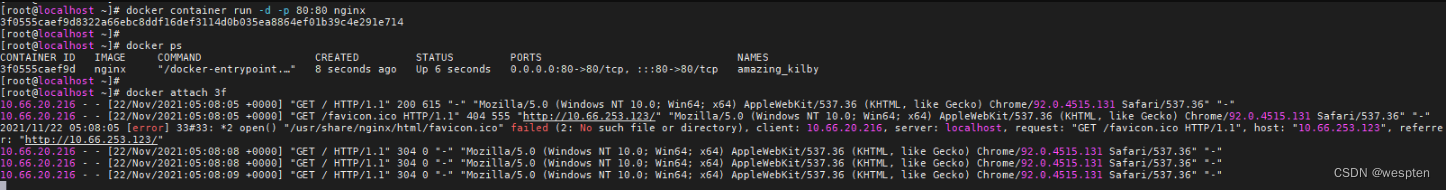

如果需要让容器在后台以守护态(Daemonized) 形式运行,可以通过 -d 参数实现:

# docker run -itd ubuntu /bin/bash -c "while true; do echo hello world; sleep 1; done"

5352f3e531b2f451ec6b484a6d35d1fd064438fa3d3404691b80b98bbc6e7801它会返回一个唯一的id值,使用 docker ps 或 docker container ls 来查看容器信息:

# docker container ls

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

5352f3e531b2 ubuntu "/bin/bash -c 'while…" 2 minutes ago Up 2 minutes lucid_albattani5)查看容器输出

刚才通过 -d 让容器以后台方式运行,我们没有看到它的输出信息,可以使用命令docker [container] logs命令查看,该命令包含以下选项:

- -details: 打印详细信息;

- -f, -follow: 持续实时实时查看日志;

- -since string: 输出从某个时间开始的日志;

- -tail string: 输出最近的若干日志;

- -t, -timestamps:显示时间戳信息;·-until string: 输出某个时间之前的日志。

# docker logs 5352f3e531b2

hello world注:创建容器后会返回一个唯一的id,但一般我们截取字符前面的一部分,保证能认到这个容器就可以了。

6)暂停容器

使用命令docker [container] pause CONTAINER[CONTAINER...]来暂停一个运行中的容器。

# docker run --name test --rm -itd ubuntu bash

c1a52ffc5f662b2e60bcd98fe81157754cb251b22a624e8a6a32785905d5b93e

# docker pause c1a52ffc5

c1a52ffc5

# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

c1a52ffc5f66 ubuntu "bash" 16 seconds ago Up 16 seconds (Paused) test出于 paused 状态的容器就可以使用 docker [container] unpause CONTAINER[CONTAINER...] 命令来恢复了。

7)停止容器

容器正在运行 /bin/bash 应用。当使用 docker container rm <container> -f来销毁运行中的容器时,不会发出任何告警。毫无征兆地被销毁,会令容器和应用猝不及防,来不及“处理后事”。

但是,docker container stop 命令就有礼貌多了,该命令给容器内进程发送将要停止的警告信息,给进程机会来有序处理停止前要做的事情。一旦 docker stop 命令返回后,就可以使用 docker container rm 命令删除容器了。

docker container stop 命令向容器内的 PID 1 进程发送了 SIGTERM 这样的信号,会为进程预留一个清理并优雅停止的机会。如果 10s 内进程没有终止,那么就会收到 SIGKILL 信号,进程起码有 10s 的时间来“解决”自己。

使用命令docker [container] stop [-t|--time[=10]] [CONTAINER...] 停止容器:

# docker stop 5352f3e531b2

5352f3e531b2现在使用命令 docker container prune 会删除所有处于停止状态的容器。

除了 stop 外,使用命令docker [container] kill或在交互模式下通过命令exit或Ctrl+d都可以停止容器。属于停止状态的容器,可以使用命令 docker [container] start 来启动,或者是命令 docker [container] restart 来先停止再启动。

8)进入容器

容器运行过程中,常常需要进入容器中执行操作场景,可使用如下命令进入容器:

attach:使用命令docker attach containerId/names进入容器,但是使用 attach 命令有时候并不方便。当多个窗口同时 attach 到同一个容器的时候,所有窗口都会同步显示,当某个窗口因命令阻塞时,其他窗口也无法执行操作了。注意,进入容器后,如果使用exit退出容器,那么容器也会停止运行,可以使用命令Ctrl+P+Q来退出但不关闭容器。

命令行的输入会直接传到docker容器里面,比如Linux系统中运行容器时输入ctrl+c便会停止容器运行,不推荐使用attach模式。

nsenter:nsenter 启动一个新的shell进程(默认是/bin/bash),同时会把这个新进程切换到和目标(target)进程相同的命名空间,这样就相当于进入了容器内部,nsenter 要正常工作需要有 root 权限。

exec:使用exec命令更加便捷,docker exec -it 775c7c9ee1e1 /bin/bash ,很方便的进入容器。

当容器在后台运行时,使用 docker [container] exec 命令可以进入容器中,支持的参数有:

- -d, --detach: 在容器中后台执行命令;

- --detach-keys="": 指定将容器切回后台的按键;

- -e, --env=[]: 指定环境变量列表;

- -i, --interactive=true|false: 打开标准输入接受用户输入命令, 默认值为false;

- --privileged=true|false: 是否给执行命令以权限, 默认值为false;

- -t, --tty=true|false: 分配伪终端, 默认值为false;

- -u, --user="": 执行命令的用户名或ID。

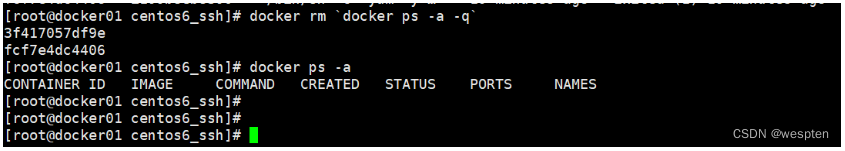

# docker exec -it 5352f3e531b2 /bin/bash9)删除容器

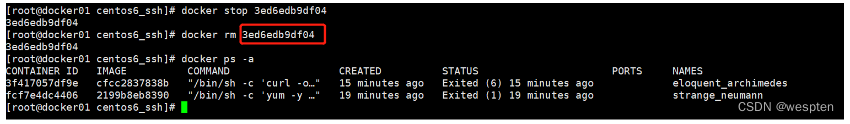

删除容器则是使用命令 docker [container] rm,命令的格式为 docker [container] rm [-f|--force] [-l|--link] [-v|--volumes] CONTAINER [CONTAINER...],支持以下选项:

- -f, --force=false: 是否强制终止并删除一个运行中的容器;

- -l, --link=false: 删除容器的连接, 但保留容器;

- -v, --volumes=false: 删除容器挂载的数据卷

# docker rm -f 5352f3e531b2

5352f3e531b2使用 docker rm 命令只能删除处于停止状态或退出状态的容器,并不能删除还在运行状态中的容器。但是使用选项 -f 可以删除,Docker会先发送SIGKILL信号给容器, 终止其中的应用, 之后强制删除。

10)导出容器

有时我们需要将运行中的容器在不同的机器上拷贝,docker 则实现了容器的导入和导出功能。

导出使用命令为 docker [container] export,命令格式为 docker [container] export [-o|--output[=""]] CONTAINER:

# docker export -o ubuntu.tar 6f71e82ba8b1

[root@CentOS1 ~]# ls

anaconda-ks.cfg dockerfile ubuntu.tar导出后的容器就可以直接复制到其他机器上导入运行了。

11)导入容器

使用命令 docker [container] import 则可以导入容器,格式为 docker import [-c|--change[=[]]] [-m|--message[=MESSAGE]] file|URL|-[REPOSITORY[:TAG]]:

# docker import ubuntu.tar test/ubuntu:v1.0

sha256:6ccd40df1a76c15233708df3446fb97621f05826b2f0e4780aac29f5afaf76a7

# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

test/ubuntu v1.0 6ccd40df1a76 7 seconds ago 69.9MB可以使用docker load命令来导入镜像存储文件到本地镜像库, 也可以使用docker[container]import命令来导入一个容器快照到本地镜像库。

这两者的区别在于: 容器快照文件将丢弃所有的历史记录和元数据信息(即仅保存容器当时的快照状态) ,而镜像存储文件将保存完整记录, 体积更大。 此外, 从容器快照文件导入时可以重新指定标签等元数据信息。

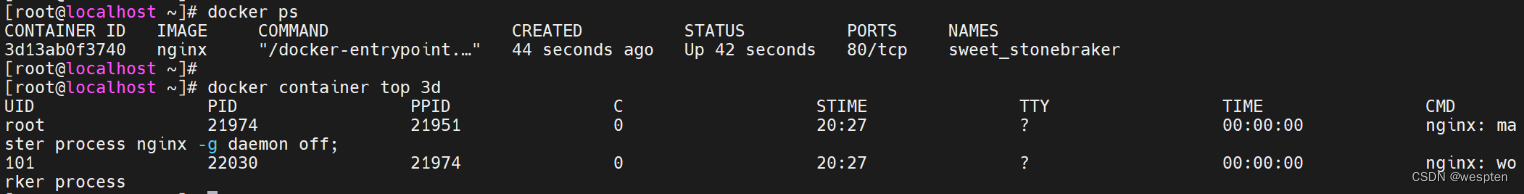

12)查看容器

查看容器有 inspect、ls、top 和 stats 子命令。

使用命令 docker container inspect [OPTIONS] CONTAINER [CONTAINER...] 查看容器详情:

# docker inspect 6f71e82ba8b129e54dd315d79ef4

[

{

"Id": "6f71e82ba8b129e54dd315d79ef4ec49fc3b26cd60102adcebe8b8a39c05dd3f",

"Created": "2019-08-21T13:22:23.432469852Z",

"Path": "/bin/bash"

...

}

]该命令会以 json 格式返回包括容器Id、 创建时间、 路径、 状态、 镜像、 配置等在内的各项信息。

可以使用 docker container ls 命令来观察当前系统正在运行的容器列表:

$ docker container ls

CNTNR ID IMAGE COMMAND CREATED STATUS NAMES

302...74 ubuntu:latest /bin/bash 6 mins Up 6mins sick_montalcini使用命令 docker [container] top [OPTIONS] CONTAINER [CONTAINER...] 查看容器内进程:

# docker container top 6f71e82b

UID PID PPID C STIME TTY TIME CMD

root 16395 16376 0 08:12 pts/0 00:00:00 /bin/bash这个命令类似于Linux系统中的 top 命令, 会打印出容器内的进程信息, 包括PID、 用户、 时间、 命令等:

使用命令 docker[container] stats [OPTIONS] [CONTAINER...] 查看容器统计信息。

- -a, -all: 输出所有容器统计信息, 默认仅在运行中;

- --format string: 格式化输出信息;

- --no-stream: 不持续输出, 默认会自动更新持续实时结果;

- --no-trunc: 不截断输出信息;

13)其他命令

除此之外,docker 容器还支持其他类型的命令,如 cp、diff、port 和 update 子命令。

① cp

该命令支持在容器和主机之间复制文件。命令格式为 docker [container] cp [OPTIONS] CONTAINER: SRC_PATH DEST_PATH|-,支持的选项:

- -a, -archive: 打包模式, 复制文件会带有原始的uid/gid信息;

- -L, -follow-link: 跟随软连接。 当原路径为软连接时, 默认只复制链接信息, 使用该选项会复制链接到的内容。

docker container cp /etc/passwd 6f71e82ba8b1:/tmp/② diff

diff 查看容器内文件系统的变更,格式为 docker[container]diff CONTAINER :

# docker container diff 6f71e82ba8b1

C /tmp

A /tmp/passwd因为上面将文件复制到容器中,所以看到容器的文件系统发生了变化,C 为 改变,A 为追加。

③ port

port 用来查看容器的端口映射情况,命令格式为 docker container port CONTAINER [PRIVATE_PORT [/PROTO]]:

# docker container port 07a4e1582bd1

3306/tcp -> 0.0.0.0:3306④ update

update 可以更新容器运行时配置,命令格式为 docker [container] update [OPTIONS] CONTAINER [CONTAINER...],支持选项有:

- --blkio-weight uint16: 更新块IO限制, 10~1000, 默认值为0, 代表着无限制;

- --cpu-period int: 限制cpu调度器CFS(Completely Fair Scheduler) 使用时间, 单位为微秒, 最小1000;

- --cpu-quota int: 限制cpu调度器CFS配额, 单位为微秒, 最小1000;

- --cpu-rt-period int: 限制cpu调度器的实时周期, 单位为微秒;

- --cpu-rt-runtime int: 限制cpu调度器的实时运行时, 单位为微秒;

- -c, -cpu-shares int: 限制cpu使用份额;

- --cpus decimal: 限制cpu个数;

- --cpuset-cpus string: 允许使用的cpu核, 如0-3, 0, 1;

- --cpuset-mems string: 允许使用的内存块, 如0-3, 0, 1;

- --kernel-memory bytes: 限制使用的内核内存;

- -m, -memory bytes: 限制使用的内存;

- --memory-reservation bytes: 内存软限制;

- --memory-swap bytes: 内存加上缓存区的限制, -1表示为对缓冲区无限制;

- --restart string: 容器退出后的重启策略

比如限制 docker 容器的内存和cpu:

# docker container update -m 1g --memory-swap 1g --cpus 1 6f71e82ba8b1

6f71e82ba8b1四、Docker镜像与仓库管理

1、获取镜像

docker 获取镜像使用的命令为:docker [image] pull NAME[: TAG]。

例如我们获取一个 Ubuntu18.04 系统的基础镜像,就可以使用命令:

docker pull ubuntu:18.04如果不指定版本,默认就拉取最新的版本 ubuntu:latest:

docker pull ubuntu从Quay上拉取镜像:

$ docker pull quay.io/bitnami/ubuntu

Using default tag: latest

latest: Pulling from bitnami/Nginx

2e6370f1e2d3: Pull complete

2d464c695e97: Pull complete

83eb3b1671f4: Pull complete

364c139450f9: Pull complete一般来说,镜像的 latest 表示该镜像内容为最新,出于稳定性考虑,不要在生产中使用最新版本的,最好拉取是带上版本号。

使用docker pull命令下载中会获取并输出镜像的各层信息。 当不同的镜像包括相同的层时, 本地仅存储了层的文份内容, 减少了存储空间。

如果我们要从指定的仓库中拉取,可以通过补全镜像的路径实现,例如从网易上拉取 ubuntu18.04,命令如下:

docker pull hub.c.163.com/public/ubuntu:18.04一般在国内,拉取官方的镜像速度,所以我们可以改成默认从国内云服务供应商的仓库上拉取,比如阿里云的。

# cat /etc/docker/daemon.json

{

"registry-mirrors": ["https://dhq9bx4f.mirror.aliyuncs.com"]

}下载了镜像后,我们就可以使用它了:

# docker run -it ubuntu:18.04 bash

root@fe3ce439f6dc:/# echo "Hello World"

Hello World

root@fe3ce439f6dc:/# exit2、查看镜像

查看镜像主要使用 docker 的 ls、tag、inspect子命令:

1)images 子命令

使用 images 列出所有镜像:

# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

ubuntu 18.04 a2a15febcdf3 5 days ago 64.2MB

redis latest f7302e4ab3a8 5 days ago 98.2MB我们来说明下输出的信息:

- REPOSITORY:来自于哪个仓库, 比如ubuntu表示ubuntu系列的基础镜像;

- TAG:镜像的标签信息, 比如18.04、 latest表示不同的版本信息。 标签只是标记, 并不能标识镜像内容;

- IMAGE ID:镜像的ID(唯⼀标识镜像) , 如果两个镜像的ID相同, 说明它们实际上指向了同一个镜像, 只是具有不同标签名称而已;

- CREATED:创建时间, 说明镜像最后的更新时间;

- SIZE:镜像大小, 优秀的镜像往往体积都较小。

images命令主要支持如下选项:

- -a, --all=true|false: 列出所有(包括临时文件) 镜像文件, 默认为否;

- --digests=true|false: 列出镜像的数字摘要值, 默认为否;

- -f, --filter=[]: 过滤列出的镜像, 如dangling=true只显出没有被使用的镜像; 也可指定带有特定标注的镜像等;

- --format="TEMPLATE": 控制输出格式, 如.ID代表ID信息, .Repository代表仓库信息等;

- --no-trunc=true|false: 对输出结果中太长的部分是否进行截断, 如镜像的ID信息, 默认为是;

- -q, --quiet=true|false: 仅输出ID信息, 默认为否。

$ docker image inspect 94b72494607b

[

{

"Id": "sha256:94b72494607b406caa2e2c0f3d79d6c49fd4d65fd56688ec0171a1f2b356bb2d",

"RepoTags": [

"quay.io/bitnami/Nginx:latest"

],

"RepoDigests": [

"quay.io/bitnami/Nginx@sha256:0caf2be99c1f13a6a5c5c7c38c1e472b413ca62160d3be2cfd0d30d62af7d8f5"

],

"Parent": "",

"Comment": "",

"Created": "2021-11-23T02:18:43.577193295Z",

"Container": "e51d3aaafbf51cd81b13cf1d8ac5f3a733b3ab1e9086f13030d27a9a5f14c503",

"ContainerConfig": {

"Hostname": "e51d3aaafbf5",

"Domainname": "",

"User": "1001",

"AttachStdin": false,

"AttachStdout": false,

"AttachStderr": false,

"ExposedPorts": {

"8080/tcp": {},

"8443/tcp": {}

},

"Tty": false,

"OpenStdin": false,

"StdinOnce": false,

"Env": [

"PATH=/opt/bitnami/common/bin:/opt/bitnami/Nginx/sbin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin",

"HOME=/",

"OS_ARCH=amd64",

"OS_FLAVOUR=debian-10",

"OS_NAME=linux",

"BITNAMI_APP_NAME=Nginx",

"BITNAMI_IMAGE_VERSION=1.21.4-debian-10-r19",

"Nginx_ENABLE_CUSTOM_PORTS=no",

"Nginx_HTTPS_PORT_NUMBER=",

"Nginx_HTTP_PORT_NUMBER="

],

...其中, 还支持对输出结果进行控制的选项, 如-f.--filter=[]、 --notrunc=true|false、 -q、 --quiet=true|false等

2)tag 子命令

[root@CentOS1 ~]# docker tag ubuntu:18.04 myubuntu:18.04

[root@CentOS1 ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

myubuntu 18.04 a2a15febcdf3 5 days ago 64.2MB

ubuntu 18.04 a2a15febcdf3 5 days ago 64.2MB如果细节看的话会发现 ubuntu 和 myubuntu 的 IMAGE ID 是一样的,因为 tag 子命令其实是给原来的镜像添加了别名,内部指向同一个文件,所以删除其中的某一个,只是删除一个链接而已,实际的镜像文件依然存在。

3)inspect 子命令

使用 inspect 子命令来查看镜像的详细信息:docker [image] inspect:

docker inspect ubuntu返回 JSON 格式的消息,如果只要其中一项内容,可以使用 -f 指定:

docker inspect -f {{".Architecture"}} ubuntu4)history 子命令

使用 history 子命令查看镜像的历史命令:

[root@localhost ~]# docker history insaneloafer/hello:1.0

Or

[root@localhost ~]# docker image history insaneloafer/hello:1.0

IMAGE CREATED CREATED BY SIZE COMMENT

e3a733c6921a 24 hours ago /bin/sh -c #(nop) CMD ["python3" "/hello.py… 0B

<missing> 24 hours ago /bin/sh -c #(nop) ADD file:d739451e741e82c2f… 22B

<missing> 24 hours ago /bin/sh -c apt-get update && DEBIAN_FRON… 127MB

<missing> 7 weeks ago /bin/sh -c #(nop) CMD ["bash"] 0B

<missing> 7 weeks ago /bin/sh -c #(nop) ADD file:3a18768000089a105… 80MB3、搜寻镜像

使用 search 子命令可以在仓库中搜寻我们需要的镜像,语法为 docker search [option] keyword,支持的命令选项主要包括:

- -f, --filter filter: 过滤输出内容;

- --format string: 格式化输出内容;

- --limit int: 限制输出结果个数, 默认为25个;

- --no-trunc: 不截断输出结果。

例如我们搜寻名为 Nginx 的镜像:

docker search --limit=4 --filter=starts=4 Nginx4、删除镜像

删除镜像使用 docker rmi 或者 docker images rm,语法为 docker rmi IMAGE[IMAGE...],其中IMAGE可以为标签或ID。支持选项包括:

docker rmi myubuntu:latest当该镜像存在容器时,不能删除镜像,但可以加上 -f 选项强制删除,同时也删除容器。当一个镜像有多个 tag 时,docker rmi 只是删除该镜像的标签,不会影响到镜像文件。

正在运行的container和停止掉但是没有删除的container,不能删除其image:

5、清理镜像

使用Docker一段时间后, 系统中可能会遗留一些临时的镜像文件, 以及一些没有被使用的镜像, 可以通过docker image prune命令来进行清理。支持选项包括:

# docker image prune -f

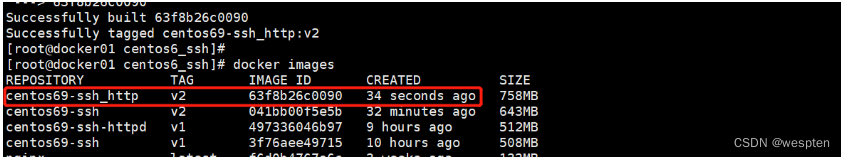

Total reclaimed space: 0B6、创建镜像

创建 docker 镜像的方法有三种:基于已有镜像的容器创建、 基于本地模板导入、 基于Dockerfile创建。

1)基于已有镜像的容器创建

使用命令 docker [container] commit 命令,语法为 docker [container] commit [OPTIONS] CONTAINER [REPOSITORY[: TAG]]。主要选项包括:

- -a, --author="": 作者信息;

- -c, --change=[]: 提交的时候执行Dockerfile指令, 包括CMD|ENTRYPOINT|ENV|EXPOSE|LABEL|ONBUILD|USER|VOLUME|workdir等;

- -m, --message="": 提交消息;

- -p, --pause=true: 提交时暂停容器运行。

下面我们尝试下:首先启动一个镜像,在镜像中做一些修改,之后用修改过的容器创建镜像。

# docker run -it ubuntu:latest bash

root@a93ecdb26b77:/# echo "hello world" > test

root@a93ecdb26b77:/# exit

exit

# docker commit -m "Added test" -a "xingyys" a93ecdb26b77 test

sha256:5f538a96c081d2f64356cd64eb38f7cc0b6987bb07ba283032796c8c7dc2cf2f2)基于本地模板导入

用户也可以直接从一个操作系统模板文件导入一个镜像, 主要使用docker [container] import 命令。

命令格式为 docker [image] import [OPTIONS] file | URL | - [REPOSITORY[: TAG]]:

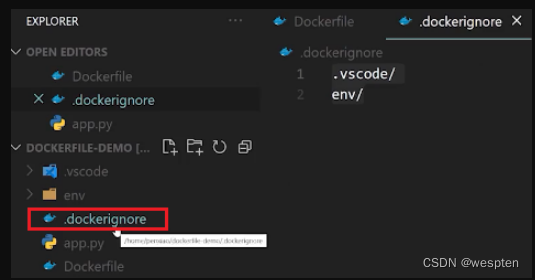

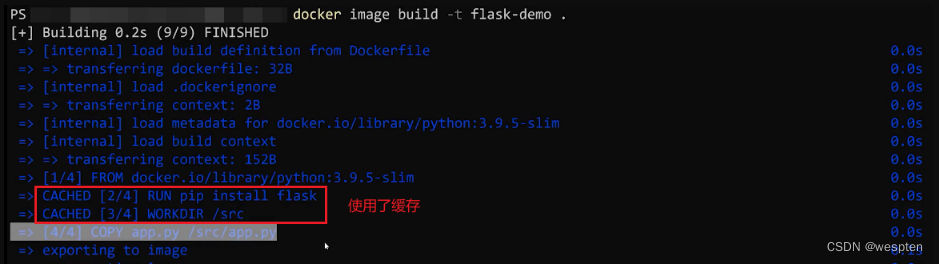

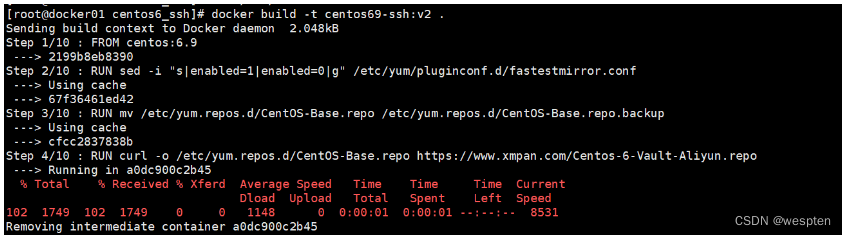

cat ubuntu-18.04-x86_64-minimal.tar.gz | docker import - ubuntu:18.043)基于Dockerfile创建

基于Dockerfile创建是最常见的方式。 Dockerfile是一个文本文件,利用 docker 的指令能快速制作一个镜像。

下面给出一个简单的实例,基于基于debian: stretch-slim镜像安装Python 3环境, 构成一个新的python:3镜像。创建一个 dockerfile 文件,写入:

FROM debian:stretch-slim

LABEL version="1.0" maintainer="docker user <docker_user@github>"

RUN apt-get update && \

apt-get install -y python3 && \

apt-get clean && \

rm -rf /var/lib/apt/lists/*使用docker[image]build命令创建, 编译成功后本地将多出一个python:3镜像:

docker [image] build -t python:3 .7、导出和载入镜像

docker 还提供了镜像的导出和载入。

使用命令 docker [image] save 导出镜像:

docker save -o ubuntu.tar ubuntu导出后的文件就可以复制到其他机器上载入了,对应的载入命令为 docker [image] load :

docker load -i ubuntu.tar或者是:

docker load < ubuntu.tar完整案例:

[root@localhost ~]# docker image ls

REPOSITORY TAG IMAGE ID CREATED SIZE

quay.io/bitnami/Nginx latest 94b72494607b 9 hours ago 90.5MB

busyBox latest 69593048aa3a 5 months ago 1.24MB

localhost:5002/busyBox v1.0 69593048aa3a 5 months ago 1.24MB

Nginx 1.20.0 7ab27dbbfbdf 6 months ago 133MB

[root@localhost ~]#

[root@localhost ~]# docker image save Nginx:1.20.0 -o Nginx.image

[root@localhost ~]#

[root@localhost ~]# ls

agent.jar Desktop Documents initial-setup-ks.cfg Music Nginx.image Public test_db-master Videos

anaconda-ks.cfg D:\JenkinsNode Downloads jenkins MysqL Pictures Templates test.txt

[root@localhost ~]#

[root@localhost ~]# docker image rm 7ab

Untagged: Nginx:1.20.0

Untagged: Nginx@sha256:ea4560b87ff03479670d15df426f7d02e30cb6340dcd3004cdfc048d6a1d54b4

Deleted: sha256:7ab27dbbfbdf4031f0603a4b597cc43031ff883b54f9329f0309c80952dda6f5

Deleted: sha256:5b2a9404d052ae4205f6139190fd4b0921ddeff17bf2aaf4ee97f79e1a8242fe

Deleted: sha256:03ebf76f0cbf5fd32ca010bb589c2139ce7e44c050fe3de2d77addf4cfd25866

Deleted: sha256:0191669d087dce47072254a93fe55cbedd687f27d3798e2260f846e8f8f5729a

Deleted: sha256:17651c6a0ba04d31da14ac6a86d8fb3f600883f9e155558e8aad0b94aa6540a2

Deleted: sha256:5a673ff4c07a1b606f2ad1fc53697c99c45b0675734ca945e3bb2bd80f43feb8

Deleted: sha256:02c055ef67f5904019f43a41ea5f099996d8e7633749b6e606c400526b2c4b33

[root@localhost ~]#

[root@localhost ~]# docker image load -i Nginx.image

02c055ef67f5: Loading layer [==================================================>] 72.53MB/72.53MB

1839f9962bd8: Loading layer [==================================================>] 64.8MB/64.8MB

a2f4f809e04e: Loading layer [==================================================>] 3.072kB/3.072kB

9b63e6289fbe: Loading layer [==================================================>] 4.096kB/4.096kB

f7141923aaa3: Loading layer [==================================================>] 3.584kB/3.584kB

272bc57d3405: Loading layer [==================================================>] 7.168kB/7.168kB

Loaded image: Nginx:1.20.0

[root@localhost ~]#

[root@localhost ~]# docker image ls

REPOSITORY TAG IMAGE ID CREATED SIZE

quay.io/bitnami/Nginx latest 94b72494607b 9 hours ago 90.5MB

busyBox latest 69593048aa3a 5 months ago 1.24MB

localhost:5002/busyBox v1.0 69593048aa3a 5 months ago 1.24MB

Nginx 1.20.0 7ab27dbbfbdf 6 months ago 133MB8、上传镜像

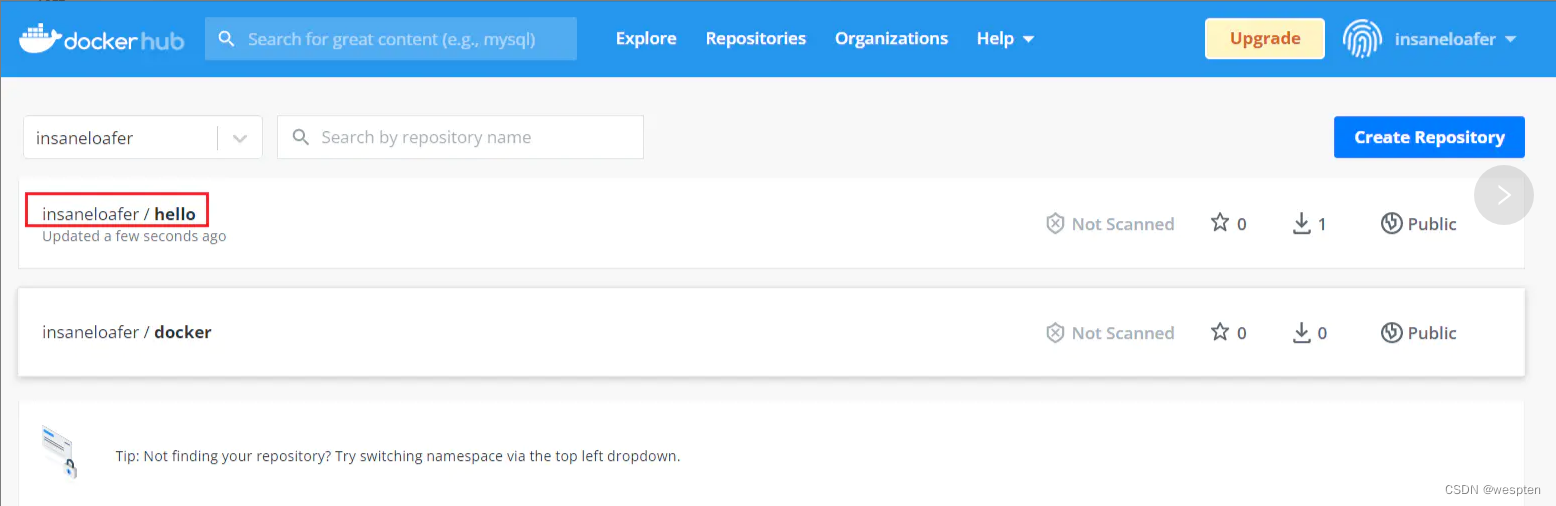

push命令可以让我们将本地的镜像上传到仓库中。默认上传到Docker Hub官方仓库(需要登录)。

格式为: docker [image] push NAME[: TAG]|[REGISTRY_HOST[:REGISTRY_PORT]/]NAME[: TAG] 。

用户在Docker Hub网站注册后可以上传自制的镜像。例如, 用户user上传本地的test: latest镜像, 可以先添加新的标签 user/test: latest, 然后用 docker [image] push命令上传镜像:

# docker tag test:latest user/test:latest

# docker push user/test:latest

The push refers to a repository [docker.io/user/test]

Sending image list

Please login prior to push: Username: Password: Email:第一次上传时, 会提示输入登录信息或进行注册, 之后登录信息会记录到本地~/.docker目录下。

9、公共仓库

仓库(Responsitory)是集中存放镜像的地方,又分公共仓库和私有仓库。有时候容易把仓库与注册服务器(Registry) 混淆。 实际上注册服务器是存放仓库的具体服务器, 一个注册服务器上可以有多个仓库, 而每个仓库下都可以有多个镜像。

Docker Hub 是 docker 官方提供的最大的公共镜像仓库,地址为:Docker Hub

可以使用命令 docker login 来注册和登陆。

使用命令 docker search [IMAGE] 来搜索镜像:

# docker search centos

NAME DESCRIPTION STARS OFFICIAL AUTOMATED

centos The official build of CentOS. 5520 [OK]

ansible/centos7-ansible Ansible on Centos7 122 [OK]

jdeathe/centos-ssh CentOS-6 6.10 x86_64 / CentOS-7 7.6.1810 x86… 111 [OK]上面显示的镜像分为两类:

- 一种是类似于centos这样的基础镜像, 也称为根镜像。 这些镜像是由Docker公司创建、 验证、 支持、 提供, 这样的镜像往往使用单个单词作为名字;

- 另一种类型的镜像, 例如ansible/centos7-ansible镜像, 是由Docker用户ansible创建并维护的, 带有用户名称为前缀, 表明是某用户下的某仓库。 可以通过用户名称前缀“user_name/镜像名”来指定使用某个用户提供的镜像。

使用命令 docker pull [IMAGE] 拉取镜像:

# docker pull centos10、第三方公共镜像

在国内也又一些的公有仓库,我们可以通过配置,让下载镜像的地址指向国内的源。这里选择阿里云,操作步骤如下:

1. 登陆阿里云,点击右上角的“管理中心”,点击进入后,点击“镜像加速器”,得到加速的地址。

2. 配置文件:

# vim /etc/docker/daemon.json

{

"registry-mirrors": ["https://xxxxxx.mirror.aliyuncs.com"]

}3. 重启 docker

# systemctl restart docker11、搭建本地私有仓库

除了以上的公共仓库之外,在需要的时候我们也可以搭建私有的仓库。

安装 docker 后,可以通过官方提供的 registy 镜像来搭建本地私有仓库:

1. 下载镜像:

# docker pull registry 2. 启动镜像:

# docker run -d -p 5000:5000 registry 默认情况下, 仓库会被创建在容器的/var/lib/registry目录下。 可以通过-v参数来将镜像文件存放在本地的指定路径。

3. 管理仓库

通过 docker push命令来上传文件,将镜像上传本地的仓库前需要对镜像作一个特别的tag:

# docker tag cenntos 192.168.127.128:5000/centos

# docker push 172.7.15.113:5000/centos 把标记的镜像给推送到私有仓库,但此时并不会成功,并报错:

Get https://172.7.15.113:5000/v2/: http: server gave HTTP response to HTTPS client# vi /etc/docker/daemon.json

{

"insecure-registries":["192.168.127.128:5000"]

}重启服务,启动仓库容器:

# systemctl restart docker

# docker run container_id现在可以上传镜像了:

# docker push 192.168.127.128:5000/centos 查看上传的镜像:

# curl 192.168.127.128:5000/v2/_catalog 下载镜像:

# docker pull 192.168.127.128:5000/centos注:在客户端中从本地下载镜像需要修改docker的配置文件 /etc/docker/daemon.json。

五、Docker数据卷与文件存储管理

一般容器中管理数据主要有两种方式:

- 数据卷(Data Volumes):容器内数据直接映射到本地主机环境。

- 数据卷容器(Data Volume Containers):使用特定容器维护数据卷。

数据卷(Data Volumes)是一个可供容器使用的特殊目录,它将主机操作系统目录直接映射进容器,类似于Linux中的mount行为。如果直接挂载一个文件到容器,使用文件编辑工具,包括vi或者sed --in-place的时候,可能会造成文件inode的改变。从Docker 1.1.0起,这会导致报错误信息。所以推荐的方式是直接挂载文件所在的目录到容器内。

数据卷是被设计用来持久化数据的,它的生命周期独立于容器,Docker不会在容器被删除后自动删除数据卷,并且也不存在垃圾回收这样的机制来处理没有任何容器引用的数据卷。

1、数据卷

首先我们先来介绍下什么是数据卷:数据卷(Data Volume)是一个可供容器使用的特殊目录,是将主机操作系统目录直接映射进容器,类似于Linux的mount命令。

数据卷可以提供很多很用的特性:

- 数据卷可以在容器之间共享和重用, 容器间传递数据将变得高效与方便;

- 对数据卷内数据的修改会立马生效,无论是容器内操作还是本地操作;

- 对数据卷的更新不会影响镜像, 解耦开应用和数据;

- 卷会一直存在, 直到没有容器使用, 可以安全地卸载它;

1)创建数据卷

使用命令 docker volume create:

# docker volume create -d local test

test

# docker volume list

DRIVER VOLUME NAME

local 9145a9036e96655189d81bd59c16181b1287de6c324cae08d4b5df32778926ff

local ac107675a30b3be115772d545130ddf1ba5fd27bfcb62f93a2a533ad4403b616

local d2760077757c8b9ef48f37a94032ed0f68a847e1fe0a6c84c16bcaba146fe25f

local test默认 volumes 的存放目录为 /var/lib/docker/volumes。

docker volume 支持以下的子命令:

2)绑定数据卷

除了使用 volume 子命令来创建管理数据卷外,还可以使用--mount标记来将数据卷挂载到容器里,正在创建容器是指定本地的任意目录挂载到容器作为数据卷,这也称为绑定数据卷。

在使用 docker [container] run 命令的时候,可以使用选项 --mount 来使用数据卷,它支持三种形式的数据卷:

- volume: 普通数据卷, 映射到主机/var/lib/docker/volumes路径下,格式:

type=bind,source=/path/on/host,destination=/path/in/container - bind: 绑定数据卷, 映射到主机指定路径下,格式:

type=volume,source=my-volume,destination=/path/in/container,volume-label="color=red",volume-label="shape=round" - tmpfs: 临时数据卷, 只存在于内存中,格式 :

type=tmpfs,tmpfs-size=512M,destination=/path/in/container

它们通用的选项有:

- src, source:源路径

- dst, destination, target:目标路径

- ro, readonly:true or false (default),是否只读

# mkdir /webapp

# docker run -d -P --name web --mount type=bind,source=/webapp,destination=/opt/webapp ubuntu

242a073a4f65aa3814c68147b7e3c5706834ac5a13b19d98d0b5c6ff5afa9c70该命令等同于 -v 格式的命令,所以上述的命令等价于:

# docker run -d -P --name web -v /webapp:/opt/webapp ubuntu如果使用的Docker有容器在运行,这里可能会不止一个。但是如果不添加-v参数,当容器停止或者删除时,volume同时也会被删除。

如果要只读挂载就成这样:

# docker run -d -P --name web -v /webapp:/opt/webapp:ro ubuntu本地目录的路径必须是绝对路径, 容器内路径可以为相对路径。 如果目录不存在, Docker会自动创建。

可以使用inspect命令查看指定数据卷的信息:

$ docker volume inspect MysqL-volume

[

{

"CreatedAt":"2019-08-10T05:18:55+08:00",

"Driver":"local",

"Labels":{},

"Mountpoint":"/var/lib/docker/volumes/MysqL-volume/_data",

"Name":"MysqL-volume",

"Options":{},

"Scope":"local"

}

]3)演示

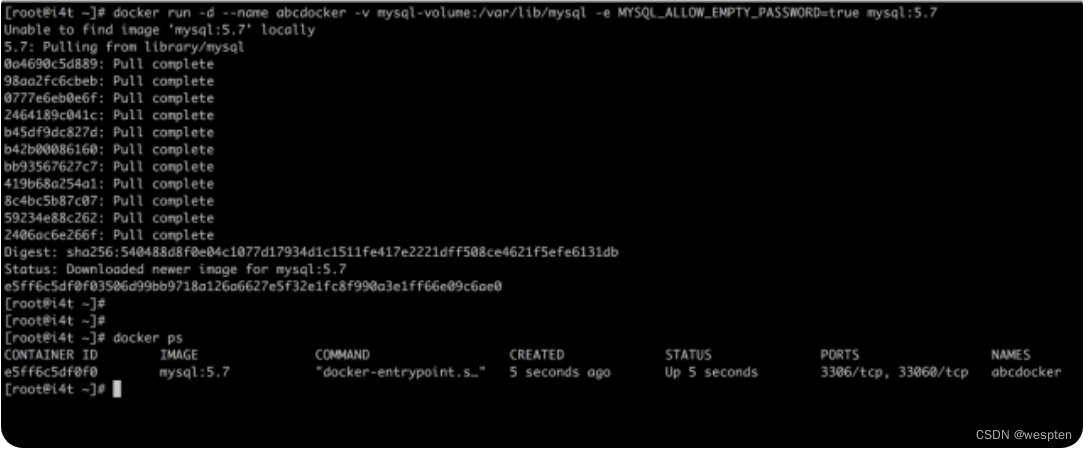

使用MysqL镜像,创建一个名为abcdocker的容器,并加载MysqL-volume数据卷到容器的/var/lib/MysqL目录(因为这个目录就是MysqL默认的存储目录)。

docker run -d --name abcdocker -v MysqL-volume:/var/lib/MysqL -e MysqL_ALLOW_EMPTY_PASSWORD=true MysqL:5.7参数说明:

run 启动并创建容器

-d 后台运行

--name 设置名词

-v 挂载数据卷

-e 设置命令(因为MysqL默认需要设置密码,使用这个变量是可以不设置密码的)

MysqL:5.7为MysqL的镜像版本为我本地并没有下载MysqL的镜像,所以在运行容器的时候会自动帮我们拉取镜像:

我们可以通过inspect查看web容器的详细信息:

$ docker inspect abcdocker

...省略号...

"Mounts":[

{

"Type":"volume",

"Name":"MysqL-volume",

"Source":"/var/lib/docker/volumes/MysqL-volume/_data",

"Destination":"/var/lib/MysqL",

"Driver":"local",

"Mode":"z",

"RW":true,

"Propagation":""

}

],

...省略号...从配置中我们可以看到我们容器挂载了一个名词为MysqL-volume的存储卷,并且挂载到/var/lib/MysqL目录下。

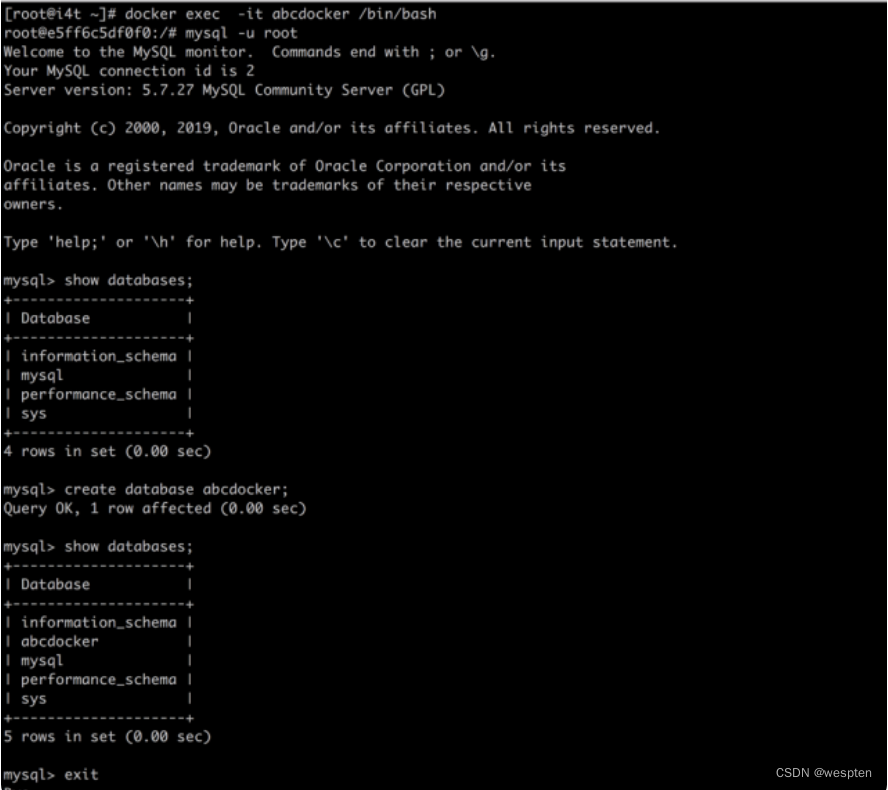

接下来我们可以进入到容器查看:

docker exec-it abcdocker /bin/bash登陆MysqL创建并创建一个数据库名称为abcdocker数据库。

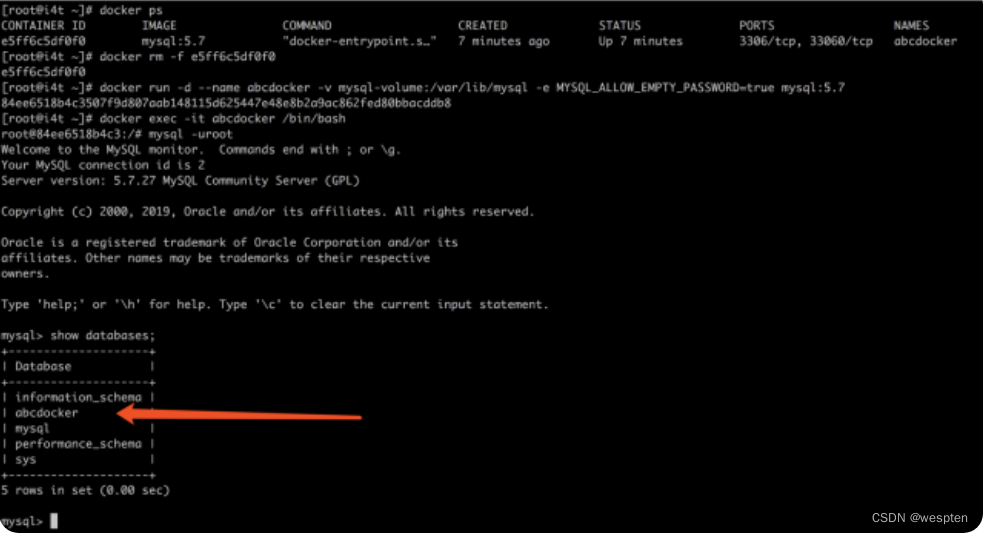

接下来我们可以将容器删除,并从新创建一个,查看是否有为abcdocker:

#删除abcdocker的数据库容器

$ docker rm -f abcdocker

#并创建一个新的

$ docker run -d --name abcdocker -v MysqL-volume:/var/lib/MysqL -e MysqL_ALLOW_EMPTY_PASSWORD=true MysqL:5.7

#查看是否有abcdocker数据库

MysqL> show databases;

+--------------------+

|Database|

+--------------------+

| information_schema |

| abcdocker |

| MysqL |

| performance_schema |

| sys |

+--------------------+

5 rows inset(0.00 sec)

如果需要删除在删除容器同时移除数据卷。可以在删除容器时使用docker rm -v命令。无主的数据卷可能会占用很多空间:

#删除数据卷名称为MysqL-volume命令如下

docker volume rm MysqL-volume

#删除所有数据卷(请谨慎操作)

docker volume prune挂载主机目录Docker持久化存储除了有逻辑卷还有一个是挂载目录:

#挂载一个主机目录作为数据卷,可以使用--mount或者使用-v 指定目录(-v也可以指定数据卷) -p参数为端口映射后面会说

[root@i4t ~]# docker run -d --name abcdocker-Nginx -p 80:80-v /data:/data Nginx

630f0d194583b5e3b547572c018bae1ac78f9341364a2c9eebf4ba898c9bf23e

[root@i4t ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

630f0d194583 Nginx "Nginx -g 'daemon of…"3 seconds ago Up2 seconds 0.0.0.0:80->80/tcp abcdocker-Nginx

[root@i4t ~]# docker exec-it abcdocker-Nginx /bin/bash

root@630f0d194583:/# cd /data/

root@630f0d194583:/data# ls

root@630f0d194583:/data# echo "i4t.com" >abcdocker.txt

root@630f0d194583:/data# exit

exit

[root@i4t ~]# cat /data/abcdocker.txt

i4t.com上面的测试我们是将宿主机的/data目录挂载到容器的/data目录,本地目录的路径必须是绝对路径,如果使用-v参数本地目录不存在Docker会自动创建一个文件夹。这样宿主机和Docker的/data目录数据就同步,相当于NFS挂载。

查看数据卷的具体信息,可以在宿主机使用inspect查看容器信息:

$ docker inspect abcdocker-Nginx

...省略号...

"Mounts":[

{

"Type":"bind",

"Source":"/data",

"Destination":"/data",

"Mode":"",

"RW":true,

"Propagation":"rprivate"

}

],

...省略号...2、数据卷容器

数据卷容器本身也是一个容器,它能为不同的容器提供数据卷,关键命令在于 docker run 的 --volumes-from 选项。

首先创建一个数据卷容器 dbdata,并创建一个数据卷挂载到 /dbdata:

# docker run -itd -v /dbdata --name dbdata ubuntu然后其他容器使用 --volumes-from 来挂载 dbdata 容器中的数据卷:

# docker run -itd --volumes-from dbdata --name db1 ubuntu

# docker run -itd --volumes-from dbdata --name db2 ubuntu此时,容器 db1 和 容器 db2 都挂载同一个数据卷。

选项 --volumes-from 也支持从多个容器挂载多个数据卷:

# docker run -itd --name db3 --volumes-from db1 --volumes-from 8b41042720 ubuntu使用--volumes-from参数所挂载数据卷的容器自己并不需要保持在运用状态。如果删除了挂载的容器(包括dbdata、 db1和db2) , 数据卷并不会被自动删除。 如果要删除一个数据卷, 必须在删除最后一个还挂载着它的容器时显式使用docker rm-v命令来指定同时删除关联的容器。

3、利用数据卷容器来迁移数据

可以利用数据卷对其中的数据卷进行备份和恢复,从而实现数据迁移。

1)备份

使用以下的命令来备份dbdata数据卷容器内的数据卷:

# docker run --volumes-from dbdata -v $(pwd):/backup --name worker --rm ubuntu tar -cvf /backup/backup.tar.gz /dbdata相对复杂点,具体的步骤就是先创建一个 worker 容器,将本地目录挂载进去,使用 --volumes-from 挂载 dbdata 容器的数据卷。容器启动后使用 命令 tar -cvf /backup/backup.tar /dbdata 备份数据到挂载的目录下。选项 --rm 能保证容器执行完命令后自动删除。

2)恢复

如果要恢复到容器,下面的命令:

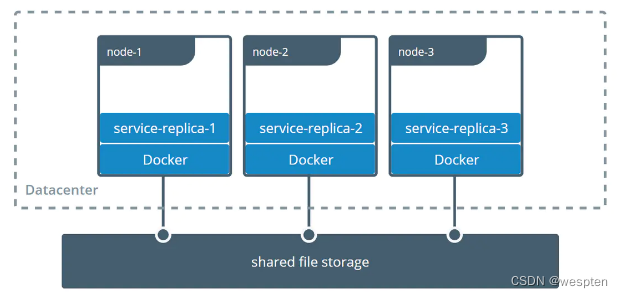

# docker run -it --volumes-from dbdata -v $(pwd):/backup --name recover --rm ubuntu tar -xvf /backup/backup.tar -C /dbdata4、多个机器之间的容器共享数据

sshfs的driver可以让docker使用不在同一台机器上的文件系统做volume。

官方参考链接 https://docs.docker.com/storage/volumes/#share-data-among-machines

Docker的volume支持多种driver,默认创建的volume driver都是local。

$ docker volume inspect vscode

[

{

"CreatedAt": "2021-06-23T21:33:57Z",

"Driver": "local",

"Labels": null,

"Mountpoint": "/var/lib/docker/volumes/vscode/_data",

"Name": "vscode",

"Options": null,

"Scope": "local"

}

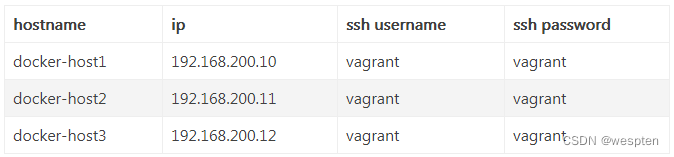

]准备三台Linux机器,之间可以通过SSH相互通信:

安装plugin:

在其中两台机器上安装一个plugin vieux/sshfs。

[vagrant@docker-host1 ~]$ docker plugin install --grant-all-permissions vieux/sshfs

latest: Pulling from vieux/sshfs

Digest: sha256:1d3c3e42c12138da5ef7873b97f7f32cf99fb6edde75fa4f0bcf9ed277855811

52d435ada6a4: Complete

Installed plugin vieux/sshfs[vagrant@docker-host2 ~]$ docker plugin install --grant-all-permissions vieux/sshfs

latest: Pulling from vieux/sshfs

Digest: sha256:1d3c3e42c12138da5ef7873b97f7f32cf99fb6edde75fa4f0bcf9ed277855811

52d435ada6a4: Complete

Installed plugin vieux/sshfs创建volume:

[vagrant@docker-host1 ~]$ docker volume create --driver vieux/sshfs \

-o sshcmd=vagrant@192.168.200.12:/home/vagrant \

-o password=vagrant \