论文核心

是在小样本NER任务中,使用对抗学习,利用对抗学习,使得相近的实体之间的距离减少,拉大无关联的实体之间的距离。

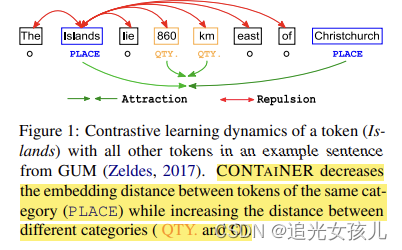

效果表现为:CONTAINER 减少了同一类别(PLACE)的标记之间的嵌入距离,同时增加了不同类别(QTY. 和 O)之间的距离。

CONTAINER tries to decrease the distance of token embeddings of similar entities while increasing it for dissimilar ones (figure 1).这可以使得containNER更高的捕捉到label之间的依赖关系。

创新点

- CONTAINER that Leverages contrastive learning to infer distributional distance of their Gaussian Embeddings.

- the first to Leverage Gaussian Embedding in contrastive learning for Named Entity Recognition.

任务建模

给定一个序列,识别每个token所对应的label。其中,tag schema:使用IO tagging,I-type表示tokens在一个entity内。

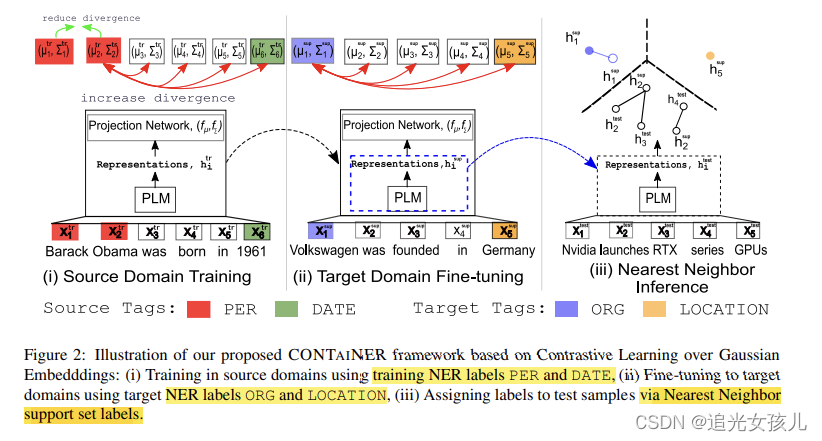

我们首先在source domain中训练我们的模型。接下来,我们使用少量样本支持集(target domain dataset)对模型表示进行微调,以使其适应目标域。 CONTAINER 的训练和微调在算法 1 中进行了说明。最后,我们使用实例级最近邻分类器在测试集中进行推理。

Training in Source Domain:

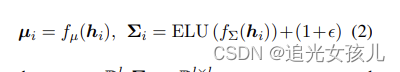

高斯分布计算

映射函数,将token的embedding,映射得到均值和方差。

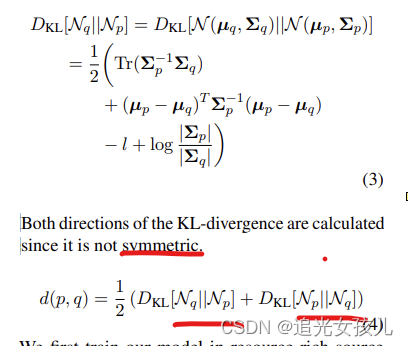

如果两个token的label相同,则认为他们是一对正例,在给出他们高斯分布的基础上,可以计算KL散度。KL散度有方向性。。。。

(21条消息) 正向KL散度与反向KL散度_风吹草地现牛羊的马的博客-CSDN博客_反向kl散度

loss计算

对于label都是p的,p和q实例,损失计算公式是:

Finetuning to Target Domain using Support Set

对于多个shot的条件,采用KL-divergence of the distributions.

对于1-shot的条件,采用欧几里得距离。d 0 (p, q) = ||µp − µq||2

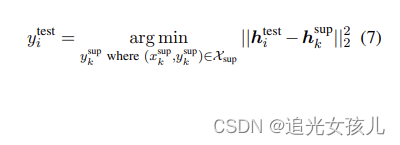

nearest neighbor inference是找到测试集中与dev set中最相近的token,标注的label与dev set中找到的最相近的data的label相同。we assign x test i the same label as the support token that is nearest in the PLM representation space

总结

在对抗学习上,可以使用域迁移。

但是,对抗学习的目标函数,这篇文章和以往不太同,这篇用的是高斯分布的embedding的相似度,之前,好像不这么干,为啥一定要用分布呢。其他的目标函数,应该也能达到“相近实体之间距离尽可能接近,不同类别实体之间距离尽可能加大”的目标吧???

版权声明:本文内容由互联网用户自发贡献,该文观点与技术仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 dio@foxmail.com 举报,一经查实,本站将立刻删除。