OpenAI实在太火了,微软、谷歌等全球科技巨头还有国内一众厂商实在招架不住来势汹汹的攻势,眼看被占领全球市场,全世界的数据在喂养chatgpt,它发育的越来越成熟,越来越懂用户和市场,对其他厂商的威胁也越来越大,大多厂商们研发的产品有不完善,也没上市,难道只能坐以待毙?

因为chatgpt并不是开源项目,怎么样才能有效复现 chatgpt这种完美级别的产品,是所有竞争对手共同面临的最大难题,当下最近便捷的办法就是寻找比较完善的开源方案进行二次修整,已达到自身需求的 。

今晚逛GitHub ,眼前一亮,发现知名开源项目Colossal-AI正在高效跟进chatgpt进行复刻,并快速做出了全世界范围首个开源chatgpt的完整流程,实在是太惊讶了!

Colossal-AI为开源版chatgpt,是全世界最大型的AI解决方案,已经获得开源社区GitHub Star信任,开源版的优势包括:

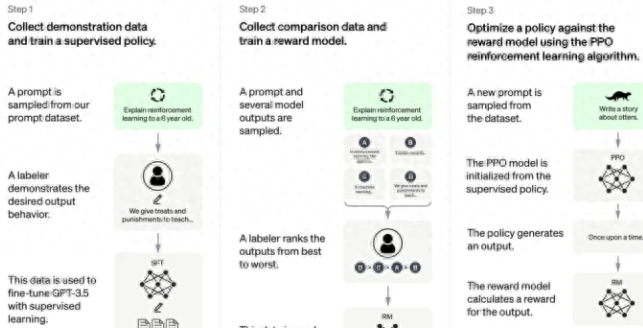

1、基于 PyTorch 的 chatgpt 完整的开源复现, 3个阶段可以完整实现从0开始,预训练模型到发育成熟的 chatgpt 产品;

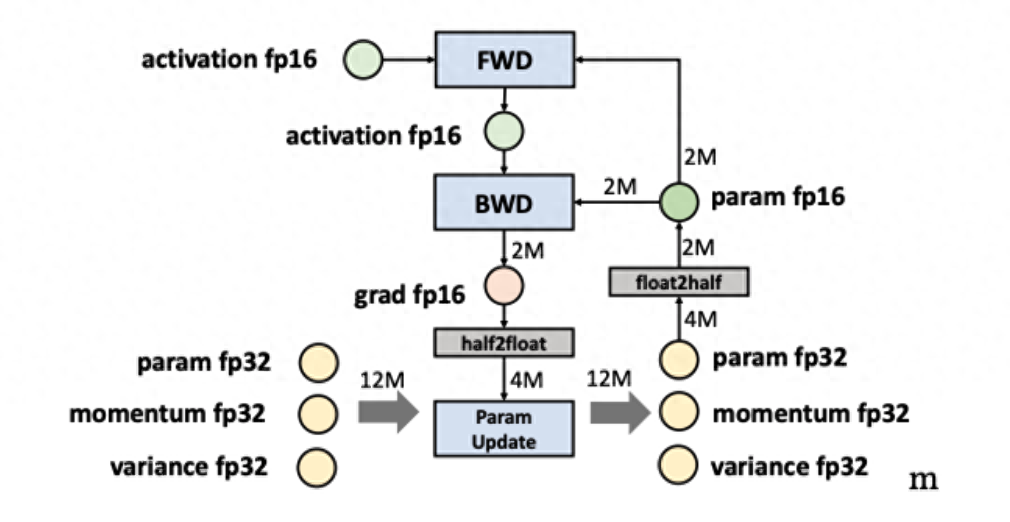

2、对硬件要求低,功耗更低,更节约成本,最小化体验demo进行训练,流程完整走下来最低仅仅需要 1.62GB 显存,特别省硬件,随便一个桌面级GPU即可满足,单卡模型容量。最大话能提升10 倍以上,也就是说我们普通的家用电脑也可以对Colossal-AI进行训练调教;

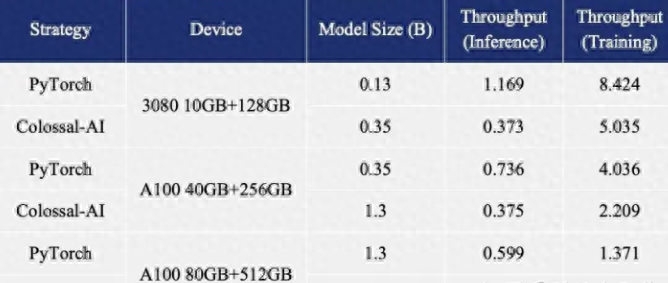

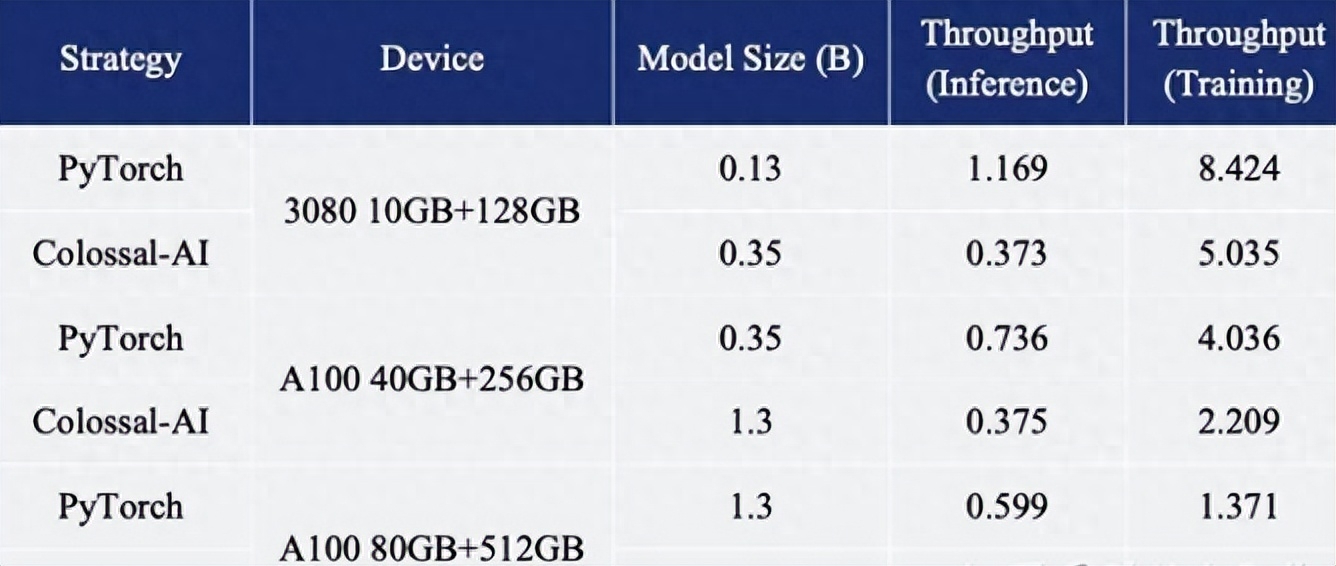

3、跟原生的PyTorch比起来,单机训练速度最高限度能提升7.7倍以上,单卡的推理速度介于1.42 倍,只需一行代码,性能比chatgpt有着全面提升;

4、进行微调任务可最多提升微调模型容量 3.7倍,还是单卡进行,再继续保持高速运行,而这仅需要一行代码即可;

5、能提供不同版本,包括有单卡、单机多卡、1750亿级参数等版本,并且非常支持从HuggingFace 导入模型,包含OPT、GPT-3、BLOOM多种预训练大模型以供训练发育;

6、该项目同时也在吸引着全世界合作开发者共同建立生态化环境。

这个是GitHub 项目开源地址,任何人可以随意下载并使用:

https://github.com/hpcaitech/Co

chatgpt能干什么,毫不客气的说,它让全世界为之震动。它不但可以聊天,还可以写作业、做翻译、做表格、发论文、写代码、修改bug、甚至可以非常精准的代替Google百度等搜索引擎,那么开源版Colossal-AI,在各项测试中性能更是优于chatgpt,并且大幅提升,如果拉长时间线,往后绝对是chatgpt恐怖的竞争对手,甚至颠覆chatgpt,就跟linux系统一样,统治全世界服务器市场。

接下来,全球巨头们,纷纷会使用开源版的Colossal-A系统,或者将自身开发的类chatgpt融入Colossal-A,进行二次开发,Colossal-AI 可以快速低成本的完整复现 chatgpt所有功能,而且降低成本提升效能,实在是太优秀了。

Colossal-AI的诞生为HuggingFace社区的GPT增加了浓墨重彩,为OPT和BLOOM等主流的预训练模型提供了便捷的的 chatgpt复现代码,开箱即用,十分快捷高效。下面以GPT为例,我们只需一行代码,就可以见证奇迹出现,将Colossal-AI指定作为系统策略,就能快速使用。

from chatgpt.nn import GPTActor, GPTCritic, RewardModel

from chatgpt.trainer import PPOTrainer

from chatgpt.trainer.strategies import ColossalAIStrategy

strategy = ColossalAIStrategy(stage=3, placement_policy='cuda')

with strategy.model_init_context():

actor = GPTActor().cuda()

critic = GPTCritic().cuda()

initial_model = deepcopy(actor).cuda()

reward_model = RewardModel(deepcopy(critic.model)).cuda()

trainer = PPOTrainer(strategy, actor, critic, reward_model, initial_model, ...)

trainer.fit(prompts)下列的命令可快速启动多版本:如单卡、单机多卡、1750亿版本训练,并切能快速测试所有的性能指标(比如最大显存占用多少、峰值吞吐率和TFLOPS,太优秀了)

# 使用单机单卡训练GPT2-S,使用最小的batch size,Colossal-AI gemini cpu策略

torchrun --standalone --nproc_pero_node 1 benchmark_gpt_dummy.py --model s --strategy colossalai_gemini_cpu --experience_batch_size 1 --train_batch_size 1

# 使用单机4卡训练GPT2-XL,使用Colossal-AI Zero2策略

torchrun --standalone --nproc_per_node 4 benchmark_gpt_dummy.py --model xl --strategy colossalai_zero2

# 使用4机32卡训练GPT-3,使用Colossal-AI gemini cpu策略

torchrun --nnodes 4 --nproc_per_node 8

--rdzv_id=$JOB_ID --rdzv_backend=c10d --rdzv_endpoint=$HOST_NODE_ADDR

benchmark_gpt_dummy.py --model 175b --strategy colossalai_gemini_cpu --experience_batch_size 1 --train_batch_size 1

Colossal-AI核心系统

虽然能快速低成本复刻chatgpt,但是依然需要依赖面向大模型通用的深度学习系统,基于 PyTorch快速并高效的部署AI,进行大模型训练和推理,才能降低AI大模型应用的成本。

自从在GitHub开源开始,Colossal-AI已多次获得热榜,位列世界第一,并且获得GitHubStar超过八千颗,还成功的入选了PPoPP、SC、CVPR、AAAI 等国际上HPC与AI官方的顶级会议教程。

GitHub开源社区,已经成功的进行了多次新的尝试。比如数据集、完全开放代码、权重的1760亿参数的BLOOM模型等等,总共有全球60个国家和地区参与、也超过250个机构,以及全世界超过1000名的高级研究人员参与完成测试评定,这其中就有谷歌等大厂的员工。而且最近比较大火的开源图文生成模型:StableDiffusion,就是由EleutherAI、StabilityAI、LAION 等项目组织共同参与完成。

所以无论是个人开发者,还是团队,在算力数据和模型等方面均可参与其中大显身手,复现 chatgpt辉煌,合作完善!

感兴趣的个人开发者或团队,可通过下面的方式联系参与Colossal-AI项目:

登录 GitHub,发布issue 或者可以提交PR;加入Colossal-AISlack交流群探讨交流;邮箱联系 contact@hpcaitech.comGitHub开源站地址:https://github.com/hpcaitech/ColossalAI

版权声明:本文内容由互联网用户自发贡献,该文观点与技术仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 dio@foxmail.com 举报,一经查实,本站将立刻删除。